002_具身人工智能的历史演进与关键里程碑:从理论构想到实际应用

002_具身人工智能的历史演进与关键里程碑:从理论构想到实际应用

安全风信子

发布于 2025-11-18 18:42:14

发布于 2025-11-18 18:42:14

1. 具身AI的思想萌芽(1940s-1970s)

具身人工智能的发展可以追溯到人工智能学科的早期阶段,尽管当时还没有明确提出"具身"的概念,但一些先驱者已经开始思考智能与物理实体的关系。

1.1 早期人工智能的局限性

第一代人工智能(1940s-1970s)主要关注符号主义方法,试图通过形式逻辑和符号操作来模拟智能。这一时期的代表成果包括:

- 图灵测试(1950年):Alan Turing提出的判断机器是否具有智能的测试方法

- 通用问题求解器(1957年):Herbert Simon和Allen Newell开发的模拟人类问题解决能力的程序

- 专家系统:基于规则的知识表示系统,如DENDRAL(1965年)

然而,这些早期AI系统主要是纯软件程序,缺乏与物理世界的直接互动能力,因此在处理感知、行动和适应复杂环境等方面存在严重局限性。

1.2 机器人技术的早期发展

与早期AI并行发展的是机器人技术,这为后来的具身AI奠定了物理基础:

- Unimate工业机器人(1959年):George Devol和Joseph Engelberger开发的第一台工业机器人

- Shakey机器人(1966-1972年):由斯坦福研究所开发,是第一个结合了感知、规划和行动能力的移动机器人

- WABOT-1(1973年):日本早稻田大学开发的第一台人形机器人

Shakey机器人被认为是具身AI的早期尝试,它能够通过摄像头感知环境,使用简单的规划算法,然后通过电机驱动执行动作。尽管功能有限,但它展示了将AI能力嵌入物理实体的可能性。

1.3 控制论的影响

控制论(Cybernetics)对具身AI的发展产生了深远影响:

- 诺伯特·维纳的控制论(1948年):提出了通过反馈机制控制系统的理论

- 自适应控制系统:能够根据环境变化调整行为的控制系统

- 生物控制论:研究生物系统中的控制和通信机制

控制论强调系统与环境的互动以及反馈机制的重要性,这些思想后来成为具身AI的核心原则之一。

timeline

title 具身AI思想萌芽时期关键事件

1943 : McCulloch和Pitts提出神经元模型

1948 : 诺伯特·维纳发表《控制论》

1950 : 图灵发表《计算机器与智能》

1956 : 达特茅斯会议,AI正式诞生

1959 : Unimate工业机器人诞生

1966 : Shakey机器人项目启动

1973 : WABOT-1人形机器人开发完成2. 具身认知理论的兴起(1980s-1990s)

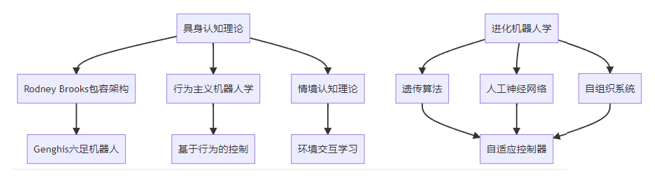

1980年代,随着对早期AI局限性的认识加深,研究者开始从认知科学的角度重新思考智能的本质,具身认知理论逐渐兴起,为具身AI提供了重要的理论基础。

2.1 具身认知理论的核心观点

具身认知理论挑战了传统的认知主义观点,认为:

- 身体在认知中的作用:认知过程不仅仅发生在大脑中,而是与身体结构和感官体验密切相关

- 情境嵌入性:认知活动嵌入在特定的环境和情境中

- 动态生成性:认知是大脑、身体和环境互动的动态生成过程

这一理论的代表人物包括:

- Andy Clark:提出了"延展心智"(Extended Mind)理论

- Alva Noë:强调感知是一种行动能力

- Merleau-Ponty:现象学哲学家,其思想对具身认知产生了重要影响

2.2 从符号主义到具身智能

1980年代,AI研究出现了范式转变,从传统的符号主义方法转向更注重感知和行动的具身方法:

- Rodney Brooks的包容架构(1986年):提出了基于行为的机器人控制架构,强调直接的感知-行动连接

- "No Reason to Represent"论文(1991年):Brooks质疑了传统AI中符号表示的必要性

- 行为主义机器人学:强调通过简单行为的组合产生复杂行为

这一时期的代表性机器人包括:

- Allen和Herbert(1984年):MIT开发的办公室递送机器人

- Genghis(1989年):Brooks开发的六足步行机器人

- COG(1993年):MIT的人形机器人项目,旨在研究具身智能

2.3 进化机器人学的诞生

进化机器人学(Evolutionary Robotics)结合了进化计算和机器人学,为具身AI提供了新的研究方向:

- Hod Lipson的可进化机器人:能够通过进化过程自我设计和改进

- 人工生命研究:模拟生命系统的自组织和适应能力

- 模拟到现实的迁移:在虚拟环境中进化的控制器迁移到物理机器人

进化机器人学强调适应性和自组织,这些特性对于具身AI系统在复杂环境中的生存和发展至关重要。

3. 计算智能与机器人技术的融合(2000s-2010s)

2000年代至2010年代,随着计算能力的提升和机器学习技术的发展,具身AI进入了计算智能与机器人技术深度融合的阶段。

3.1 机器学习在具身AI中的应用

机器学习技术,特别是强化学习,为具身AI提供了强大的学习能力:

- 强化学习在机器人控制中的应用:通过与环境互动学习最优策略

- 模仿学习:从人类示范中学习技能

- 多任务学习:一个模型学习执行多种任务

这一时期的代表性成果包括:

- OpenAI Gym(2016年):为强化学习研究提供标准化环境

- Google DeepMind的AlphaGo(2016年):展示了深度学习在复杂决策中的能力

- Boston Dynamics的Atlas机器人(2013年):具有高度动态平衡和操作能力

3.2 多模态感知系统的发展

具身AI系统的感知能力在这一时期得到了显著提升:

- 计算机视觉的突破:卷积神经网络(CNN)在物体识别、场景理解等任务中取得成功

- 多传感器融合技术:结合视觉、激光雷达、超声波等多种传感器信息

- 三维重建技术:构建环境的三维模型

代表性技术包括:

- Kinect深度相机(2010年):提供实时三维感知能力

- SLAM技术(同步定位与地图构建):如ORB-SLAM(2015年)

- PointNet(2017年):处理点云数据的深度学习架构

3.3 人机交互技术的进步

人机交互技术的进步使具身AI系统能够更好地与人类协作:

- 自然语言处理:使机器人能够理解和生成自然语言

- 手势识别:识别人类手势命令

- 情感计算:识别和响应人类情感

代表性系统包括:

- Siri(2011年):苹果的语音助手,展示了自然语言交互的潜力

- NAO机器人(2006年):能够与人类进行简单交互的人形机器人

- Jibo(2014年):社交机器人,强调与人类的情感连接

# 强化学习在机器人控制中的应用示例

import numpy as np

import tensorflow as tf

from tensorflow.keras import layers, models

import gym

class DQNAgent:

def __init__(self, state_size, action_size):

self.state_size = state_size

self.action_size = action_size

self.memory = []

self.gamma = 0.95 # 折扣因子

self.epsilon = 1.0 # 探索率

self.epsilon_min = 0.01

self.epsilon_decay = 0.995

self.learning_rate = 0.001

self.model = self._build_model()

self.target_model = self._build_model()

self.update_target_model()

def _build_model(self):

# 构建Q网络模型

model = models.Sequential()

model.add(layers.Dense(24, input_dim=self.state_size, activation='relu'))

model.add(layers.Dense(24, activation='relu'))

model.add(layers.Dense(self.action_size, activation='linear'))

model.compile(loss='mse', optimizer=tf.keras.optimizers.Adam(lr=self.learning_rate))

return model

def update_target_model(self):

# 更新目标网络

self.target_model.set_weights(self.model.get_weights())

def remember(self, state, action, reward, next_state, done):

# 存储经验

self.memory.append((state, action, reward, next_state, done))

def act(self, state):

# 选择动作(ε-贪婪策略)

if np.random.rand() <= self.epsilon:

return random.randrange(self.action_size)

act_values = self.model.predict(state)

return np.argmax(act_values[0]) # 返回Q值最大的动作

def replay(self, batch_size):

# 经验回放学习

minibatch = random.sample(self.memory, batch_size)

for state, action, reward, next_state, done in minibatch:

target = reward

if not done:

# 使用目标网络计算Q值

target = reward + self.gamma * np.amax(self.target_model.predict(next_state)[0])

target_f = self.model.predict(state)

target_f[0][action] = target

# 训练主网络

self.model.fit(state, target_f, epochs=1, verbose=0)

if self.epsilon > self.epsilon_min:

self.epsilon *= self.epsilon_decay

# 主函数示例(以CartPole环境为例)

import random

def train_agent(episodes=1000, batch_size=32):

env = gym.make('CartPole-v1')

state_size = env.observation_space.shape[0]

action_size = env.action_space.n

agent = DQNAgent(state_size, action_size)

for e in range(episodes):

state = env.reset()

state = np.reshape(state, [1, state_size])

for time in range(500):

# 选择动作

action = agent.act(state)

# 执行动作

next_state, reward, done, _ = env.step(action)

reward = reward if not done else -10 # 失败时给予惩罚

next_state = np.reshape(next_state, [1, state_size])

# 存储经验

agent.remember(state, action, reward, next_state, done)

state = next_state

if done:

print(f"回合: {e}/{episodes}, 分数: {time}, 探索率: {agent.epsilon:.2}")

break

# 经验回放

if len(agent.memory) > batch_size:

agent.replay(batch_size)

# 每100回合更新目标网络

if e % 100 == 0:

agent.update_target_model()

# 保存模型

agent.model.save("dqn_cartpole_model.h5")

return agent

# 训练机器人控制策略

def train_robot_control():

# 在实际应用中,这里会替换为真实机器人的状态和动作空间

# 例如,使用ROS接口与物理机器人交互

print("训练机器人控制策略...")

# 以下为示例代码框架

# 1. 初始化机器人接口

# robot_interface = RobotInterface()

# 2. 定义状态和动作空间

# state_size = 机器人状态维度

# action_size = 机器人动作维度

# 3. 初始化DQN代理

# agent = DQNAgent(state_size, action_size)

# 4. 训练循环

# for episode in range(num_episodes):

# state = robot_interface.reset()

# total_reward = 0

# for step in range(max_steps):

# action = agent.act(state)

# next_state, reward, done = robot_interface.step(action)

# agent.remember(state, action, reward, next_state, done)

# state = next_state

# total_reward += reward

# if done:

# break

# if len(agent.memory) > batch_size:

# agent.replay(batch_size)

print("机器人控制策略训练框架示例")

if __name__ == "__main__":

# 训练CartPole示例

# agent = train_agent(episodes=1000, batch_size=32)

# 展示机器人控制训练框架

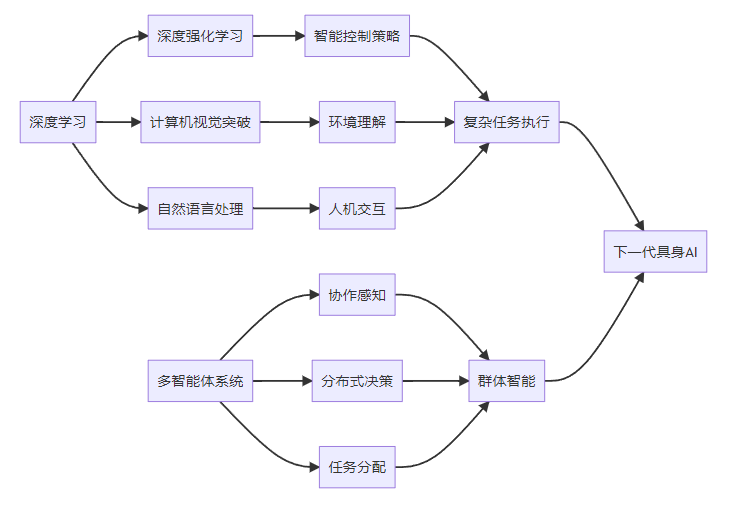

train_robot_control()4. 深度学习时代的具身AI(2010s至今)

2010年代以来,随着深度学习技术的突破,具身AI进入了快速发展阶段,在感知、决策和行动能力方面取得了显著进步。

4.1 深度学习对具身AI的推动

深度学习技术为具身AI带来了革命性变化:

- 深度强化学习:结合深度学习和强化学习,能够从高维原始数据中学习控制策略

- 迁移学习:将在一个任务上学到的知识迁移到新任务

- 元学习:学习如何学习,使系统能够快速适应新环境

代表性成果包括:

- DQN算法(2015年):DeepMind的深度Q网络,将深度学习应用于强化学习

- AlphaGo Zero(2017年):完全通过自我对弈学习围棋

- OpenAI Five(2018年):能够在Dota 2游戏中击败职业选手的AI系统

4.2 感知能力的飞跃

深度学习极大提升了具身AI的感知能力:

- 图像识别技术:如ResNet(2015年)在图像分类任务中取得突破性进展

- 目标检测算法:如YOLO系列(2016年起)提供实时目标检测能力

- 语义分割:如U-Net(2015年)能够精确分割图像中的对象

这些技术使具身AI系统能够更准确地理解周围环境,为决策和行动提供可靠的输入。

4.3 机器人操作与灵巧性的提升

在机器人操作和灵巧性方面,具身AI也取得了显著进展:

- 抓取学习:通过深度学习学习物体抓取策略

- 操作技能迁移:将虚拟环境中学到的技能迁移到物理机器人

- 多模态操作:结合视觉、触觉等多种感知模态进行操作

代表性研究包括:

- Google的Robotics Transformer(2022年):结合Transformer架构和机器人控制

- OpenAI的Dactyl(2018年):能够灵巧操作物体的机器人手

- Boston Dynamics的Pick and Place系统(2020年):展示了高精度物体操作能力

4.4 多智能体系统与协作

多智能体系统研究使多个具身AI能够协作完成复杂任务:

- 分布式感知与决策:多个智能体共同感知环境并做出决策

- 协作任务分配:合理分配任务以提高整体效率

- 社交智能:智能体之间的有效沟通和协作

代表性系统包括:

- Swarm Robotics:模仿昆虫群体行为的机器人集群

- MIT的RACECAR平台(2017年):用于多智能体协同研究

- OpenAI的Coordinated Reinforcement Learning(2019年):多智能体强化学习研究

5. 2025年具身AI的前沿发展

2025年,具身AI技术已经达到了新的高度,在多个前沿领域取得了突破性进展。

5.1 神经形态计算的应用

神经形态计算技术为具身AI带来了能效和认知能力的双重提升:

- 低功耗边缘计算:神经形态芯片如Intel Loihi 2提供极高的能效比

- 实时处理能力:毫秒级响应时间,满足实时控制需求

- 自学习能力:硬件层面支持在线学习和适应

神经形态计算在具身AI中的应用案例:

- 自适应机器人控制系统:根据环境变化自动调整控制参数

- 实时异常检测:在边缘设备上实现高性能异常行为识别

- 低功耗持久任务:长续航的环境监测和巡逻任务

5.2 量子安全技术在具身AI中的应用

量子安全技术为具身AI系统提供了更高级别的安全保障:

- 量子密钥分发:确保通信安全,防止窃听

- 量子随机数生成:提供真正的随机数,增强加密强度

- 后量子密码学:抵抗量子计算攻击的加密算法

这些技术在关键领域的具身AI系统中得到应用,如医疗机器人、自动驾驶汽车和工业控制系统。

5.3 可解释AI与安全验证

2025年,具身AI系统在可解释性和安全验证方面取得了重要进展:

- 可解释AI技术:使AI决策过程更加透明和可理解

- 形式化验证方法:数学证明AI系统的安全属性

- 安全约束学习:在学习过程中内置安全约束

这些技术对于高风险应用场景中的具身AI系统至关重要,能够确保系统在各种情况下都能安全可靠地运行。

5.4 零信任安全架构在具身AI中的实施

零信任安全架构已经成为具身AI系统的安全标准:

- 持续身份验证:对所有访问请求进行持续验证

- 最小权限原则:严格限制每个组件的权限范围

- 微分段:网络微分段,限制横向移动

- 实时监控与响应:持续监控系统行为,及时响应安全事件

零信任架构特别适合具身AI系统的复杂网络环境,能够有效防御各种高级威胁。

# 零信任安全架构在具身AI系统中的应用示例

import hashlib

import time

import json

from cryptography.fernet import Fernet

class ZeroTrustSecurityManager:

def __init__(self):

# 初始化安全管理器

self.key = Fernet.generate_key()

self.cipher = Fernet(self.key)

self.access_control_policies = {}

self.authentication_logs = []

self.activity_monitor = {}

def register_component(self, component_id, component_type, required_privileges):

"""注册具身AI系统组件"""

print(f"注册组件: {component_id} (类型: {component_type})")

# 为组件分配唯一标识符和证书

component_certificate = self._generate_certificate(component_id)

# 定义访问控制策略

self.access_control_policies[component_id] = {

'type': component_type,

'privileges': required_privileges,

'certificate': component_certificate,

'last_authenticated': None,

'trust_score': 100.0 # 初始信任分数

}

# 初始化活动监控

self.activity_monitor[component_id] = {

'last_activity_time': time.time(),

'action_count': 0,

'anomaly_count': 0

}

return component_certificate

def _generate_certificate(self, component_id):

"""生成组件证书"""

timestamp = str(time.time())

data = f"{component_id}:{timestamp}:secure_component"

certificate = hashlib.sha256(data.encode()).hexdigest()

return certificate

def authenticate_request(self, component_id, certificate, request_type, target_resource):

"""验证请求并实施零信任策略"""

# 1. 身份验证

if component_id not in self.access_control_policies:

print(f"认证失败: 未知组件 {component_id}")

return False, "未知组件"

if self.access_control_policies[component_id]['certificate'] != certificate:

print(f"认证失败: 证书不匹配 {component_id}")

# 降低信任分数

self.access_control_policies[component_id]['trust_score'] -= 20

return False, "证书不匹配"

# 2. 权限验证

required_privilege = self._get_required_privilege(request_type, target_resource)

if required_privilege not in self.access_control_policies[component_id]['privileges']:

print(f"认证失败: 权限不足 {component_id} 请求 {request_type} 资源 {target_resource}")

return False, "权限不足"

# 3. 行为分析

if not self._analyze_component_behavior(component_id, request_type, target_resource):

print(f"认证失败: 异常行为检测 {component_id}")

return False, "异常行为"

# 4. 更新信任状态

self.access_control_policies[component_id]['last_authenticated'] = time.time()

# 小幅提高信任分数

if self.access_control_policies[component_id]['trust_score'] < 100:

self.access_control_policies[component_id]['trust_score'] += 5

# 记录认证日志

self.authentication_logs.append({

'timestamp': time.time(),

'component_id': component_id,

'request_type': request_type,

'target_resource': target_resource,

'status': 'success'

})

# 更新活动监控

self.activity_monitor[component_id]['last_activity_time'] = time.time()

self.activity_monitor[component_id]['action_count'] += 1

print(f"认证成功: {component_id} 访问 {target_resource}")

return True, "认证成功"

def _get_required_privilege(self, request_type, target_resource):

"""获取请求所需的权限"""

# 简化示例,实际系统中可能更复杂

privilege_map = {

'read': f'read_{target_resource}',

'write': f'write_{target_resource}',

'execute': f'execute_{target_resource}'

}

return privilege_map.get(request_type, 'unknown_privilege')

def _analyze_component_behavior(self, component_id, request_type, target_resource):

"""分析组件行为是否存在异常"""

# 简化的行为分析逻辑

# 实际系统中可能使用机器学习进行异常检测

current_time = time.time()

last_activity = self.activity_monitor[component_id]['last_activity_time']

# 检查活动频率是否异常高

if current_time - last_activity < 0.01: # 10ms内多次请求

self.activity_monitor[component_id]['anomaly_count'] += 1

if self.activity_monitor[component_id]['anomaly_count'] > 5:

return False

# 检查请求模式是否异常

if request_type == 'execute' and target_resource == 'control_system':

# 高敏感度操作,需要额外验证

trust_score = self.access_control_policies[component_id]['trust_score']

if trust_score < 80:

return False

return True

def encrypt_communication(self, message, sender_id, receiver_id):

"""加密组件间通信"""

# 添加元数据

message_data = {

'timestamp': time.time(),

'sender': sender_id,

'receiver': receiver_id,

'message': message

}

# 序列化为JSON

json_data = json.dumps(message_data)

# 加密数据

encrypted_data = self.cipher.encrypt(json_data.encode())

return encrypted_data

def decrypt_communication(self, encrypted_data, receiver_id):

"""解密组件间通信"""

try:

# 解密数据

decrypted_data = self.cipher.decrypt(encrypted_data)

# 反序列化为JSON

message_data = json.loads(decrypted_data.decode())

# 验证接收者

if message_data['receiver'] != receiver_id:

print(f"解密失败: 接收者不匹配 {receiver_id}")

return None

# 验证消息时效性(简化示例)

current_time = time.time()

if current_time - message_data['timestamp'] > 60: # 消息超过60秒视为过期

print(f"解密失败: 消息已过期")

return None

return message_data

except Exception as e:

print(f"解密失败: {str(e)}")

return None

def monitor_system_health(self):

"""监控系统健康状态"""

current_time = time.time()

issues = []

for component_id, info in self.activity_monitor.items():

# 检查组件是否活跃

if current_time - info['last_activity_time'] > 300: # 5分钟无活动

issues.append(f"组件 {component_id} 可能离线")

# 检查信任分数

trust_score = self.access_control_policies[component_id]['trust_score']

if trust_score < 50:

issues.append(f"组件 {component_id} 信任分数过低: {trust_score}")

return issues

# 使用示例

def demonstrate_zero_trust_architecture():

# 初始化零信任安全管理器

security_manager = ZeroTrustSecurityManager()

# 注册具身AI系统组件

print("===== 注册系统组件 =====")

perception_cert = security_manager.register_component(

'perception_module',

'sensor_processor',

['read_camera', 'read_lidar', 'write_perception_data']

)

decision_cert = security_manager.register_component(

'decision_module',

'ai_processor',

['read_perception_data', 'write_action_plan', 'execute_control_system']

)

actuation_cert = security_manager.register_component(

'actuation_module',

'controller',

['read_action_plan', 'execute_motors']

)

# 演示正常认证流程

print("\n===== 演示正常认证流程 =====")

auth_success, msg = security_manager.authenticate_request(

'perception_module',

perception_cert,

'read',

'camera'

)

print(f"认证结果: {auth_success}, 消息: {msg}")

# 演示权限不足情况

print("\n===== 演示权限不足情况 =====")

auth_fail, msg = security_manager.authenticate_request(

'perception_module',

perception_cert,

'execute',

'control_system'

)

print(f"认证结果: {auth_fail}, 消息: {msg}")

# 演示加密通信

print("\n===== 演示加密通信 =====")

message = "检测到障碍物,距离2.5米"

encrypted_msg = security_manager.encrypt_communication(

message,

'perception_module',

'decision_module'

)

print(f"加密消息: {encrypted_msg}")

# 解密通信

decrypted_data = security_manager.decrypt_communication(

encrypted_msg,

'decision_module'

)

if decrypted_data:

print(f"解密成功,原始消息: {decrypted_data['message']}")

# 演示系统健康监控

print("\n===== 演示系统健康监控 =====")

issues = security_manager.monitor_system_health()

if issues:

print("检测到问题:")

for issue in issues:

print(f"- {issue}")

else:

print("系统健康状态良好")

if __name__ == "__main__":

demonstrate_zero_trust_architecture()6. 具身AI发展的关键里程碑总结

通过梳理具身AI的发展历程,我们可以识别出几个关键的里程碑,这些里程碑不仅代表了技术的进步,也反映了人们对智能本质认识的深化。

6.1 理论基础与概念形成(1940s-1980s)

这一阶段的关键里程碑包括:

- 控制论的提出(1948年):诺伯特·维纳的《控制论》为研究系统与环境互动奠定了理论基础

- Shakey机器人(1966-1972年):第一个结合感知、规划和行动的移动机器人

- Rodney Brooks的包容架构(1986年):挑战了传统AI的符号主义方法,强调基于行为的控制

6.2 具身认知革命(1980s-1990s)

这一阶段的关键里程碑包括:

- "No Reason to Represent"论文(1991年):Brooks质疑传统AI中符号表示的必要性

- COG项目(1993年):MIT的人形机器人项目,旨在研究具身智能

- 进化机器人学的兴起:结合进化计算和机器人学,探索适应性和自组织能力

6.3 计算智能融合(2000s-2010s)

这一阶段的关键里程碑包括:

- 强化学习在机器人控制中的应用(2000s):为机器人提供了从经验中学习的能力

- 多传感器融合技术的发展(2000s):提升了机器人的感知能力

- SLAM技术的成熟(2010s):如ORB-SLAM(2015年),使机器人能够在未知环境中导航

- Boston Dynamics机器人(2010s):展示了卓越的动态平衡和操作能力

6.4 深度学习时代(2010s至今)

这一阶段的关键里程碑包括:

- DQN算法(2015年):DeepMind将深度学习应用于强化学习

- 计算机视觉的突破(2010s):如ResNet(2015年)、YOLO系列(2016年起)

- 机器人灵巧操作能力的提升(2020s):如OpenAI的Dactyl、Google的Robotics Transformer

- 神经形态计算的应用(2020s):如Intel Loihi系列芯片在具身AI中的应用

- 量子安全技术的集成(2020s):为具身AI系统提供更高级别的安全保障

7. 具身AI发展的启示与未来展望

通过回顾具身AI的发展历程,我们可以得到一些重要启示,并展望未来的发展方向。

7.1 发展启示

具身AI的发展历程带给我们的启示包括:

- 跨学科融合的重要性:具身AI的进步得益于AI、认知科学、机器人学、控制论等多学科的融合

- 理论与实践的相互促进:理论突破推动技术进步,技术实践又深化理论认识

- 硬件与软件协同发展:硬件技术(如传感器、计算芯片)的进步与软件算法的创新同等重要

- 安全与伦理问题需提前考虑:随着具身AI能力的提升,安全和伦理问题日益凸显

7.2 未来发展趋势

具身AI未来的发展趋势可能包括:

- 更高级的感知能力:多模态融合、超分辨率感知、情境感知等

- 更智能的决策系统:结合常识推理、因果推理、可解释AI等技术

- 更强的适应性和学习能力:终身学习、元学习、自主进化等

- 更深入的人机融合:脑机接口、增强现实等技术的应用

- 更广泛的应用场景:从工业、医疗到家庭、教育等各个领域

7.3 面临的挑战

具身AI的发展仍然面临诸多挑战:

- 计算资源与能效平衡:在有限的计算资源下实现复杂的智能功能

- 安全与隐私保护:确保具身AI系统不会对人类和环境造成伤害,保护用户隐私

- 伦理与法规框架:建立适合具身AI特点的伦理准则和法律法规

- 可解释性与透明度:使具身AI的决策过程更加透明和可理解

- 复杂环境适应能力:在未知、动态、复杂的环境中保持稳定可靠的性能

8. 总结

具身人工智能的发展历程是一个从理论构想到实际应用的过程,也是人们对智能本质认识不断深化的过程。从早期的控制论思想,到具身认知理论的兴起,再到计算智能与机器人技术的融合,直至今天深度学习时代的快速发展,具身AI在感知、决策和行动能力方面不断取得突破。

2025年,随着神经形态计算、量子安全等前沿技术的应用,具身AI系统在能效、安全性和智能水平方面已经达到了新的高度。然而,挑战依然存在,需要我们在技术创新的同时,关注安全、伦理和社会影响等方面的问题。

回顾具身AI的发展历程,我们可以看到,这一领域的进步不仅依赖于技术的突破,更依赖于跨学科的融合和对智能本质的深入理解。未来,随着更多前沿技术的应用和更多学科的参与,具身AI有望在各个领域发挥更大的作用,为人类社会创造更多价值。

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2025-11-12,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录