为什么给机器人装上昂贵的触觉传感器,反而让它变笨了?

- 论文标题:Multi-Modal Manipulation via Policy Consensus

- 论文链接:https://arxiv.org/pdf/2509.23468

- 主页链接:https://policyconsensus.github.io/

为什么特征拼接 (Feature Concatenation)会在机器人感知和决策中失效?

想象一下,你在黑漆漆的背包里找钥匙。你的眼睛此时毫无用处,全靠指尖的触觉,这对你来说轻而易举 ,但在机器人领域,这却是一个非常困难的问题。

残酷的真相: 目前的机器人学习主流的多传感器融合的算法(Feature Concatenation)在处理这种任务时彻底失败了。我们的实验数据显示,当你给机器人加上触觉数据试图让它更聪明时,它的抓取成功率竟然从 35% 暴跌至 5%!为什么? 因为传统的方法把偶尔出现的关键触觉信号当作了 “噪音” 直接过滤掉了。

当前方法的局限性

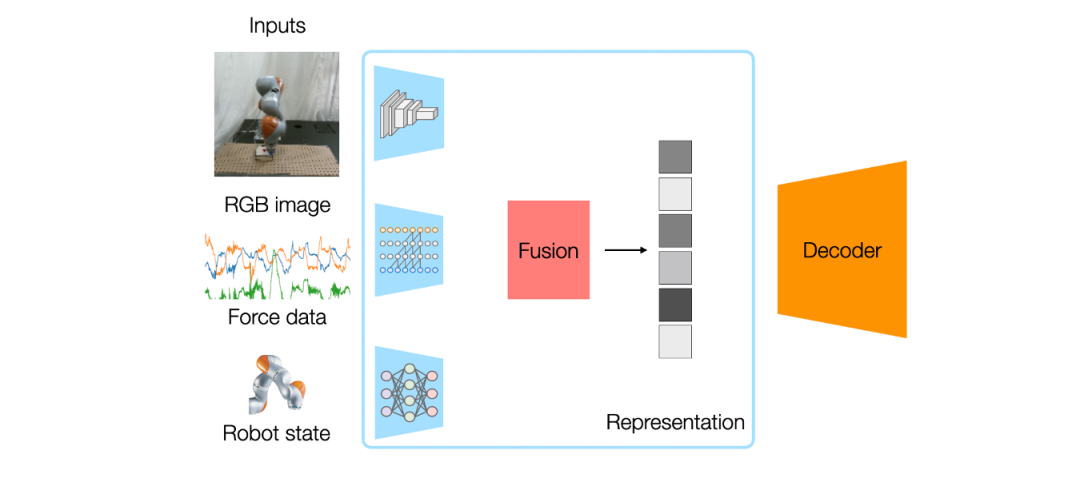

目前的多模态机器人学习方法通常使用特征拼接 (Feature Concatenation):提取所有传感器的嵌入 (embeddings),将其拼接成一个大向量,然后输入到一个单一的神经网络策略中 。

这种方法看似合理,但存在两个根本缺陷:

问题 1:稀疏模态被视为噪声

- 例如,一个机器人从不透明袋子中取记号笔的任务。90% 的过程中依靠视觉接近,但一旦进入袋子,视觉变得无用,触觉变得至关重要 。

- 特征拼接会将统计上罕见的信号(触觉)视为噪声。在训练中,网络会降低触觉信息的权重,专注于总是活跃的视觉特征 。

- 我们的实验结果:在遮挡抓取任务中,RGB + 触觉的拼接基线仅达到 5% 的成功率,而仅使用 RGB 却有 35%。增加触觉信息反而因其被视为干扰噪声而降低了性能!

问题 2:无法灵活添加或移除模态

- 特征拼接缺乏模块化。如果想添加新传感器或移除故障传感器,必须从头开始重新训练整个策略,因为所有模态在特征层面紧密耦合 。

- 这导致了昂贵的重训练成本,且系统在单个传感器故障时会发生灾难性故障 。

我们的解决方案:组合策略 (Compositional Policies)

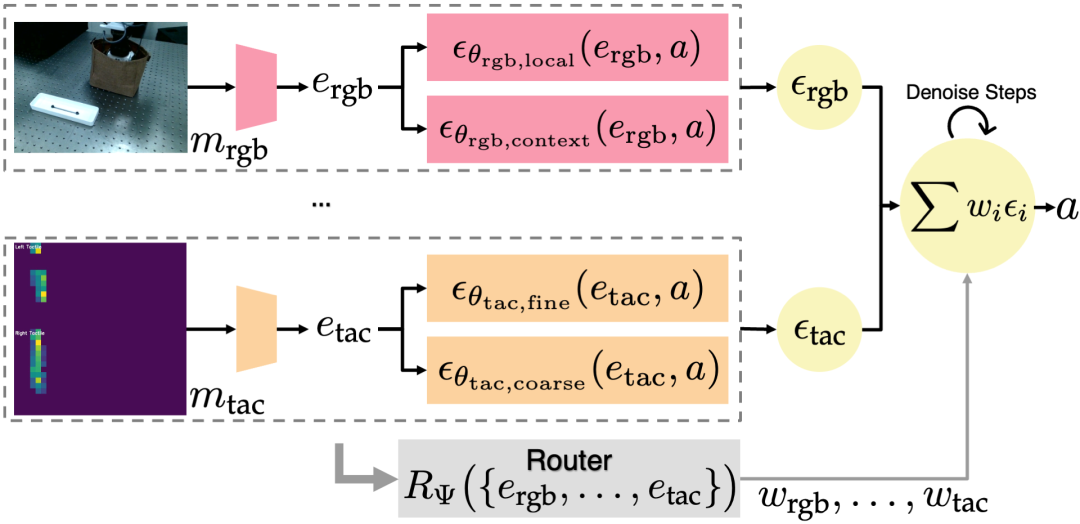

我们的解决方案是重新思考模态的结合方式。我们不将所有传感器强制输入单一网络,而是为每个模态训练单独的专家策略,并学习如何在策略层面组合它们的动作预测 。

工作原理

- 模态特定专家 (Modality-Specific Experts):为每个感官模态(RGB、触觉、点云等)训练作为扩散策略实例化的基于能量的策略表示 。每个专家专注于自己的感官流,互不干扰 。即使是 “稀疏” 模态(如触觉)也有自己的专用网络,使其能高度专注于接触动力学 。

- 模态内分解 (Intra-Modality Factorization):在模态内部进一步分解为互补的子策略。例如,视觉可分为粗略几何推理和细粒度细节;触觉可分为初始接触检测和持续力控制 。

- 学习共识权重 (Learn Consensus Weights):一个路由器网络 (Router) 学习预测共识权重,决定每个模态对最终动作的影响程度 。

组合式策略框架概述

为什么这能解决问题

解决稀疏性:每个专家学习自己的动作分布,互不干扰。触觉专家不再与视觉竞争表示模型的表征能力,从而在富含接触的操作中变得高度专业化。

模块化设计:专家是独立训练的。添加新传感器只需训练一个新的专家,并使用固定权重或快速微调将其与现有专家组合,无需重训练整个系统 。

简单的实现(implementation)方式:组合多个策略对应于概率分布相乘,在扩散模型(基于分数的能量模型)中,这等同于简单的分数函数相加 (summing score functions) 。

增量学习:即插即用的传感器

为了展示模块化,我们完全独立地训练了 RGB 和触觉策略,然后使用固定的相等权重将它们组合,没有进行任何联合训练。

- 尽管从未一起训练,组合后的策略成功完成了单独策略都无法处理的遮挡记号笔抓取任务 。这对于现实世界的部署(传感器逐步添加或更换)具有深远的意义 。

鲁棒性与自适应性

运行时扰动:在执行过程中突然抢走物体,机器人能适应并完成任务。

传感器损坏:遮挡一个摄像头模拟故障,路由器简单地将权重转移到剩余的功能传感器上,表现保持稳定。

物体重新定位:移动任务相关物体,策略能成功泛化。

统计结果对比

我们使用了配备双 RealSense 摄像头和 FlexiTac 触觉传感器的 UR5e 机器人进行验证 。

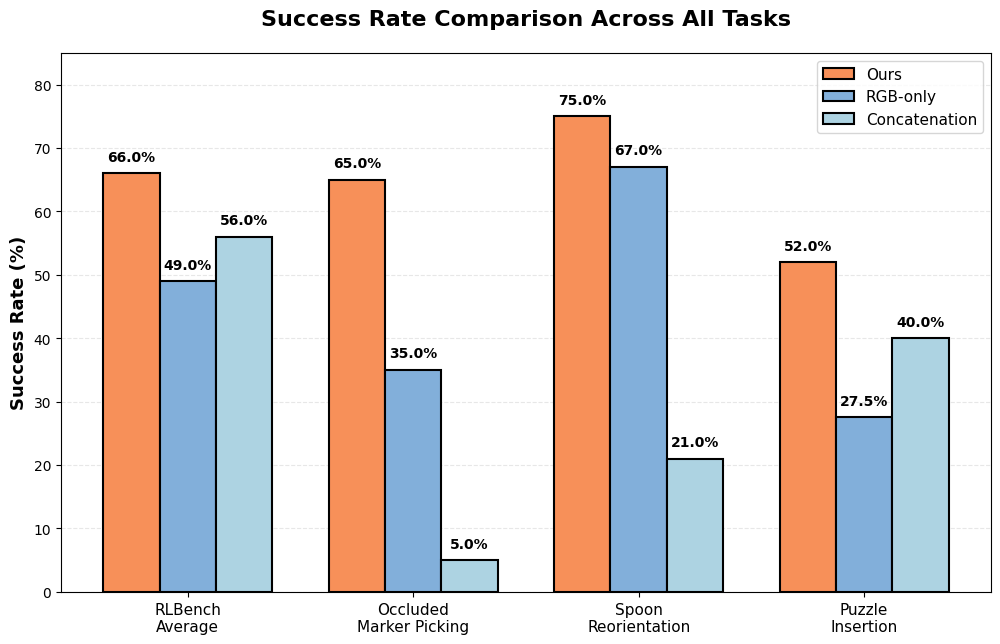

RLBench 模拟任务:在四个操作任务上,我们的方法平均成功率为 66%,显著优于单模态策略 (49%) 和特征拼接 (56%) 。

真实世界:

- 遮挡记号笔抓取(occluded marker picking):我们的方法成功率为 65%,而 RGB-only 为 35%,拼接方法仅为 5%(拼接方法反而没法很好的利用触觉确定物体是否被抓住)。

- 勺子重定向 (Spoon Reorientation):一种灵巧的手内操作任务。我们的方法成功率为 75%,拼接方法仅为 21% 。

- 拼图插入 (Puzzle Insertion):需要毫米级精度。我们的方法任务成功率为 52%,拼接方法为 40% 。

总结

通过从特征级拼接转向策略级组合,我们为模态稀疏性问题提供了一个系统性的解决方案,同时实现了增量学习和鲁棒部署 。我们的 core insights 很简单:让每个模态拥有自己的 “专家” 并学习各自的相对影响力,而不是将所有传感器强制输入单一网络。

© THE END

转载请联系本公众号获得授权

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-12-03,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读