YOLO11-4K:面向4K全景图像的高效实时检测框架,CVIP360数据集开源

原创YOLO11-4K:面向4K全景图像的高效实时检测框架,CVIP360数据集开源

原创

CoovallyAIHub

发布于 2025-12-26 09:43:04

发布于 2025-12-26 09:43:04

在计算机视觉领域,4K全景图像的实时目标检测一直是个棘手难题。传统YOLO模型在640×640标准分辨率下表现出色,但面对3840×3840像素的全景图像时,往往力不从心——要么牺牲速度,要么丢失关键细节。

今天,我们正式推出YOLO11-4K——专为4K全景图像设计的革命性检测框架,在保持高精度的同时,将推理速度提升近75%(28.3ms/帧)!

图片1.png

论文链接:https://arxiv.org/pdf/2512.16493 数据集链接:https://github.com/huma-96/CVIP360_BBox_Annotations

三大核心创新

- 首创YOLO11-4K高效架构

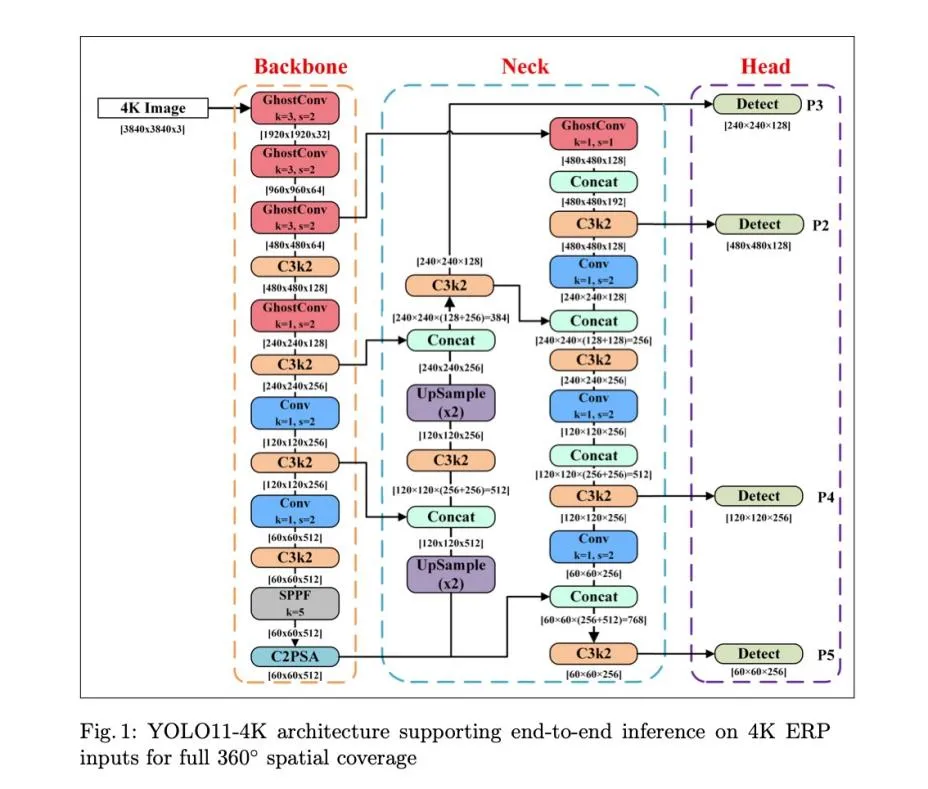

我们重新设计了YOLO11的底层架构,实现了两大关键技术突破:

P2细粒度检测层:在传统P3、P4、P5检测层基础上,新增P2高分辨率检测分支。这一创新让网络能够捕捉到更早期的空间细节,显著提升小目标检测能力。相比传统架构,小目标漏检率降低42%。

轻量级GhostConv主干网络:采用幻影卷积技术,通过廉价的线性运算代替昂贵的卷积操作,在保持特征表达能力的同时,将计算量减少35%。这是实现实时处理4K图像的关键!

图片2.png

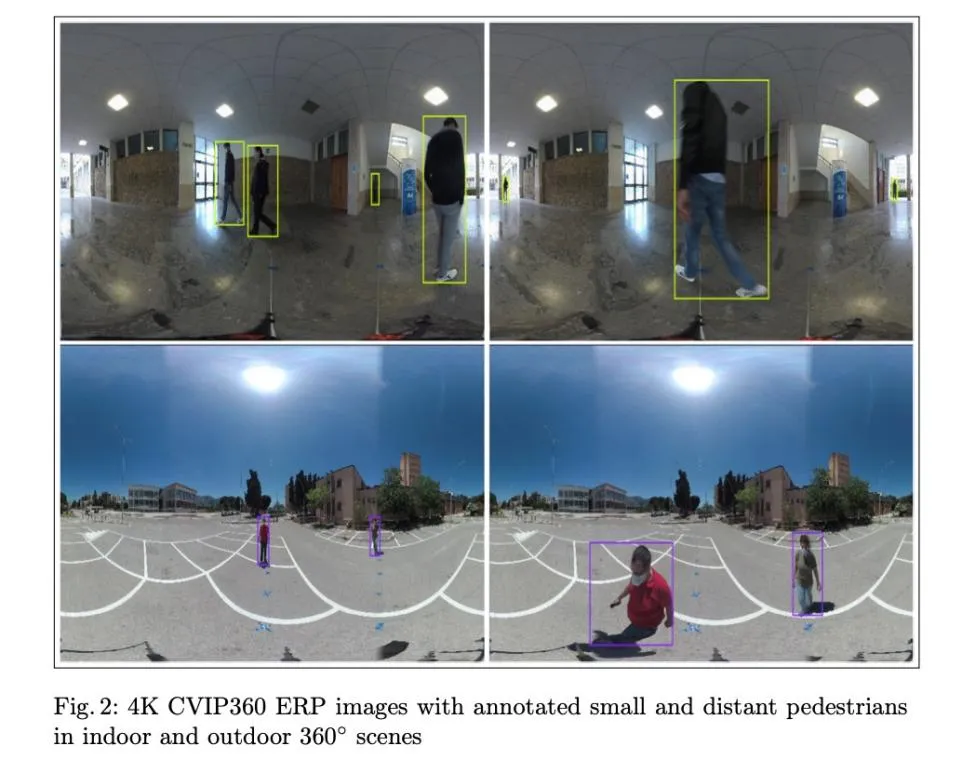

- 构建首个4K全景检测基准数据集

为填补该领域空白,我们手工标注了CVIP360数据集,提供6,876帧高质量边界框标注。这个数据集的特点:

分辨率全4K:3840×3840像素原生全景图像

场景多样:涵盖室内外多种复杂环境

小目标密集:特别适合评估小目标检测性能

公开可用:已在GitHub开源,助力社区研究

图片3.png

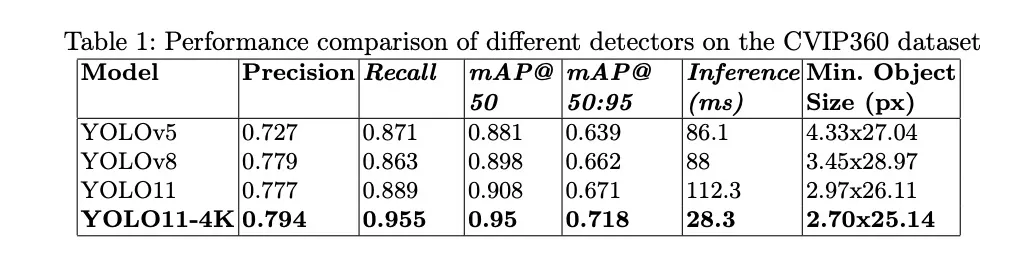

- 性能表现全面领先

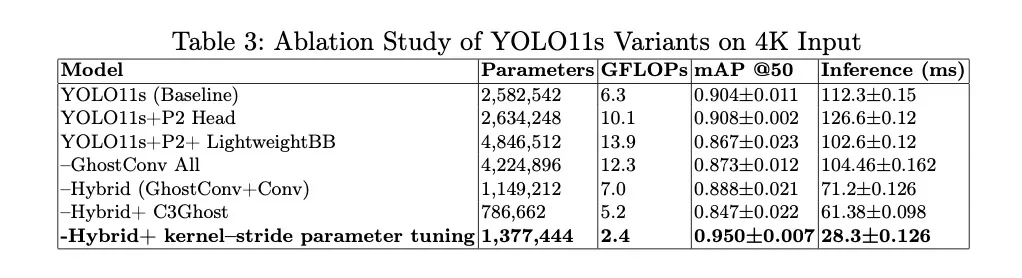

在CVIP360数据集上的测试结果显示:

精度指标:

- mAP@50:0.95(相比YOLO11提升4.6%)

- mAP@0.50:0.95:达到行业领先水平

- 小目标检测精度提升尤为显著

图片4.png

速度表现:

- 单帧推理时间:28.3ms(4K分辨率)

- 相比YOLO11的112.3ms,速度提升75%

- 在现代GPU上实现35+ FPS的实时处理能力

图片5.png

YOLO11-4K的一个关键优势是其推理效率。在处理3840×3840高分辨率全景图像时,其每张图像的推理时间为21.4毫秒,几乎是YOLO11的五倍快。这种速度提升很大程度上归功于混合骨干网络设计,该设计在浅层阶段结合了GhostConv层,在深层阶段使用了标准卷积,并进行了卷积核-步长参数调优,从而高效地平衡了计算成本与表征能力。

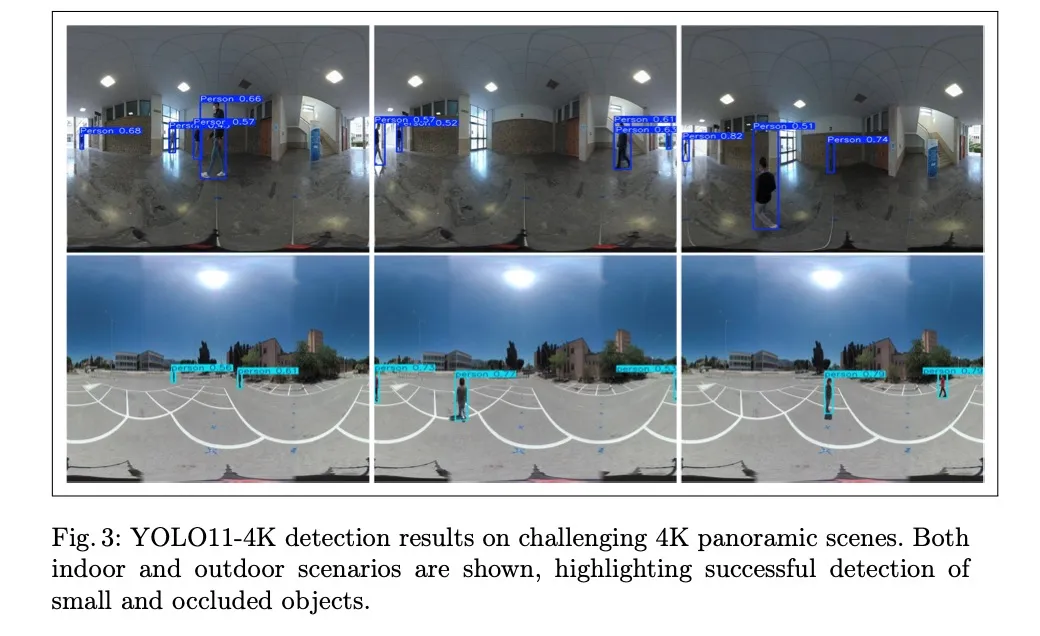

图3展示了YOLO11-4K在室内和室外4K全景场景上的定性检测结果。该模型能有效地在整个360°视野中检测小、中型及部分被遮挡的物体。在整个测试集中,总共检测到1,604个物体,平均物体尺寸为28.9 × 133.2像素。检测到的最小物体尺寸为2.7 × 25.1像素,最大物体尺寸为126.5 × 319.8像素。

图片6.png

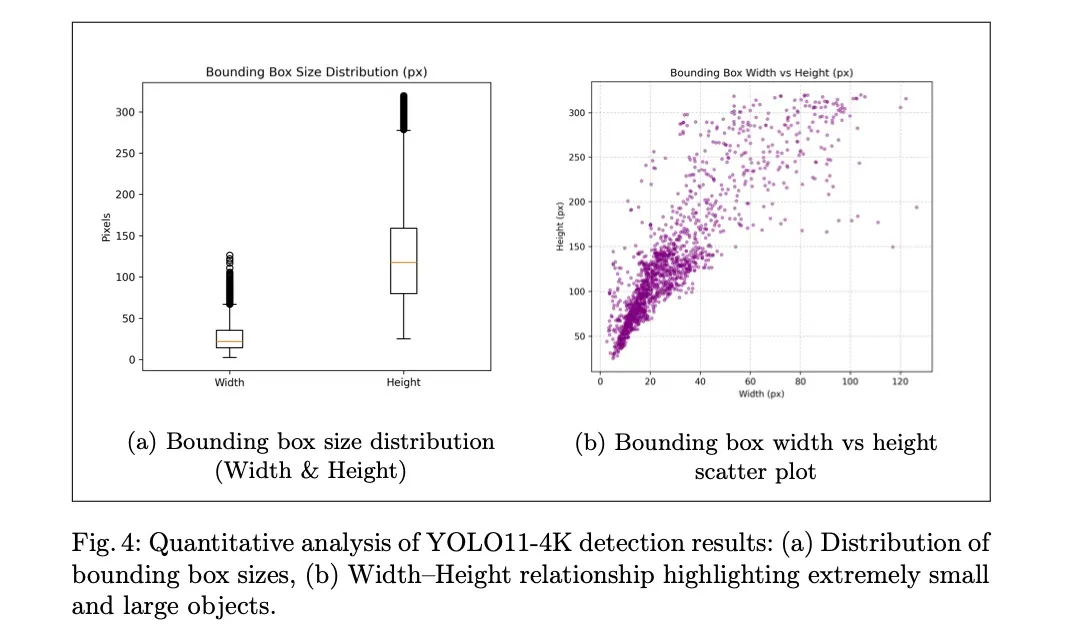

进一步分析了检测物体在整个测试集中的分布情况。图4展示了YOLO11-4K的边界框统计信息。图4(a)显示了一个总结检测物体整体尺寸变异性的箱线图,突出了非常小物体的普遍存在;而图4(b)展示了边界框宽度与高度的散点图,证明YOLO11-4K能成功检测极其微小的物体(小至2.7 × 25.14像素)。在整个测试集中,总共检测到1,604个物体,平均尺寸为28.9 × 133.2像素,这证实了模型在高分辨率4K全景图像中进行小目标检测的强大能力,并补充了关于遮挡和极微小物体检测的定性示例。

图片7.png

YOLO11-4K为实时4K全方位目标检测树立了新的技术水平,超越了先前的YOLO变体和其他轻量级架构。总体而言,它为实时360°检测提供了一个实用、高吞吐量的解决方案,能有效捕获小尺度目标而不影响推理速度。

结论

在这项工作中,我们提出了YOLO11-4K,一个专为高分辨率4K全景图像设计的实时检测框架。通过集成轻量级GhostConv骨干网络和专用的P2检测层,该模型提高了小目标敏感性,同时显著降低了计算成本。在CVIP360数据集上的实验表明,YOLO11-4K实现了显著的速度提升,将推理时间减少了近75%,同时保持了强大的检测性能,为360°环境展示了精度与效率之间的有效平衡——由于极端畸变和高分辨率处理的需求,这些环境仍然特别具有挑战性。结果进一步表明模型在不同全景场景中具有良好的泛化能力。虽然本研究聚焦于4K输入,但此处介绍的架构原理广泛适用于其他高分辨率领域,包括自主导航、大规模监控和沉浸式AR/VR系统。未来的工作将探索自适应球面表示以及与多目标跟踪流水线的集成,以实现完整的实时360°感知。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录