Nat. Neurosci. | 借鉴神经科学洞见构建自适应人工智能

Nat. Neurosci. | 借鉴神经科学洞见构建自适应人工智能

DrugAI

发布于 2026-01-14 16:56:00

发布于 2026-01-14 16:56:00

DRUGONE

生物智能本质上具有高度适应性,动物能够根据环境反馈持续调整自身行为。然而,构建同样具备适应能力的人工智能仍然是一个重大挑战。研究人员提出“自适应智能”这一概念,即借鉴生物智能的关键机制,构建能够在线学习、泛化并快速适应环境变化的人工智能系统。近年来,神经科学在理解动物如何学习并动态更新其世界模型方面取得了重要进展,为新一代 AI 提供了丰富启发。本文系统回顾了自适应生物智能的行为学与神经基础,梳理了人工智能领域的相关进展,并探讨了基于脑启发的自适应算法设计路径。

从神经科学到自适应人工智能的核心思想

研究人员提出,自适应人工智能的关键不在于更大的模型或更多的数据,而在于引入生物智能中已被反复验证的核心计算原则。与当前主流人工智能系统依赖离线训练、静态部署不同,生物智能具备在不确定环境中持续学习、快速泛化与在线更新的能力。本文的核心观点可概括为三个相互关联的支柱:内部模型、预测误差驱动学习,以及模块化与专业化结构。

首先,自适应行为依赖于内部模型(internal models)。研究人员指出,大脑并非被动响应感觉输入,而是持续构建关于世界的生成式模型,用于预测感知与动作的后果。这种机制使生物体能够在神经处理存在延迟的情况下仍然快速行动。将这一思想引入人工智能,意味着模型不应仅学习输入–输出映射,而应显式维护可更新的世界模型,用于指导决策与学习。

其次,预测误差是学习的核心驱动力。在神经系统中,预测与实际输入之间的偏差会触发学习信号,从而更新内部模型。研究人员强调,预测误差不仅存在于奖励系统中,也广泛分布于感觉、运动和认知通路,且具有层级结构。对人工智能而言,这意味着学习机制应能够区分“需要即时调整行为的误差”和“需要更新模型结构的系统性误差”,以实现更高效、更稳定的在线适应。

第三,生物智能并非由单一通用模块实现,而是高度模块化与专业化的结果。不同脑区在共享基本计算原则的同时,针对特定信息类型进行优化,并通过层级结构进行协同。研究人员认为,试图用单一基础模型解决所有任务,可能并非构建自适应智能的最优路径。相反,由多个专用模型组成、可动态解锁与更新的智能体系统,更符合神经系统的组织方式。

基于上述三点,本文提出了一条从神经科学通向自适应人工智能的清晰路线:以内部模型为核心表示,以预测误差作为教学信号,以模块化结构支撑持续学习与泛化能力。这一框架不仅为新一代 AI 算法提供设计原则,也为神经科学提供了可检验的计算假设。

预测、内部模型与适应性行为

研究人员认为,人类与动物的感知和行为建立在持续预测之上。尽管感觉信息传入大脑存在不可避免的时间延迟,生物系统仍能快速行动,其关键在于构建并不断更新内部模型(world models)。这些模型用于预测行动的感觉和运动后果,从而弥补神经处理延迟。

在充满不确定性和变化的环境中,仅依赖静态反应策略是远远不够的,自适应行为依赖于内部模型的快速修正。然而,大脑如何在真实环境中实现这种动态更新,仍是神经科学的核心问题之一。

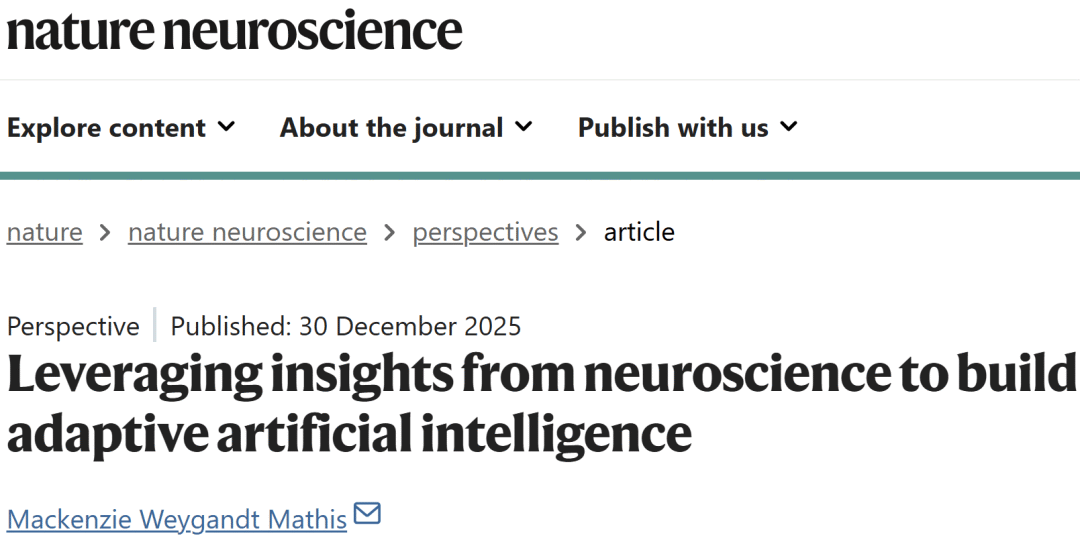

图 1|动物中的快速学习:从少样本学习到基于内部模型更新的学习。

神经层面的自适应学习机制

在感觉运动系统中,大量研究表明动物能够在单次实验过程中完成快速适应。例如,在引入视觉或力学扰动后,动物可在短时间内修正运动策略,并在扰动消失后表现出“洗脱效应”,这是内部模型被更新的直接证据。

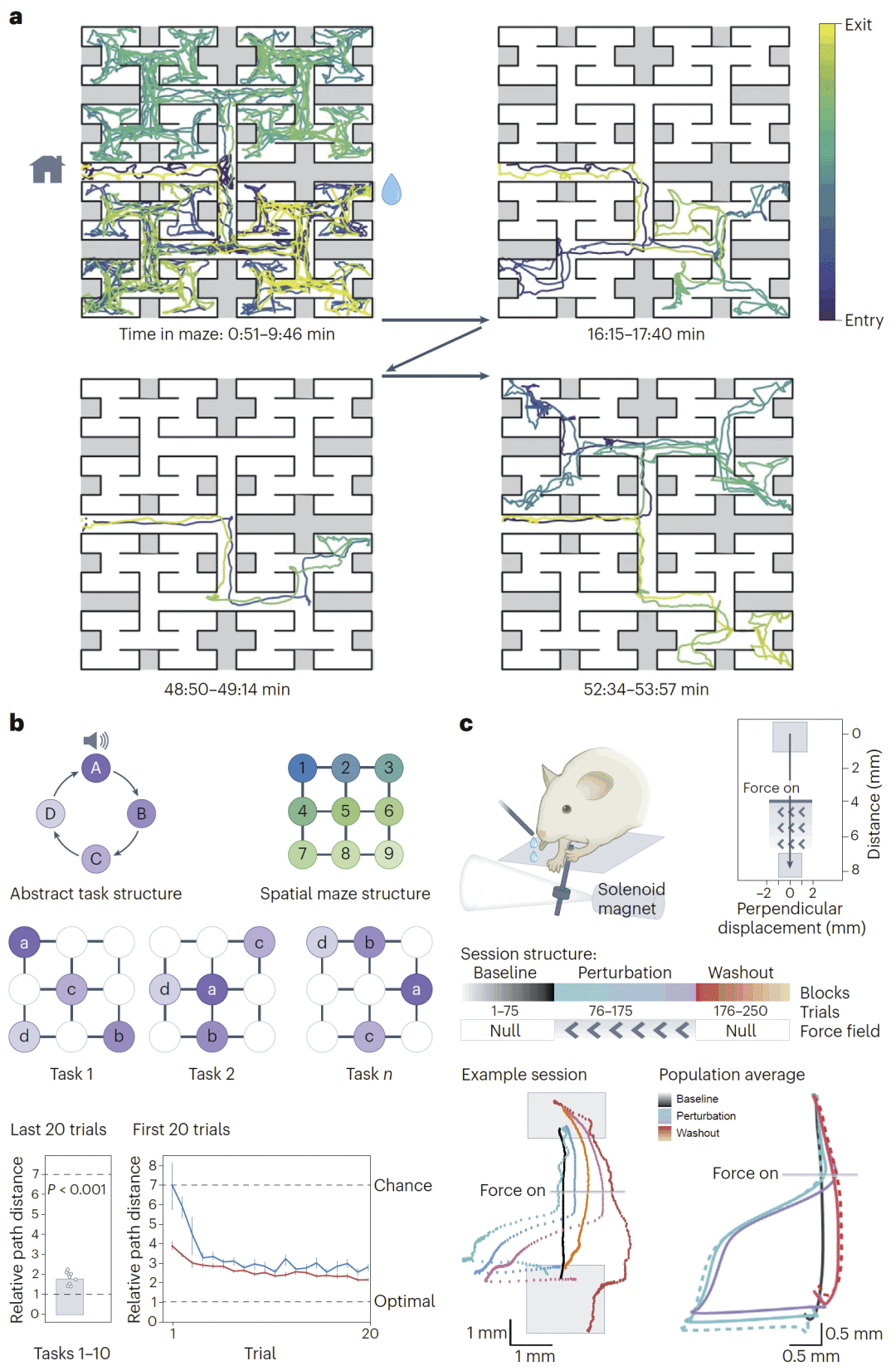

神经记录显示,感觉皮层、运动皮层以及前额叶等区域在学习过程中会出现持续性的活动变化,反映预测误差信号的生成与传播。研究人员发现,这些误差信号并非随机分布,而是存在明确的层级结构和细胞类型特异性,为理解大脑如何协调学习与稳定性提供了关键线索。

图 2|神经计算机制:生物系统中的教学信号。

研究自适应行为的新技术框架

传统神经科学研究依赖重复试验以获得统计稳健性,但这种范式难以捕捉真实学习过程中神经活动的动态变化。近年来,大规模神经记录技术、无标记行为追踪以及深度学习分析方法的出现,使研究人员能够在单次行为轨迹尺度上解析学习与适应。

从广义线性模型到潜在动力学模型,再到基于深度学习的联合行为–神经表征方法,这些工具为系统研究自适应学习提供了全新可能,也为 AI 算法设计提供了可迁移的分析框架。

人工智能中的训练、泛化与适应

当前多数人工智能系统仍遵循“训练–测试–部署”的静态范式,本质上缺乏持续适应能力。尽管大模型和规模定律显著提升了泛化性能,但它们在能效、在线更新和长期适应方面仍存在局限。

研究人员重点讨论了持续学习与上下文学习等方向,这些方法试图缓解灾难性遗忘问题,使模型能够在学习新任务的同时保留已有知识。其中,一些方法虽并非直接源自神经科学,但在功能上与大脑中的稳定–可塑性平衡高度相似。

神经启发的关键 AI 策略

记忆回放机制

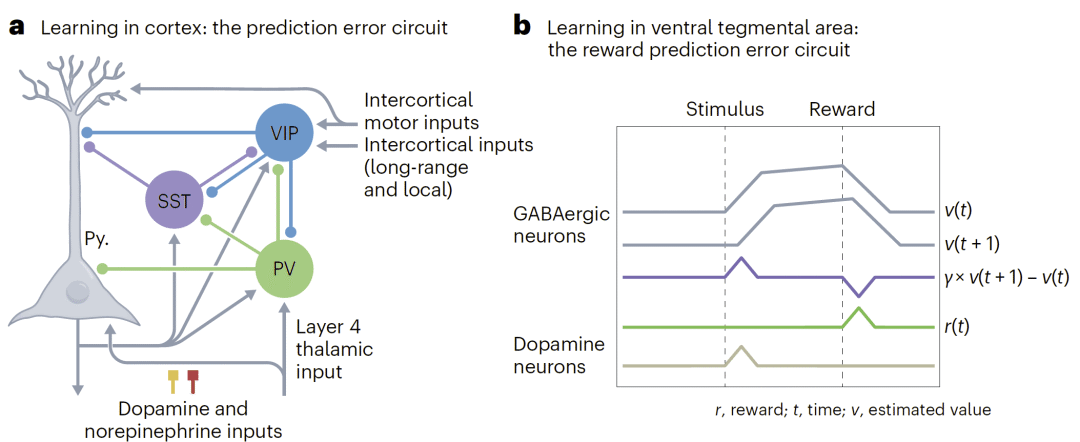

在生物系统中,记忆回放被认为有助于巩固经验并支持长期学习。类似机制已被引入人工智能,通过在训练过程中重放旧样本或伪标签,缓解遗忘并支持持续学习。这一思想已在强化学习、计算机视觉和大语言模型中展现出实际价值。

预测误差作为教学信号

神经科学研究表明,预测误差是驱动学习的核心信号。研究人员提出,未来 AI 系统可显式引入预测误差机制,用于区分“需要即时修正的行为偏差”和“需要更新内部模型的系统性错误”,从而实现更高效的在线适应。

图 3|生物系统与人工系统中的记忆回放机制。

基础模型与自适应智能体

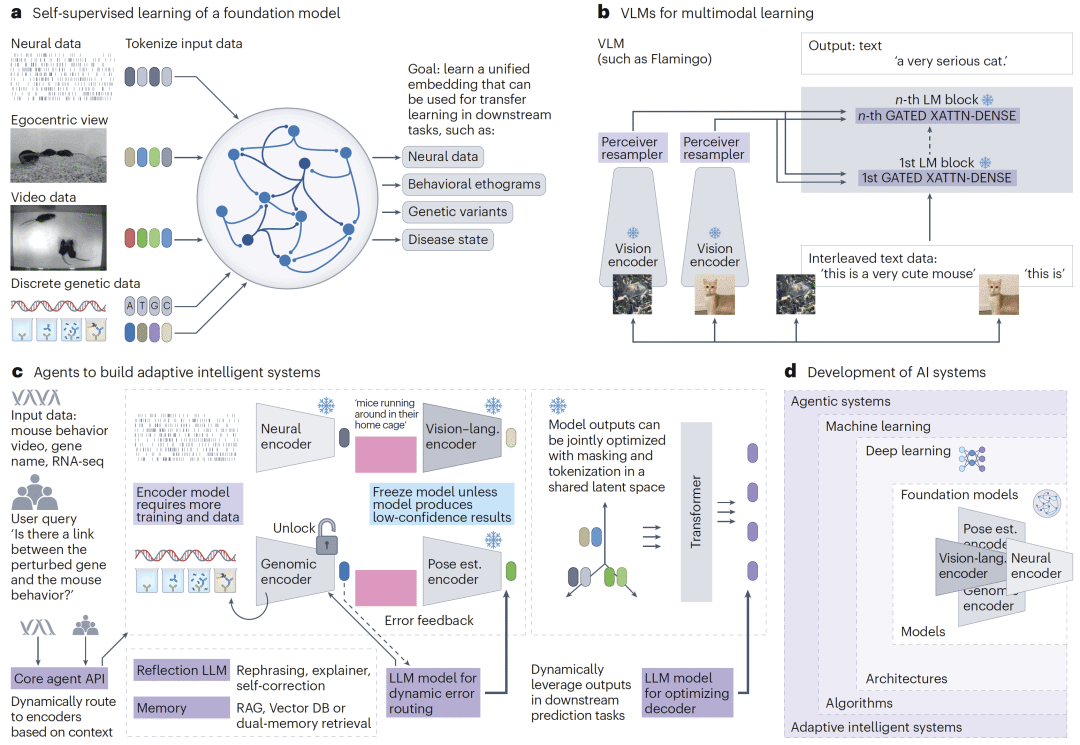

基础模型通过多模态、大规模自监督训练获得强泛化能力,但研究人员指出,单一模型难以承担所有功能。大脑的启示在于模块化与专业化:不同脑区在共享计算原则的同时,承担不同任务。

基于此,研究人员提出由多个专用编码器组成的智能体系统。在该系统中,不同编码器处理行为、神经、基因等数据,并在高层通过共享潜在空间进行整合;当系统检测到不确定性或预测误差时,仅对相关模块进行更新,而非整体重训,从而实现真正的在线自适应。

图 4|基础模型与自适应智能体系统。

结语

研究人员认为,真正的自适应人工智能不应仅依赖更大的数据和模型规模,而应系统性引入神经科学中已被验证的核心原则,包括内部模型、预测误差驱动学习以及模块化结构。

这种跨学科融合不仅有助于构建在动态、不确定环境中更稳健、更可信的 AI 系统,也反过来为理解大脑提供了新的理论框架与实验平台。未来,自适应智能体有望同时推动人工智能与神经科学的共同进步。

整理 | DrugOne团队

参考资料

Mathis, M.W. Leveraging insights from neuroscience to build adaptive artificial intelligence. Nat Neurosci (2025).

https://doi.org/10.1038/s41593-025-02169-w

内容为【DrugOne】公众号原创|转载请注明来源

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2026-01-07,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读