为视觉建模注入物理灵魂:WaveFormer证明,下一站是“物理启发模型”

原创为视觉建模注入物理灵魂:WaveFormer证明,下一站是“物理启发模型”

原创

CoovallyAIHub

发布于 2026-02-04 10:43:49

发布于 2026-02-04 10:43:49

近年来,Transformer 席卷了计算机视觉领域,从图像分类到目标检测,表现亮眼。然而,当任务从静态图像扩展到视频理解、动态场景分析时,Transformer 的“硬扛”模式开始显露出明显局限。最近,一篇名为 《WaveFormer: Frequency-Time Decoupled Vision Modeling with Wave Equation》 的论文,提出用波动方程建模视觉特征,试图从物理层面重构视觉语义传播方式。这是否只是又一个“听起来很美、用起来很难”的理论尝试?我们今天从几个根本问题展开分析。

为什么视频 / 动态理解越来越难靠 Transformer 硬扛?

- 计算复杂度爆炸

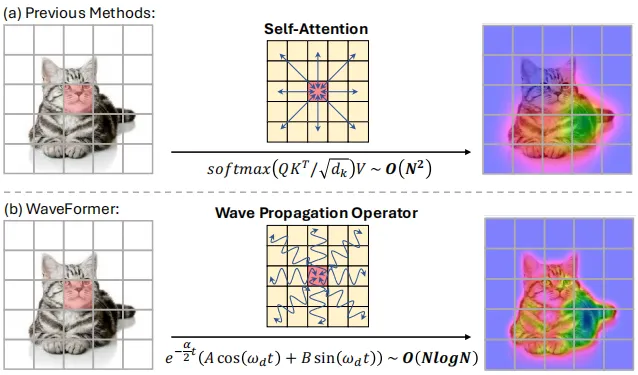

Transformer 核心是自注意力机制,其计算复杂度为 O(N²),其中 N 是序列长度。在视频中,如果每帧划分为多个 patch,时间维度再叠加,序列长度急剧增加,即使是线性注意力或窗口注意力优化也难以根本解决。

screenshot_2026-02-03_15-24-16.png

- 时间维度建模薄弱

Transformer 本质上是对序列建模,但对时间连续性和动态演化缺乏显式物理假设。视频中的运动、光流、时间一致性等信息,如果只依靠数据驱动学习,需要极大参数量和样本量。

- 高频细节丢失严重

传统 Transformer 在深层网络中容易平滑高频信息(如边缘、纹理),这在静态图像中尚可通过跳跃连接缓解,但在动态场景中,细节丢失会累积,影响分割、跟踪等精细任务。

这些瓶颈并非靠“堆更大模型、更多数据”就能彻底解决,而是需要引入新的归纳偏置与传播机制。

WaveFormer:把特征当作“波”,到底解决了什么?

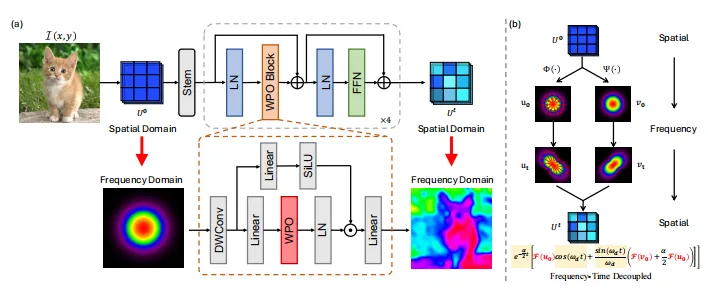

WaveFormer 的核心思想是:将特征图视为可在空间中传播的波动信号,用阻尼波动方程控制其演化。这一做法在物理上是可解释的,在计算上是高效的,关键突破在于:

screenshot_2026-02-03_15-34-41.png

- 频率-时间解耦,告别过度平滑

传统热传导类比如同“模糊滤镜”,高频成分衰减过快;而波动方程中的振荡机制允许高低频成分共存,细节得以保留。公式上,其阻尼项与频率无关,振荡项与频率相关,形成解耦。

screenshot_2026-02-03_15-35-13.png

- O(N log N) 复杂度,实现高效长程交互

通过傅里叶变换在频域执行传播,WaveFormer 避免了 Transformer 的平方复杂度,尤其适合高分辨率图像与视频帧。

- 物理可解释的传播过程

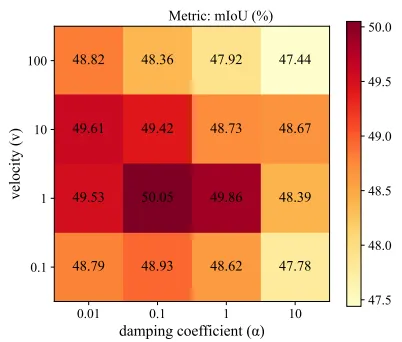

WaveFormer 中的“波速”和“阻尼”参数具有明确物理意义,可通过学习调整,适应不同语义的传播需求,例如:

- 低速+强阻尼 → 局部结构保持

- 高速+弱阻尼 → 全局语义扩散

screenshot_2026-02-03_15-36-28.png

这是不是一个“看起来很美,但难落地”的方向?

我们认为,WaveFormer 的价值不仅在于理论新颖性,更在于它回应了当前视觉建模的若干本质问题,并在实验中表现出可落地的潜力:

✅ 已验证的优势:

- 在 ImageNet、COCO、ADE20K 上达到 SOTA 或相近精度,FLOPs 降低、吞吐量提升

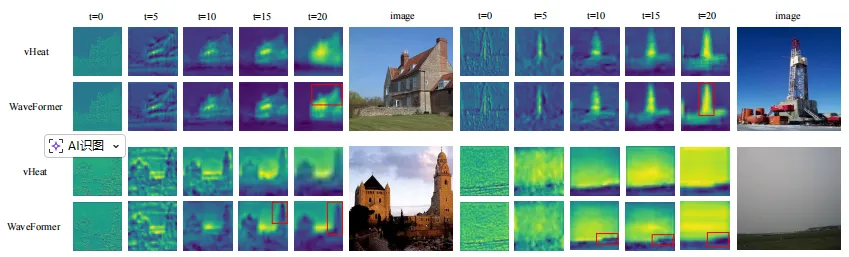

- 在语义分割任务中,边界保持明显优于热传导类方法

- 模块可嵌入现有 CNN / Transformer 架构,作为传播模块使用

🔄 待验证的方向:

- 在长视频理解、光流估计等强时序任务中的表现

- 与动态卷积、状态空间模型等新兴架构的融合潜力

- 在边缘设备上的实际部署效率

从“硬扛”到“巧解”:视觉建模的新范式是否正在形成?

WaveFormer 暗示了一个趋势:视觉建模正从纯粹数据驱动的黑箱模型,向物理启发、结构可解释、计算高效的白箱模型过渡。波动方程不是唯一路径,热传导、扩散模型、弹簧系统等物理模型都可能带来新的模块设计。

尤其值得关注的是,这种机制为多频语义建模提供了统一框架:低频承载全局布局,高频保持细节纹理,而传播过程可控可调。

总结

Transformer 不是视觉的终点,尤其在动态、高分辨率、细粒度任务中,其局限性日益明显。WaveFormer 通过波动方程重新思考特征传播机制,在频率-时间解耦、计算效率、细节保持等方面显示出明确优势。它或许不是最终答案,但它指出了一个值得探索的方向:视觉建模可以更有物理感、可解释、高效化。

论文代码已开源:https://github.com/ZishanShu/WaveFormer

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录