ollama v0.15.6发布:上下文限制修复、自动模型下载、Claude环境变量优化、Droid与Qwen全面更新详解

ollama v0.15.6发布:上下文限制修复、自动模型下载、Claude环境变量优化、Droid与Qwen全面更新详解

福大大架构师每日一题

发布于 2026-02-09 14:51:46

发布于 2026-02-09 14:51:46

在这里插入图片描述

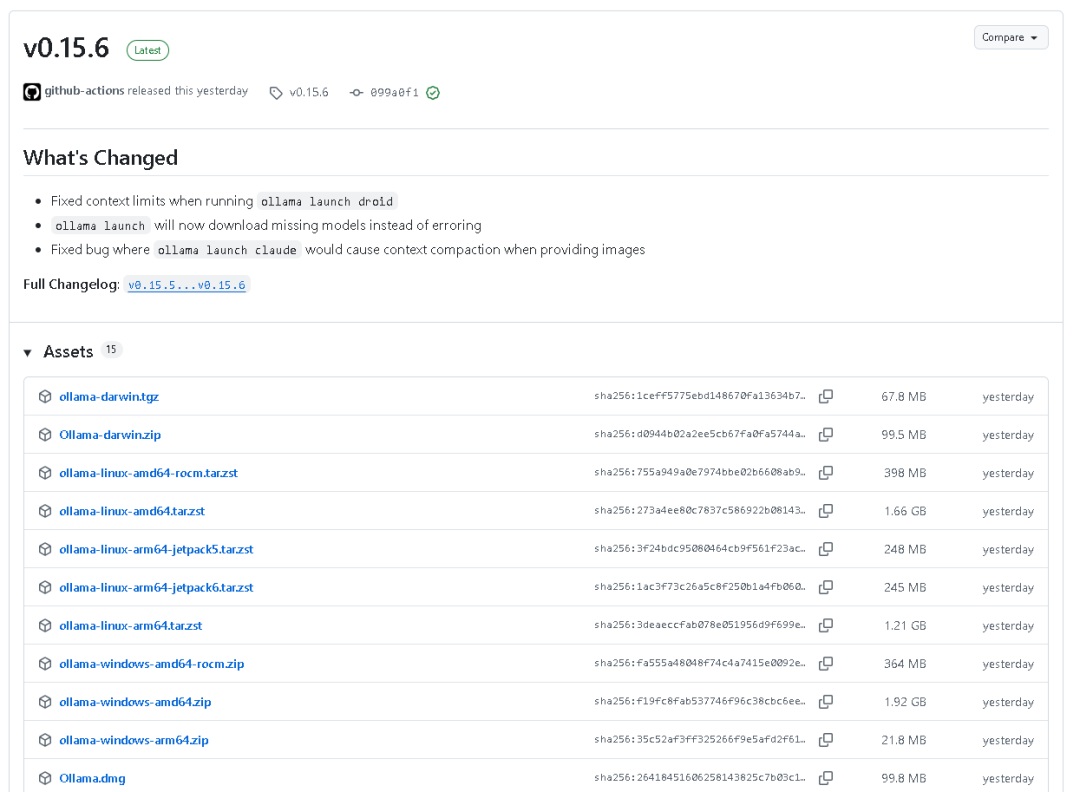

在这里插入图片描述

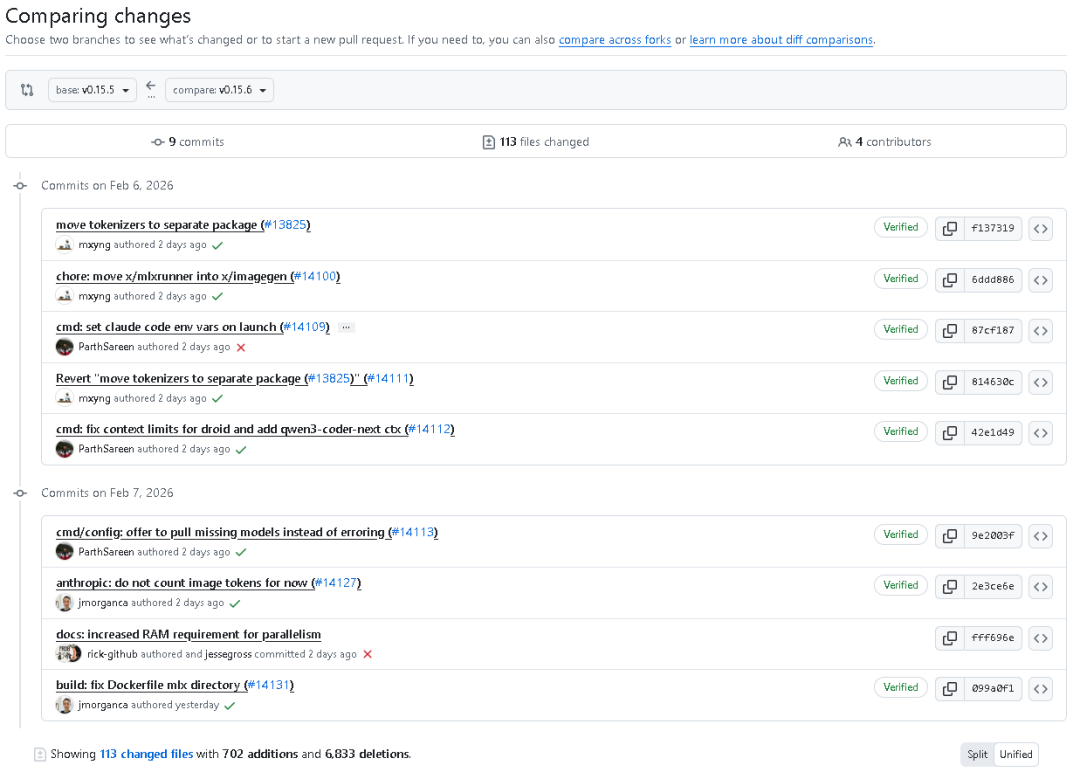

在这里插入图片描述

在 2026 年 2 月 7 日,Ollama 官方正式发布 v0.15.6 最新版本。本次更新虽然版本号看似小幅提升,但实际上内部改动巨大,涉及 模型加载机制、上下文处理限制、环境变量配置、Docker 构建路径调整、云端模型拉取逻辑优化、tokenizer 模块重构 等众多核心模块。整个更新包含 9 次提交、113 个文件修改、702 行新增与 6,833 行删除,可视为一次结构性优化版本。本文将完整梳理本次更新的变更内容、模块调整、开发者侧的影响及向下兼容性分析。

一、版本概览

发布信息

- • 版本号:v0.15.6

- • 发布日期:2026年2月7日

- • 主要更新者:核心团队成员贡献

- • 提交数量:9 次

- • 修改文件:113 个

- • 新增代码行数:702 行

- • 删除代码行数:6833 行

- • 主要贡献模块:

- •

cmd/config - •

anthropic - •

llm/server - •

model - •

runner - •

sample - •

server - • 新增子包

tokenizer - • 替换

x/mlxrunner→x/imagegen

- •

本次更新的核心议题

- 1. 修复

ollama launch droid的上下文限制 (context limits) - 2.

ollama launch命令在缺少模型时自动下载模型,而不再报错 - 3. 解决

ollama launch claude提供图像时造成上下文压缩 (context compaction) 的问题 - 4. 新增

ANTHROPIC_*环境变量支持 Claude Code 的模型调用逻辑 - 5. 增强

cmd/config相关测试,新增多项自动化覆盖测试 - 6. 分离与独立

tokenizer模块,将文本处理逻辑彻底从model包迁移 - 7. 将

x/mlxrunner模块重构为x/imagegen - 8. 修正 Dockerfile 构建路径错误 —

mlx目录层级更新 - 9. 修改 FAQ:增加关于

OLLAMA_NUM_PARALLEL并行参数所需的内存说明

二、核心功能改动解析

(1)上下文限制修复——ollama launch droid 与 Qwen3-Coder-Next 支持

在本次更新中,最重要的一项修复就是 上下文限制 (context limits) 问题。 此前在某些情况下,使用命令:

ollama launch droid时,模型在运行过程中出现上下文溢出或响应不稳定问题。

此次版本专门引入新的逻辑,使得 Droid 模块在本地及云端模型场景下动态调整 maxOutputTokens。若检测到为云模型,则通过查表自动应用云模型限制值;例如 qwen3-coder-next 新增支持 Context: 262,144 与 Output: 32,768。

if isCloudModel(context.Background(), client, model) {

if l, ok := lookupCloudModelLimit(model); ok {

maxOutput = l.Output

}

}在对应的测试文件 cmd/config/droid_test.go 中,也新增了完整的测试用例 TestDroidEdit_CloudModelLimitsUsed,确保云模型输出上限可被正确识别,并通过本地与 :cloud 后缀的兼容性校验。

(2)ollama launch 自动下载缺失模型

在旧版本中,如果所选模型未存在于本地缓存中,命令会直接报错退出,用户需手动执行 ollama pull model。

v0.15.6 版本将此部分逻辑重写为 自动检测 + 用户交互式确认下载。

新增函数 showOrPull(ctx context.Context, client *api.Client, model string):

if _, err := client.Show(ctx, &api.ShowRequest{Model: model}); err == nil {

return nil

}

if ok, err := confirmPrompt(fmt.Sprintf("Download %s?", model)); err != nil {

return err

} else if !ok {

return errCancelled

}

return pullModel(ctx, client, model)通过与 client.Show 判断模型存在性结合,当模型缺失时自动触发下载提示。

在 cmd/config/integrations.go 中,这一逻辑被嵌入 launch 命令的验证流程,多处验证调用此函数替换原 not found 错误。

对应测试 TestShowOrPull_ModelExists 与 TestShowOrPull_ModelNotFound_NoTerminal 模拟了在线检测及无终端场景。

(3)Claude 环境变量增强

在 cmd/config/claude.go 中新增了 modelEnvVars 函数,用以为 Claude Code 环境配置多层模型别名。

新增环境变量包括:

- •

ANTHROPIC_DEFAULT_OPUS_MODEL - •

ANTHROPIC_DEFAULT_SONNET_MODEL - •

ANTHROPIC_DEFAULT_HAIKU_MODEL - •

CLAUDE_CODE_SUBAGENT_MODEL

其作用是根据用户保存的 alias 配置动态调整各层次调用关系。例如:

return []string{

"ANTHROPIC_DEFAULT_OPUS_MODEL=" + primary,

"ANTHROPIC_DEFAULT_SONNET_MODEL=" + primary,

"ANTHROPIC_DEFAULT_HAIKU_MODEL=" + fast,

"CLAUDE_CODE_SUBAGENT_MODEL=" + primary,

}并在 cmd/config/claude_test.go 增加了 4 组测试场景验证不同配置下的环境变量传递行为。

(4)cmd/config 模块全面优化

a. config.go 迁移日志精简

删除了冗余的 slog.Warn 和 slog.Info 输出,仅保留逻辑执行,避免终端输出噪音。

b. droid.go 编辑逻辑增强

针对多个模型写入 .factory/settings.json 时加入自动 index 与 cloud-limit 判断,可直观区分默认模型与云模型的 maxOutputTokens。

(5)tokenizer 模块全面独立化

这是此次版本最重量级的底层改动。

过去 Ollama 体系结构中,文本处理器 (TextProcessor) 与模型结构紧耦合,所有编码、解码、BPE、SentencePiece、WordPiece 相关逻辑均位于 model 包下。

v0.15.6 正式将这些逻辑迁移至新的包——tokenizer。

重构结果如下:

旧路径 | 新路径 |

|---|---|

model/bytepairencoding.go | tokenizer/bytepairencoding.go |

model/sentencepiece.go | tokenizer/sentencepiece.go |

model/wordpiece.go | tokenizer/wordpiece.go |

model/vocabulary.go | tokenizer/vocabulary.go |

model/textprocessor.go | tokenizer/tokenizer.go |

model/testdata/* | tokenizer/testdata/* |

此举带来的好处:

- • 模型定义与分词逻辑彻底解耦

- • 模块依赖减少,可单独测试 tokenizer 行为

- • 后续优化 tokenizer 内存结构时不会影响模型推理代码

- •

llm/server.go、runner、sample等模块全量调整依赖路径

如 llm/server.go 中,结构体字段从:

textProcessor model.TextProcessor变为:

tokenizer tokenizer.Tokenizer并同步修改所有 Encode 与 Decode 调用逻辑。

此外,model.NewTextProcessor 返回类型也从 model.TextProcessor 改为 tokenizer.Tokenizer,以支持新接口。

(6)Dockerfile 与 CMake 构建修正

此次更新修复了 MLX 模块路径错误。

更新前引用:

COPY x/ml/backend/mlx x/ml/backend/mlx更新后正确改为:

COPY x/imagegen/mlx x/imagegen/mlx并对应修改 CMakeLists.txt:

add_subdirectory(${CMAKE_CURRENT_SOURCE_DIR}/x/imagegen/mlx)同时在 build: fix Dockerfile mlx directory (#14131) 提交中解决了容器构建目录无法找到 MLX 的问题。

(7)FAQ 内存并行参数说明调整

docs/faq.mdx 章节中原说明为:

“The default will auto-select either 4 or 1 based on available memory.”

现更新为更精确的描述:

“The maximum number of parallel requests each model will process at the same time, default 1. Required RAM will scale by

OLLAMA_NUM_PARALLEL * OLLAMA_CONTEXT_LENGTH.”

即默认并行度限定为 1,且明确指出 内存需求与并行次数及上下文长度成乘积关系。 这为部署在内存受限系统(如 Windows Radeon)上的用户提供了更清晰的参考。

(8)runner 模块逻辑合并简化

旧版本中存在多重逻辑判断 --ollama-engine 与 --mlx-engine,新版删除对 mlxrunner 的调用,统一为:

case "--ollama-engine":

return ollamarunner.Execute(args[1:])

case "--imagegen-engine":

return imagegen.Execute(args[1:])也就是说,从此版本起,图像生成任务将由 x/imagegen 完整接管,MLX 不再直接被暴露。

这标志着 Ollama 正在正式将 多模态任务与核心推理引擎分包独立化。

(9)server 层更新与镜像生成功能统一

a. 路由调整

routes.go 中,导入路径由原来的 x/imagegen 改为 x/imagegen/manifest,简化命名,明确了模型元信息的来源。

b. 调度器(sched.go)

重写 loadMLX 函数,改由 imagegen.NewServer 接管加载流程。

可理解为未来将完全放弃 mlxrunner 模块统一为 imagegen,保持一致的接口层处理逻辑。

三、测试体系强化

此次更新引入超过百个新增断言与单元测试,这体现出 Ollama 团队在确保兼容性上的精益求精。具体包括:

测试文件 | 新增测试数 | 测试核心点 |

|---|---|---|

cmd/config/claude_test.go | +93 | 验证 claude 环境变量识别与配置逻辑 |

cmd/config/droid_test.go | +49 | 本地模型默认输出、云端模型限制与混合类型容错 |

cmd/config/integrations_test.go | +136 | 自动下载逻辑、认证检测、云模型过滤 |

cmd/config/opencode_test.go | +1 | 验证新增 qwen3-coder-next 限制表项 |

这意味着在所有关键模块中,变更均拥有优先级最高的回归测试覆盖。

四、内部结构性重构意义

此次版本在表面上看仅仅修复了一些 bug,但实际上完成了一次架构层级重构。

重构方向 | 原状 | 新结构 |

|---|---|---|

文本处理 | 混杂在 model 包中 | 独立 tokenizer 包 |

图像生成 | 位于 x/mlxrunner | 统一整合为 x/imagegen |

云模型管理 | 手动 pull | 用户确认式自动下载 |

环境配置 | 静态配置 | 动态别名映射 |

日志输出 | 冗余多层 | 精简为 silent 模式 |

这样的改造让未来 Ollama 可以更加灵活地加载不同框架、支持多语言 token 化、统一 LLM 与 Vision 模块的抽象接口。

五、版本向下兼容性与迁移提示

- 1. API 不兼容点

所有直接引用

model.TextProcessor的外部工具应修改为tokenizer.Tokenizer。 - 2. Docker 镜像构建者

若自定义 Docker 构建,请确保镜像同步更新路径为

/x/imagegen/mlx。 - 3. 集成脚本与 CLI 工具

ollama launch行为变化:模型不存在时将弹出下载提示,可脚本化忽略交互。 - 4. Claude 定制用户 环境变量改变建议更新脚本,否则可能引发模型选择不一致。

- 5. 多模态用户 MLX 相关命令正式迁移到 imagegen,需调整调用路径。

六、代码变更统计摘要

模块 | 主要修改 |

|---|---|

llm/server.go | tokenizer 替换 textProcessor |

model 系列 | 各模型统一使用新 tokenizer 接口 |

runner/ollamarunner | 调用 encode/decode 重定向及 logprob 计算修正 |

sample/samplers.go | GrammarSampler 改用 tokenizer |

server/routes.go | 调整 imagegen 模块路径 |

server/sched.go | MLX 加载逻辑重指向 imagegen |

cmd/config/* | Model 校验自动下载逻辑与上下文限制修复 |

docs/faq.mdx | 内存说明增强 |

Dockerfile、CMakeLists.txt | MLX 构建目录修复 |

从总量上看,虽然删除行数高达 6833 行,但大多为结构迁移和路径统一,属于重构性质的删改。

七、总结

Ollama v0.15.6 虽标为常规修补版本,却几乎重塑了底层模块的组织形态:

- • 更加智能的模型加载机制

- • 更强的多模态兼容性

- • 更清晰的 Tokenizer 架构

- • 自动化测试全面提升

- • 开发者体验与 logs 行为更干净

它为未来的 0.16.x 版本奠定了统一框架基础,意味着 Ollama 正在朝着「将语言模型、图像生成、代码辅助」统一接口化、模块化方向稳步前进。

对于开发者而言,本次更新提示了两个方向: 其一,所有分词逻辑都将以 tokenizer 包为唯一标准接口; 其二,多模态回归到 imagegen 池管理,跨媒体模型加载将更加轻量。

结语:

代码地址:github.com/ollama/ollama

Ollama v0.15.6 是一个“修复版本”的名字,却隐藏着体系重塑的内核。 从上下文修复到自动拉取模型,从 TextProcessor 模块迁移到 Tokenizer 包,从 MLX 到 ImageGen 的代际切换,这次更新不仅是 bug 修正,更是一次项目结构的深层进化。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2026-02-08,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录