Scrapy如何过滤爬行的urls?

Scrapy如何过滤爬行的urls?

提问于 2012-11-28 23:43:15

我想知道Scrapy如何过滤那些爬行的urls?它是否存储了所有爬行在类似crawled_urls_list中的url,当它获得一个新的url时,它会查找列表以检查url是否存在?

CrawlSpider(/path/to/scrapy/contrib/spiders/crawl.py)过滤部分的代码在哪里?

非常感谢!

回答 1

Stack Overflow用户

回答已采纳

发布于 2012-11-29 07:50:50

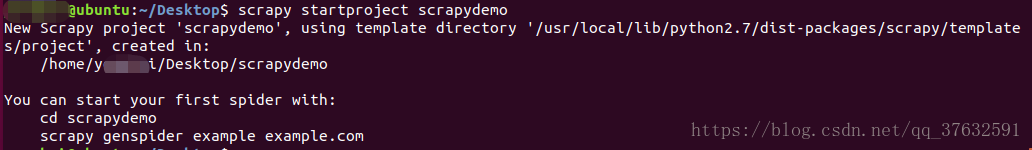

默认情况下,scrapy保存所见请求的指纹。这个列表保存在python集中的内存中,并在JOBDIR变量定义的目录中附加一个文件调用requests.seen。如果重新启动scrapy,文件将重新加载到python集中。控制它的类在scrapy.dupefilter中,如果需要不同的行为,您可以重载这个类。

页面原文内容由Stack Overflow提供。腾讯云小微IT领域专用引擎提供翻译支持

原文链接:

https://stackoverflow.com/questions/13621014

复制相似问题

无法从爬行器获取urls计数(Scrapy)

将字符串导入scrapy以用作爬行urls

Python Scrapy只爬行start_urls,然后停止。如何走得更深?

Scrapy CSV爬行

在Scrapy规则的urls列表上使用参数进行爬行迭代

社区富文本编辑器全新改版!诚邀体验~

全新交互,全新视觉,新增快捷键、悬浮工具栏、高亮块等功能并同时优化现有功能,全面提升创作效率和体验