AI_Papers周刊:第一期

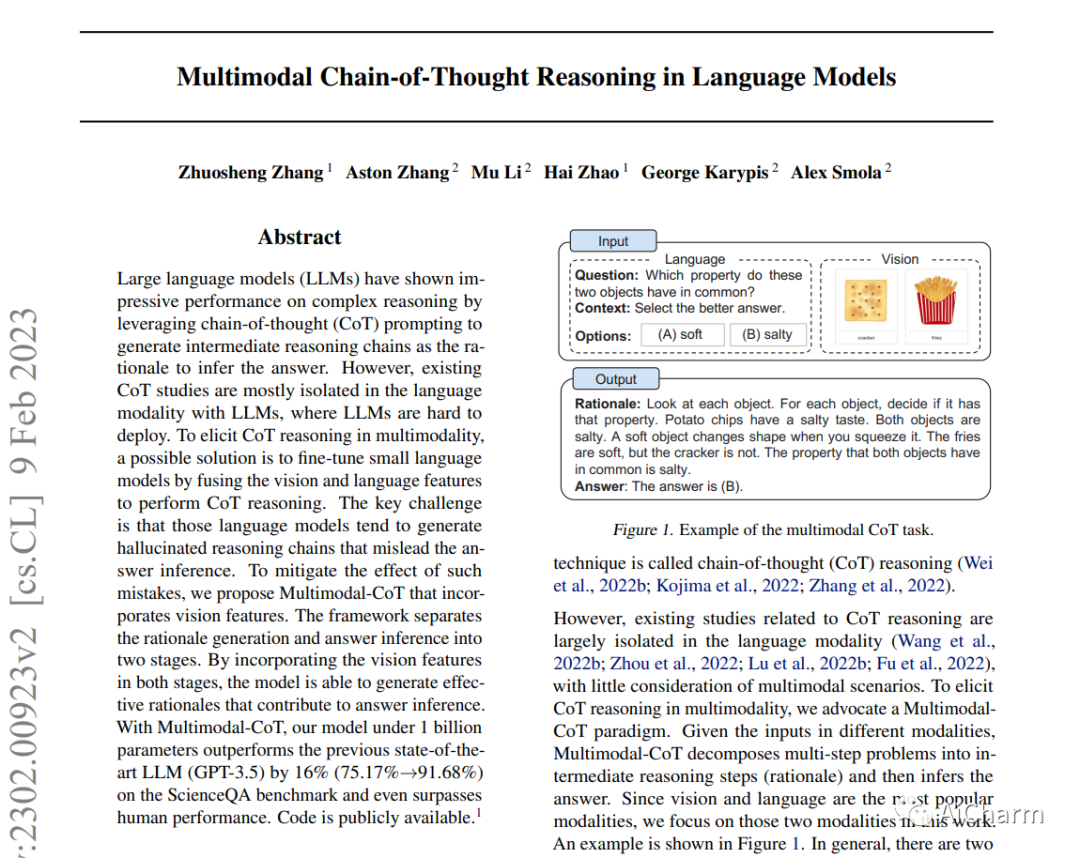

1.Multimodal Chain-of-Thought Reasoning in Language Models

标题:语言模型中的多模式思维链推理

作者:Zhuosheng Zhang, Aston Zhang, Mu Li, Hai Zhao, George Karypis, Alex Smola

文章链接:https://arxiv.org/abs/2302.00923

项目代码:https://github.com/amazon-science/mm-cot

这是来自亚马逊的AI大神李沐团队的最新研究成果。该论文正在讨论使用大型语言模型 (LLM) 进行复杂的推理任务。法学硕士通过使用一种称为“思维链 (CoT) 提示”的技术展示了良好的性能,该技术涉及生成一系列中间推理步骤以得出答案。然而,这种方法有局限性,因为它只考虑了语言模态,使得模型难以在现实场景中部署。为了解决这个问题,作者提出了一种称为“Multimodal-CoT”的新方法,它结合了视觉和语言特征。这种方法将生成推理步骤(或基本原理)的过程和进行最终推理的过程分成两个独立的阶段。通过在两个阶段结合视觉信息,该模型能够生成更有效的基本原理,有助于最终的答案推断。作者在称为 ScienceQA 的基准上评估了他们提出的方法,并表明他们的模型比以前最先进的 LLM (GPT-3.5) 高出 16%,甚至超过了人类的表现。

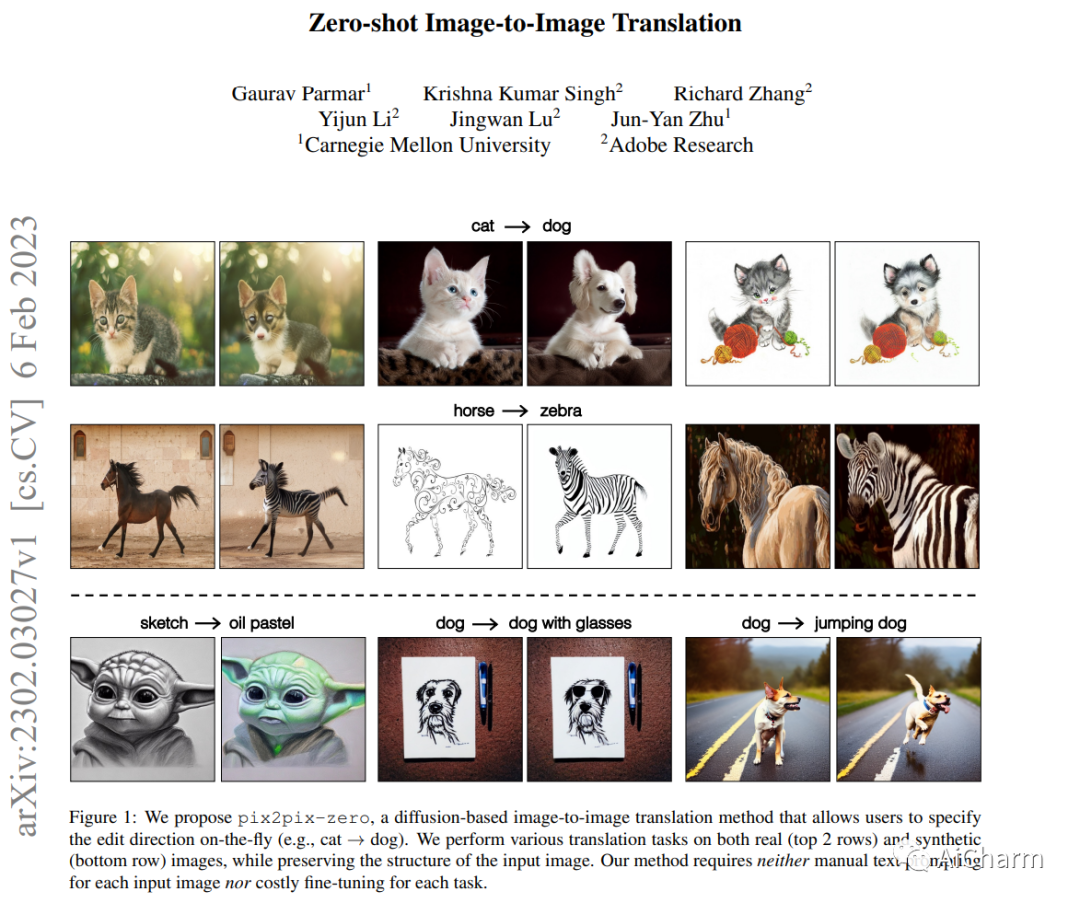

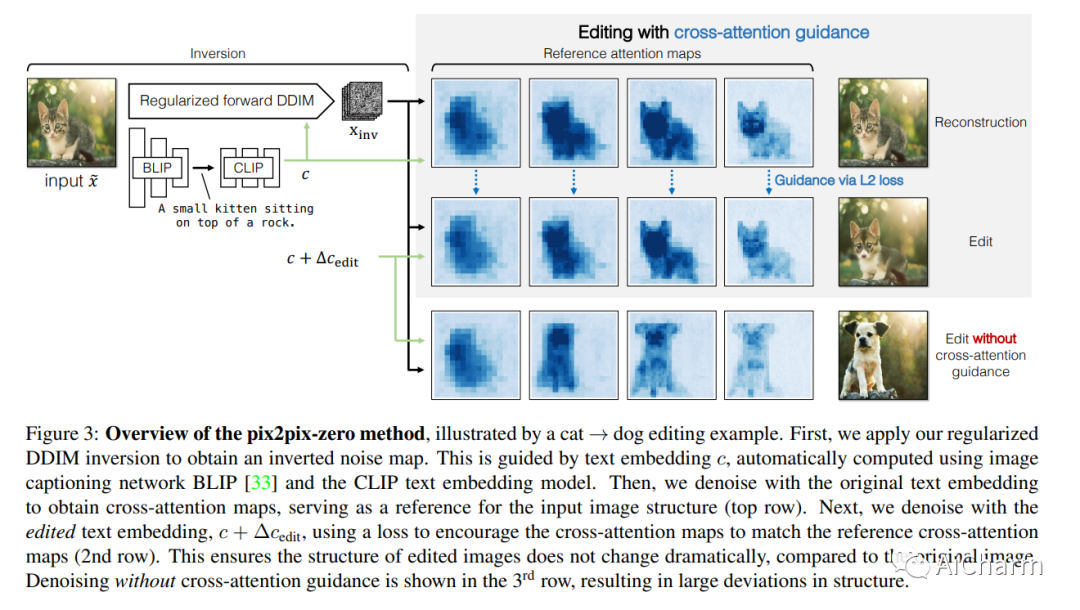

2.Zero-shot Image-to-Image Translation

标题:零样本图像到图像转换

作者:Gaurav Parmar, Krishna Kumar Singh, Richard Zhang, Yijun Li, Jingwan Lu, Jun-Yan Zhu

文章链接:https://arxiv.org/abs/2302.03027

我们大型文本到图像生成模型具有非凡的图像合成能力。然而,直接应用这些模型来编辑真实图像具有挑战性,原因有二:首先,用户很难想出一个完美的文本提示来准确描述输入图像中的每个视觉细节。其次,虽然现有模型可以在某些区域引入所需的变化,但它们通常会显着改变输入内容并在不需要的区域引入意外的变化。这项工作提出了 pix2pix-zero,一种图像到图像的翻译方法,可以在没有手动提示的情况下保留原始图像的内容。该方法不需要对这些编辑进行额外的训练,可以直接使用现有的预训练文本到图像扩散模型。它优于真实和合成图像编辑的现有和并行工作。

Subjects: cs.LG、cs.AI、cs.CV

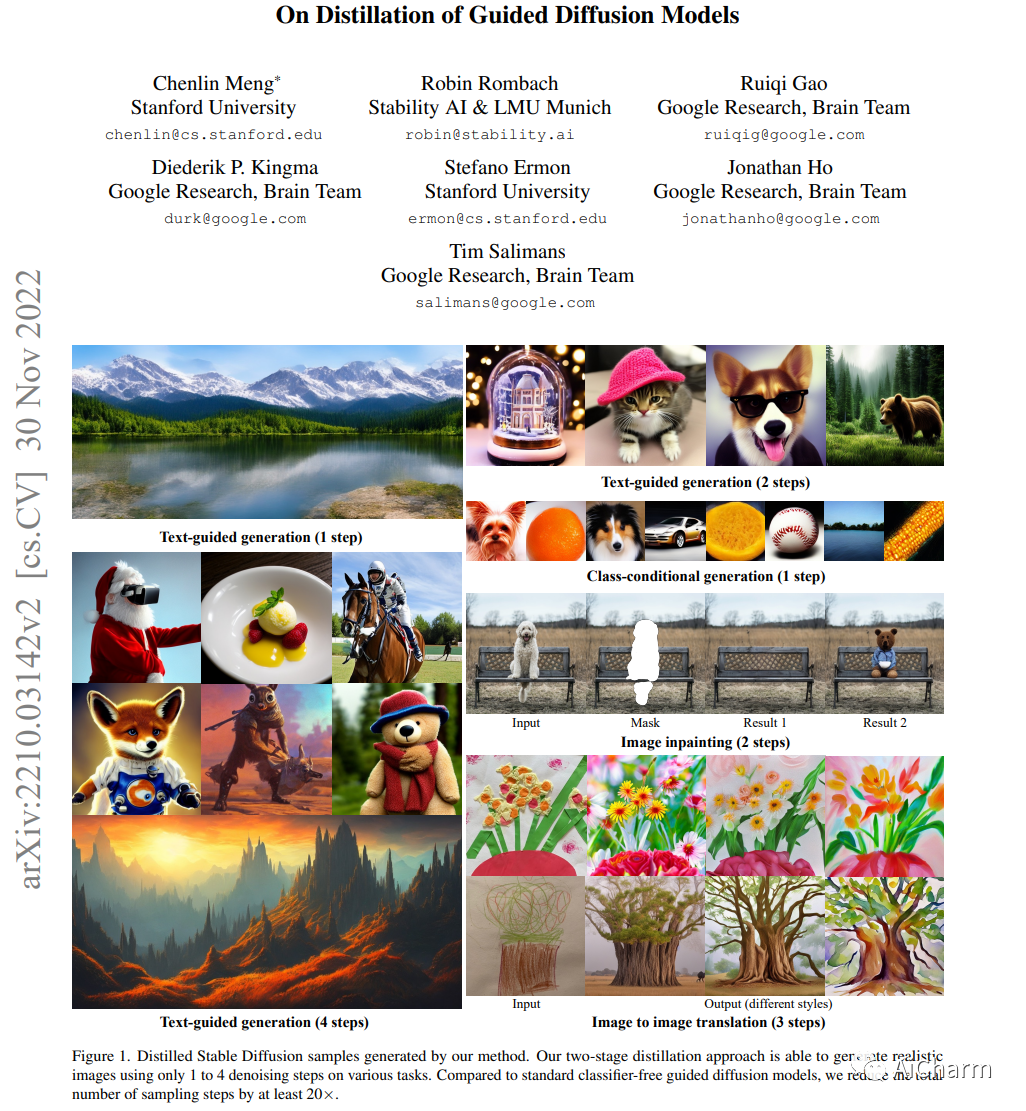

3.On Distillation of Guided Diffusion Models

标题:关于引导扩散模型的蒸馏

作者:Chenlin Meng, Robin Rombach, Ruiqi Gao, Diederik P. Kingma, Stefano Ermon, Jonathan Ho, Tim Salimans

文章链接:https://arxiv.org/abs/2210.03142

最近的研究表明,无分类器引导扩散模型在生成高分辨率图像方面非常成功。然而,这些模型确实存在推理时计算量大的缺点。本文提出了一种将无分类器引导扩散模型提炼为可快速采样的模型的方法:给定一个预训练的无分类器引导模型,作者首先学习一个单一模型来匹配组合条件和无条件的输出模型,然后逐渐将该模型提炼为需要更少采样步骤的扩散模型。在 ImageNet 64x64 和 CIFAR-10 上,本方法能够使用最少 4 个采样步骤生成视觉上与原始模型相当的图像,实现与原始模型相当的 FID/IS 分数,同时高达 256 倍更快地采样。

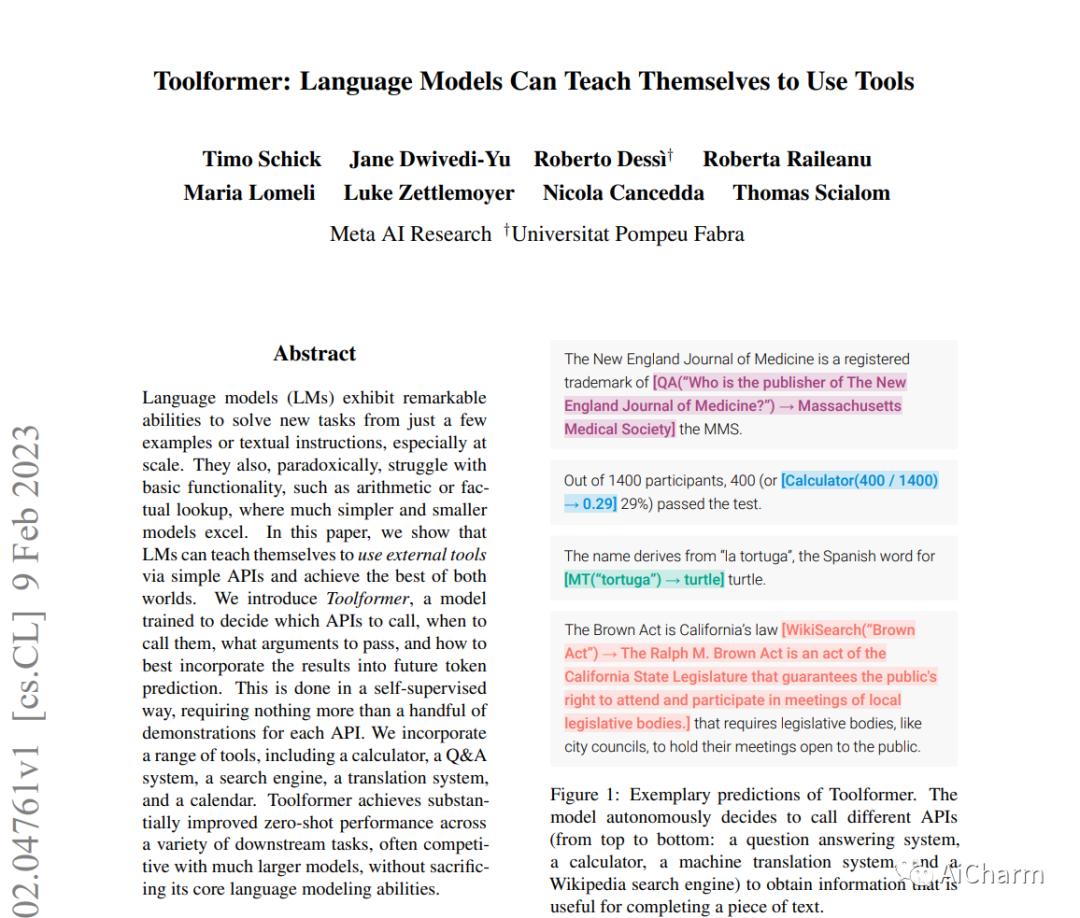

4.Toolformer: Language Models Can Teach Themselves to Use Tools

标题:Toolformer:语言模型可以自学使用工具

作者:Timo Schick,Jane Dwivedi-Yu,Roberto Dessì,Roberta Raileanu,Maria Lomeli,Luke Zettlemoyer,Nicola Cancedda,Thomas Scialo

文章链接:https://arxiv.org/abs/2302.04761

语言模型 (LM) 难以实现基本功能,例如算术或事实查找,而在这些功能中,更简单、更小的模型更胜一筹。本文表明 LM 可以通过简单的 API 自学使用外部工具。他们引入了 Toolformer,这是一个经过训练的模型,可以决定调用哪些 API、何时调用它们、传递哪些参数,以及如何最好地将结果纳入未来的代币预测。这是以自我监督的方式完成的,只需要对每个 API 进行少量演示。它们结合了一系列工具,包括计算器、问答系统、两个不同的搜索引擎、翻译系统和日历。Toolformer 在各种下游任务中实现了显着改进的零样本性能,通常与更大的模型竞争,而不会牺牲其核心语言建模能力。

Notable Papers

5.Hard Prompts Made Easy: Gradient-Based Discrete Optimization for Prompt Tuning and Discovery

标题:硬提示变得简单:基于梯度的离散优化,用于快速调整和发现

文章链接:https://arxiv.org/abs/2302.03668

摘要:

现代生成模型的优势在于它们能够通过基于文本的提示进行控制。典型的“硬”提示由可解释的单词和标记组成,并且必须由人类手工制作。还有“软”提示,由连续的特征向量组成。这些可以使用强大的优化方法发现,但它们不容易解释、跨模型重复使用或插入基于文本的界面。我们描述了一种通过有效的基于梯度的优化来稳健地优化硬文本提示的方法。我们的方法自动为文本到图像和文本到文本应用程序生成基于硬文本的提示。在文本到图像的设置中,该方法为扩散模型创建硬提示,允许 API 用户轻松生成、发现和混合匹配图像概念,而无需事先了解如何提示模型。在文本到文本设置中,我们展示了可以自动发现硬提示,这些提示在调整 LM 以进行分类方面非常有效。

6.A Multitask, Multilingual, Multimodal Evaluation of ChatGPT on Reasoning, Hallucination, and Interactivity

标题:ChatGPT 在推理、幻觉和交互性方面的多任务、多语言、多模态评估

文章链接:https://arxiv.org/abs/2302.04023

摘要:

本文提出了一个框架,用于使用公开可用的数据集定量评估交互式 LLM,例如 ChatGPT。我们使用涵盖 8 种不同的常见 NLP 应用任务的 21 个数据集对 ChatGPT 进行了广泛的技术评估。我们基于这些数据集和新设计的多模式数据集评估了 ChatGPT 的多任务、多语言和多模式方面。我们发现 ChatGPT 在大多数任务上的零样本学习性能优于 LLM,甚至在某些任务上优于微调模型。我们发现它更擅长理解非拉丁脚本语言而不是生成它们。它能够通过中间代码生成步骤从文本提示生成多模式内容。此外,我们发现 ChatGPT 在逻辑推理、非文本推理和常识推理下的 10 个不同推理类别中的平均准确率为 64.33%,因此使其成为不可靠的推理机。例如,它比归纳推理更擅长演绎推理。ChatGPT 与其他 LLM 一样存在幻觉问题,并且由于无法访问外部知识库,它会从参数内存中产生更多的外部幻觉。最后,ChatGPT 的交互功能使人类能够与底层 LLM 协作以提高其性能,即 8% ROUGE-1 用于摘要,2% ChrF++ 用于机器翻译,采用多轮“提示工程”方式。

7.The unreasonable effectiveness of few-shot learning for machine translation

标题:小样本学习对机器翻译的不合理有效性

文章链接:https://arxiv.org/abs/2302.01398

摘要:

我们展示了少样本翻译系统的潜力,该系统使用未配对的语言数据进行训练,适用于高资源和低资源语言对。我们表明,在推理时仅显示 5 个高质量翻译数据的示例,仅使用自监督学习训练的 transformer decoder-only 模型能够与专业的监督最先进模型以及更通用的模型相匹配商业翻译系统。特别是,我们在 WMT'21 英汉新闻翻译任务中仅使用五个英汉并行数据示例就在推理中表现优于最佳系统。此外,我们构建这些模型的方法不需要联合多语言训练或反向翻译,在概念上很简单,并且显示出扩展到多语言环境的潜力。此外,生成的模型比最先进的语言模型小两个数量级。然后,我们分析了影响小样本翻译系统性能的因素,并强调小样本演示的质量在很大程度上决定了我们模型生成的翻译质量。最后,我们展示了少镜头范式也提供了一种控制翻译某些属性的方法——我们展示了我们能够在推理时仅使用五个示例来控制区域多样性和形式,为可控机器铺平道路翻译系统。

期待下周与你相见