脑启发的ANN学习机制综述

脑启发的ANN学习机制综述

CreateAMind

发布于 2023-09-01 08:18:01

发布于 2023-09-01 08:18:01

Brain-inspired learning in artificial neural networks: a review

人工神经网络中的脑启发学习:综述(12000字)

人工神经网络(ann)已经成为机器学习中的一个重要工具,在不同的领域取得了显著的成功,包括图像和语音生成、游戏和机器人。然而,在人工神经网络的操作机制和生物大脑的操作机制之间存在着根本的不同,特别是在学习过程方面。本文对当前人工神经网络中大脑启发的学习表示进行了全面的综述。我们研究了更具生物学意义的机制的整合,如突触可塑性,以增强这些网络的能力。此外,我们深入研究了这种方法带来的潜在优势和挑战。最后,我们为这一迅速发展的领域的未来研究指出了有希望的途径,这将使我们更接近理解智力的本质。

通信:sschmi46@jhu.edu

介绍

记忆和学习之间的动态相互关系是智能生物系统的基本标志。它使有机体不仅能够吸收新知识,而且能够不断完善现有能力,使它们能够熟练地应对不断变化的环境条件。这种适应性特征与各种时间尺度相关,包括通过短期可塑性机制进行的长期学习和快速短期学习,突出了生物神经系统的复杂性和适应性1–3。从大脑中提取高层次灵感的人工系统的开发是跨越几十年的长期科学追求。虽然早期的尝试取得了有限的成功,但最新一代的人工智能(AI)算法在许多具有挑战性的任务中取得了重大突破。这些任务包括但不限于根据人类提供的提示生成图像和文本4–7复杂机器人系统的控制8–10、以及对国际象棋和围棋等策略游戏的掌握11 以及这些的多模式融合12。

虽然人工神经网络在各个领域都取得了显著的进步,但在控制神经网络的能力方面仍有很大的局限性

像生物大脑一样不断学习和适应13–15。与当前的机器智能模型不同,动物可以在整个生命周期中学习,这对稳定适应不断变化的环境至关重要。这种被称为终身学习的能力仍然是人工智能的一个重大挑战,人工智能主要优化由固定标签数据集组成的问题,使其难以概括新任务或在重复学习迭代中保留信息14。应对这一挑战是一个活跃的研究领域,开发具有终身学习能力的人工智能的潜在影响可能会对多个领域产生深远的影响。

在本文中,我们提供了一篇独特的综述,旨在识别启发了当前人工智能算法的大脑机制。为了更好地理解自然智能背后的生物学过程,第一部分将探索塑造神经调节的低水平组件,从突触可塑性到塑造神经活动的局部和全局动力学的作用。这将与第三部分的人工神经网络相关,我们将人工神经网络与生物神经系统进行比较和对比。这将为我们提供一个逻辑基础,试图证明为什么大脑可以为AI提供更多,超越当前人工模型的继承。接下来,我们将深入研究模拟这些过程的人工学习算法,以提高人工智能系统的能力。最后,我们将讨论这些人工智能技术在现实世界中的各种应用,强调它们对机器人、终身学习和神经形态计算等领域的潜在影响。通过这样做,我们旨在提供对生物大脑和人工智能学习机制之间相互作用的全面理解,强调这种协同关系可能带来的潜在好处。我们希望我们的发现将鼓励新一代大脑启发的学习算法。

支持大脑学习的过程

神经科学的一项重大努力旨在确定大脑中学习的深层过程。已经提出了几种机制来解释其生物学基础

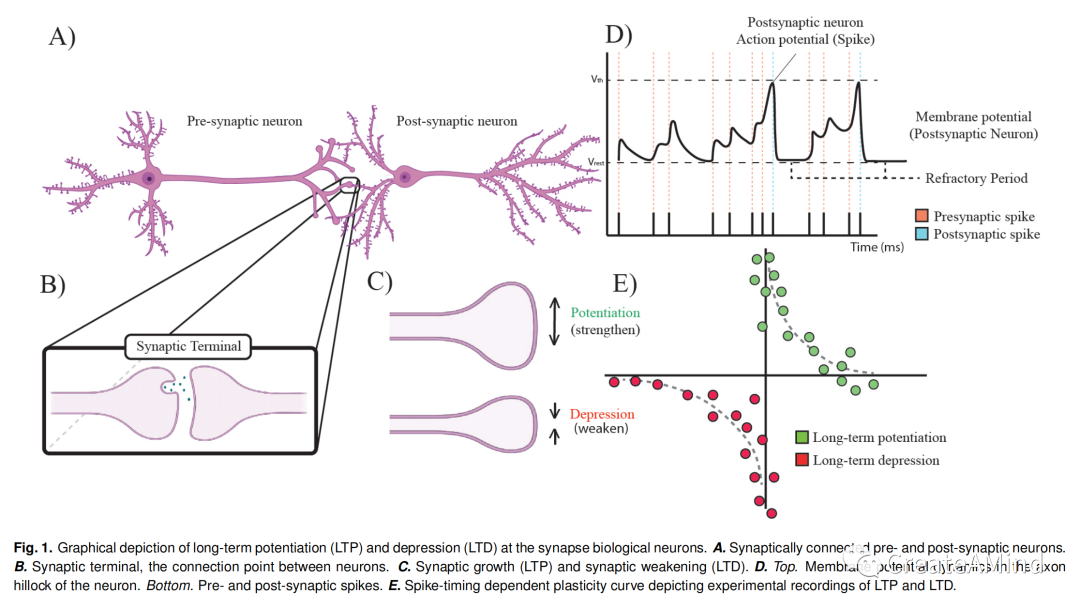

图一。突触生物神经元的长时程增强(LTP)和抑制(LTD)的图示。a .突触连接的突触前和突触后神经元。

B.突触末端,神经元之间的连接点。c .突触生长(LTP)和突触减弱(LTD)。d .托普。神经元轴突小丘中的膜电位动力学。底部。突触前和突触后棘波。e .描绘LTP和LTD的实验记录的尖峰时间依赖性可塑性曲线

从突触到群体水平活动的不同粒度水平的学习。然而,绝大多数生物学上看似合理的学习模式都具有可塑性的特征,这种可塑性来自于局部和全局事件之间的相互作用16。下面,我们将更详细地介绍各种形式的可塑性以及这些过程是如何相互作用的。

突触可塑性

大脑中的突触可塑性是指经验改变神经回路功能的能力。突触的可塑性具体指基于活动的突触传递强度的改变,并且是目前最广泛研究的大脑适应新信息的机制17,18。(Plasticity in the brain refers to the capacity of experience to modify the function of neural circuits. The plasticity of synapses specifically refers to the modification of the strength of synaptic transmission based on activity and is currently the most widely investigated mechanism by which the brain adapts to new information) 突触可塑性有两大类:短期和长期可塑性。短期可塑性在几十毫秒到几分钟的范围内起作用,并且在对感觉刺激的短期适应和短期记忆形成中具有重要作用19。长期可塑性在几分钟到更长的时间内起作用,被认为是长期行为变化和记忆储存的主要过程之一20。

神经调节

除了突触的可塑性,大脑适应新信息的另一个重要机制是神经调节3,21,22。神经调节是指通过化学信号分子(通常称为神经递质或激素)对神经活动的调节。这些信号分子可以改变神经回路的兴奋性和突触的强度,并对神经功能产生短期和长期影响。已经确定了不同类型的神经调节,包括乙酰胆碱、多巴胺和血清张力素,它们与各种功能如注意力、学习和情绪有关23。神经调节已经建议在各种形式的可塑性中发挥作用,包括短-19 和长期可塑性22。

元可塑性

神经元根据活动改变其功能和结构的能力是突触可塑性的特征。发生在突触上的这些变化必须精确地组织起来,以便在正确的时间以正确的数量发生变化。这种可塑性的调节被称为元可塑性,或“突触可塑性的可塑性”,在保护不断变化的大脑免于饱和方面起着至关重要的作用24–26。本质上,变塑通过诱导神经元或突触生理状态的变化来改变突触产生可塑性的能力。超可塑性被认为是记忆稳定性、学习和调节神经兴奋性的基本机制。虽然相似,但化生可以与神经调节区分开,在突触的改变过程中,化生和神经调节事件经常在时间上重叠。

神经发生

新形成的神经整合到现有神经回路的过程称为神经发生。神经发生在胚胎发育期间最为活跃,但也已知在整个成年期都会发生,特别是在侧脑室的脑室下区27杏仁核28和海马结构的齿状回29。在成年小鼠中,与标准实验室条件相比,当生活在丰富的环境中时,神经发生被证明增加30。此外,许多环境因素,如锻炼31,32和压力33,34已经证明可以改变啮齿类动物海马体中的神经发生率。总的来说,虽然神经发生在学习中的作用还不完全清楚,但它被认为在支持大脑中的学习中起着重要的作用。

神经胶质细胞

神经胶质细胞或神经胶质,通过调节突触处的神经递质信号,在支持学习和记忆中起着至关重要的作用,突触是神经元之间释放和接收神经递质的小间隙35。星形胶质细胞是一种神经胶质细胞,可以释放和再摄取神经递质,并对其进行代谢和解毒。这有助于调节大脑中神经递质的平衡和可用性,这对正常的大脑功能和学习至关重要36。小胶质细胞是另一种神经胶质细胞,也可以调节神经递质信号,并参与受损组织的重新配对和再生,这对学习和记忆很重要37。除了修复和调节,突触强度的结构变化需要不同类型的神经胶质细胞的参与,其中最不明显的影响来自星形胶质细胞36。然而,尽管他们的参与至关重要,我们还没有完全了解胶质细胞的作用。了解神经胶质细胞支持突触学习的机制是正在进行的研究的重要领域。

深度神经网络和可塑性

人工神经网络和脉冲神经网络。

在过去的几十年里,人工神经网络在机器学习中发挥了至关重要的作用。这些网络在解决各种挑战性问题方面催化了巨大的进步。人工智能中许多最令人印象深刻的成就都是通过使用经过大量数据训练的大型人工神经网络实现的。虽然有许多技术进步,但人工智能的许多成就可以用计算技术的创新来解释,如大规模GPU加速器和数据的可访问性。虽然大规模人工神经网络的应用带来了重大的创新,但仍存在许多挑战。人工神经网络的一些最紧迫的实际限制是它们在功耗方面效率不高,并且它们不太擅长处理动态和噪声数据。此外,人工神经网络无法学习超出其训练周期(例如,在部署期间)的数据,这些数据呈现独立且同分布(IID)的形式,而没有时间,这不能反映信息在时间和空间上高度相关的物理现实。这些缺陷已经导致它们的应用在大规模设置中需要大量的能量38 并且也向集成到诸如机器人和可穿戴设备的边缘计算设备提出了挑战39。

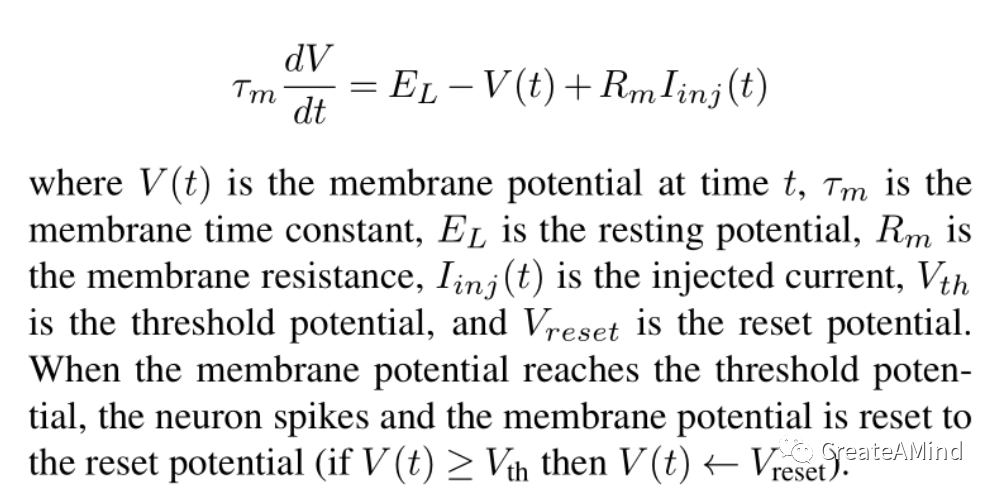

从神经科学中寻找解决方案,研究人员一直在探索脉冲神经网络(SNNs)作为人工神经网络的替代方案40。SNNs是一类人工神经网络,其设计更接近于生物神经元的行为。ann和SNNs之间的主要区别在于SNNs将时间的概念结合到它们的通信中。尖峰神经元以膜电位的形式积累来自相连(突触前)神经元(或通过感觉输入)的信息。一旦神经元的膜电位超过阈值,它向所有传出(突触后)连接发出一个二进制“尖峰”。尽管尖峰信号是二进制的并且在时间上是稀疏的,但是理论上已经证明它比基于速率的信息表示(例如在人工神经网络中)包含更多的信息41。此外,建模研究显示了SNNs的优势,例如更好的能量效率、处理噪声和动态数据的能力,以及更健壮和容错计算的潜力42。这些益处不仅归因于其增加的生物合理性,还归因于脉冲神经网络的独特性质,其将它们与传统的人工神经网络区分开来。下面描述了一个简单的漏积分触发神经元的工作模型:

尽管有这些潜在的优势,snn仍然处于发展的早期阶段,在它们能够被更广泛地使用之前,还有几个挑战需要解决。最紧迫的挑战之一是如何优化这些模型的突触权重,因为传统的基于反向传播的人工神经网络方法由于离散和稀疏的非线性而失败。不考虑这些挑战,确实有一些工作突破了现代尖峰网络的极限,例如基于大尖峰的SpikeGPT模型43。尖峰模型对这篇综述非常重要,因为它们构成了许多大脑启发的学习算法的基础。

Hebbian and spike-timing dependent plasticity

Hebbian和STDP(spike-timing dependent plasticity)是突触可塑性的两个重要模型,在神经回路和行为的形成中起着重要作用。唐纳德·赫布于1949年首次提出的赫布-边学习规则44假设神经元之间的突触在它们相互作用时得到加强,这样一个神经元的激活会导致另一个神经元的激活。另一方面,STDP是最近提出的突触可塑性模型,它考虑了突触前和突触后尖峰的精确定时45 以确定突触的增强或减弱。人们普遍认为,STDP在发育过程中神经回路的形成和完善以及回路对经验的不断适应中起着关键作用。在下面的小节中,我们将提供hebb学习和STDP的基本原理的概述。

hebb

hebb学习基于这样一种观点,即如果两个神经元同时活跃,那么它们之间的突触强度应该增强,反之则减弱。赫布认为,当一个细胞“重复或持续地参与激发”另一个细胞时,这种增加就会发生(有因果关系)。然而,这一原则往往是相互关联的,如著名的格言“细胞一起开火,电线在一起”(不同地归因于sie grid lwel46 或者卡拉·沙茨47)1

Hebbian学习通常用作无监督学习算法,其目标是在没有显式反馈的情况下识别输入数据中的模式48。这个过程的一个例子是Hopfield网络,其中通过对(对称的)权重应用Hebbian规则,大的二进制模式可以容易地存储在全连接的循环网络中49。它还可以适用于监督学习算法,其中规则被修改以考虑网络的期望输出。在这种情况下,希伯恩学习规则与指示给定输入的正确输出的教导信号相结合。

一个简单的Hebbian学习规则可以用下面的等式进行数学描述:

∮wij =ηxixj

其中,∮wij是神经元I和神经元j之间的权重变化,η是学习速率,神经元I中的xi“活动”,通常被认为是神经元放电速率。这条规则规定,如果两个神经元同时被激活,它们的连接应该得到加强。

基本赫比规则的一个潜在缺点是它的不稳定性。例如,如果xi和xj最初是弱正相关的,这个规则将增加两者之间的权重,这将反过来加强相关性,导致甚至更大的权重增加,等等。因此,需要某种形式的稳定。这可以简单地通过限制权重来实现,或者通过更复杂的规则来实现,这些规则考虑了额外的因素,例如突触前和突触后活动的历史或者网络中其他神经元的影响(参见参考文献50 对于许多这样的规则的实际回顾)。

三因素法则:Hebbian强化学习

通过引入关于奖励的信息,Hebbian学习也可以用于强化学习。一个明显可行的想法是简单地将Hebbian更新直接乘以奖励,如下所示:

∮wij = ηxixjR

R是奖励(对于这个时间步或对于整个情节)。不幸的是,这种想法不能产生可靠的强化学习。通过注意到如果wij已经处于其最佳值,这可以直观地感觉到,上述规则仍然会产生净变化,从而驱使wij远离最佳值。

更正式地说,正如弗雷莫等人所指出的53,以正确跟踪输入、输出和回报之间的实际协方差,xixjR乘积中的至少一项必须居中,也就是用围绕其期望值的零均值波动代替。一个可能的解决方案是通过从R中减去一个基线来计算回报,这个基线通常等于这个试验的R的期望值。虽然有帮助,但实际上这种解决方案通常是不够的。

更有效的解决方案是从输出中去除平均值。这可以通过使神经活动xj受到偶然的随机扰动(取自适当的零中心分布)来容易地完成,然后在三因子乘积中使用扰动xj,而不是原始的突触后活动xj:

这就是Fiete和Seung提出的所谓的“节点扰动”规则54,55。直观地说,注意xi xj增量的作用是将未来的XJ响应(当抵消相同的Xi输入时)推向扰动的方向:如果扰动为正,则更大;如果扰动为负,则更小。如果R为正,将这一位移乘以R会将未来的响应推向扰动,如果R为负,则远离扰动。即使R不为零均值,净效应(在预期中)仍将驱使wij向更高的R移动,尽管方差会更高。

这个规则实现了加强算法(Williams的原始论文56 实际上提出了一种算法,这种算法对于脉冲随机神经元来说是精确的节点扰动,从而估计了wij上R的理论梯度。它也可以用生物学上可行的方式实现,允许循环网络从稀疏、延迟的奖励中学习非平凡的认知或运动任务57。

spike-timing dependent plasticity

(STDP)是突触可塑性的理论模型,允许神经元之间的连接强度根据其spike电位的相对时序进行修改。与依赖于突触前和突触后神经元同时激活的赫比学习规则不同,STDP考虑了突触前和突触后尖峰的精确定时。具体来说,STDP认为,如果一个突触前神经元恰好在一个突触后神经元之前激活,那么它们之间的联系应该得到加强。相反,如果突触后神经元恰好在突触前神经元之前触发,那么这种连接应该会被削弱。

已经在多种生物系统中观察到STDP,包括新皮层、海马和小脑。该规则已被证明在神经回路的发育和可塑性中起着至关重要的作用,包括学习和记忆过程。STDP还被用作开发人工神经网络的基础,人工神经网络是用来模仿大脑的结构和功能的。

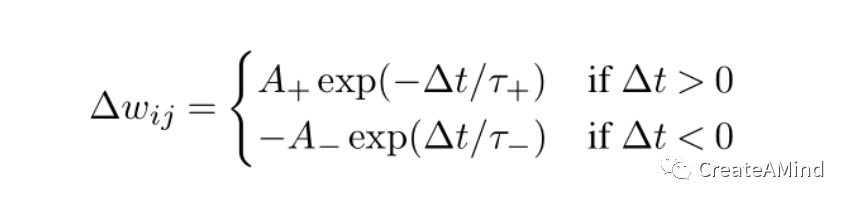

STDP的数学公式比赫比学习规则更复杂,并且可以根据具体的实现而变化。然而,一个常见的公式是:

观点,布朗和他的同事引用威廉·詹姆斯的话:“当两个基本的大脑过程一起或连续活跃时,其中一个在重复出现时,倾向于将其兴奋传播到另一个。”

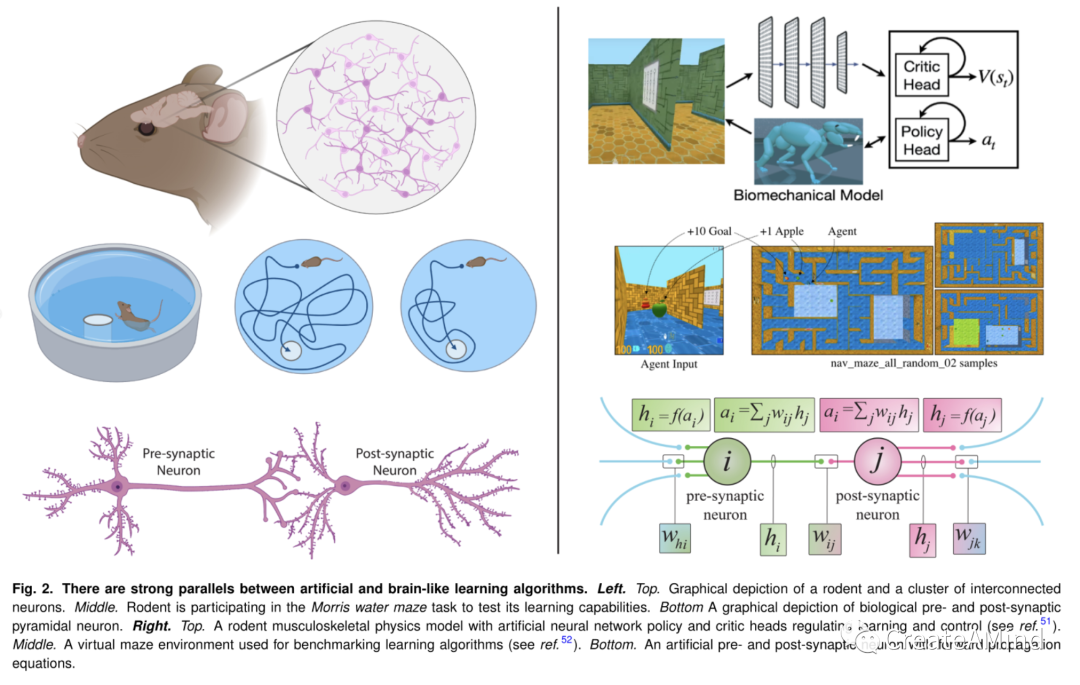

图二。人工和类脑学习算法之间有很强的相似性。左。顶端。啮齿动物和一群相互连接的神经元的图形描述。中间。啮齿动物正在参与莫里斯水迷宫任务,以测试其学习能力。下图描述了生物突触前和突触后锥体神经元。右。顶端。具有人工神经网络策略和调节学习和控制的批判头的啮齿动物肌肉骨骼物理模型(参见参考文献。51).中间。用于基准学习算法的虚拟迷宫环境(参考文献。52).底部。一种具有正向传播方程的人工突触前和突触后神经元。

其中,wij是神经元I和神经元j之间的权重变化,t是突触前和突触后尖峰之间的时间差,A+和A分别是增强和抑制的幅度,τ+和τ分别是增强和抑制的时间常数。该规则规定,两个神经元之间的连接强度将根据它们相对于彼此的尖峰的时间而增加或减少。

支持人工神经网络学习的过程

在人工神经网络中有两种主要的权重优化方法:错误驱动的全局学习和大脑启发的局部学习。在第一种方法中,通过将全局误差驱动到其最小值来修改网络权重。这是通过将误差分配给每个权重并同步每个权重之间的修改来实现的。相比之下,大脑启发的局部学习算法旨在通过使用局部可用信息修改动态方程的权重,以更符合生物学的方式进行学习。这两种优化方法都有独特的优点和缺点。在下面的部分中,我们将讨论最常用的错误驱动全局学习形式,即反向传播,然后深入讨论大脑启发的局部算法。值得一提的是,这两种方法并不相互排斥,为了补充它们各自的优势,通常会将它们集成在一起58–61。

反向传播。

反向传播是一种强大的误差驱动的全局学习方法,它改变神经网络中神经元之间连接的权重,以产生期望的目标行为62。这是通过使用定量指标(目标函数)实现的,该指标描述了给定感觉信息(如视觉输入、书面文本、机器人关节位置)下的行为质量。反向传播算法包括两个阶段:前向传递和后向传递。在前向传递中,输入通过网络传播,然后计算输出。在反向传递期间,计算预测输出和“真实”输出之间的误差,并且通过将误差反向传播通过网络来计算损失函数相对于网络权重的梯度。然后,使用诸如随机梯度下降的优化算法,将这些梯度用于更新网络的权重。这个过程重复多次迭代,直到权重收敛到一组使损失函数最小的值。

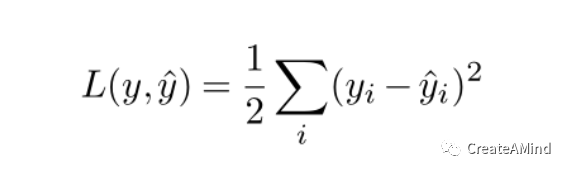

让我们来看看反向传播的简单数学解释。首先,我们定义一个期望损失函数,它是网络输出和真实值的函数:

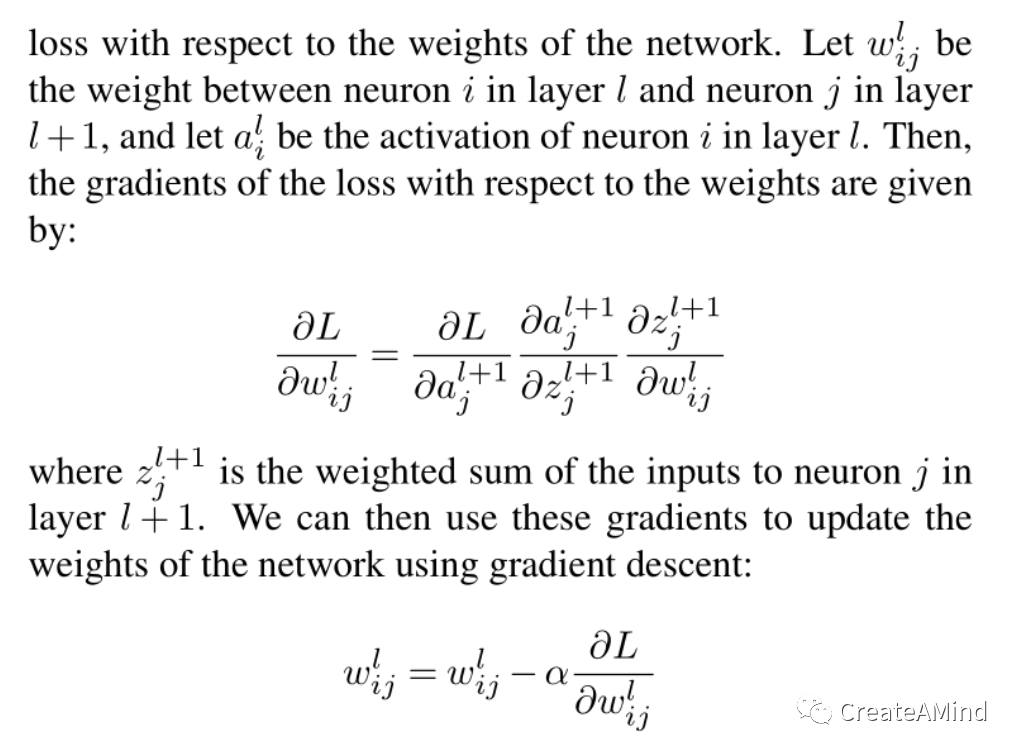

其中y是真实输出,y’是网络输出。在这种情况下,我们将最小化平方误差,但可以很好地优化任何平滑和可微分的损失函数。接下来,我们使用链式法则来计算

相对于网络权重的损失。设wl是层l中的神经元I和层l + 1中的神经元j之间的权重,并且设al是层l中的神经元I的激活。然后,损失相对于权重的梯度由下式给出:

其中,α是学习率。通过重复计算梯度和更新权重,网络逐渐学会最小化损失函数并做出更准确的预测。在实践中,梯度下降法通常与将动量引入梯度估计的方法相结合,这已被证明能显著提高泛化能力63。

反向传播令人印象深刻的成就促使神经科学家研究它是否能更好地理解大脑中的学习。尽管关于反向传播变异是否会发生在大脑中仍有争议64,65很明显,目前的反向传播在生物学上是不合理的。另一种理论认为,复杂的反馈回路或局部活动与自上而下信号的交互作用(第三个因素)可能支持类似的反向传播学习形式64。

尽管它的性能令人印象深刻,但仍然存在基本的算法挑战,这些挑战来自于对网络权重重复应用反向传播。其中一个挑战是一种被称为灾难性遗忘的现象,即神经网络在对新数据进行训练时会忘记之前学习的信息13。当网络根据新数据进行微调时,或者当网络根据一系列任务进行训练而没有保留从以前的任务中学到的知识时,会发生这种情况。灾难性遗忘是开发能够从多样化和不断变化的环境中持续学习的神经网络的一个重大障碍。另一个挑战是反向传播需要通过网络的所有层反向传播信息,这在计算上是昂贵和耗时的,尤其是对于非常深的网络。这可能会限制深度学习算法的可扩展性,并使其难以在有限的计算资源上训练大型模型。尽管如此,对于涉及人工神经网络的应用,反向传播仍然是最广泛使用和最成功的算法

进化和遗传算法。

另一类近年来受到广泛关注的全局学习算法是进化和遗传算法。这些算法受自然选择过程的启发,在人工神经网络的背景下,旨在通过模拟进化过程来优化神经网络的权重。在遗传算法中66用随机权重初始化一组神经网络,并对每个网络的特定任务或问题进行评估。在这项任务中表现较好的网络被选择出来进行繁殖,由此它们产生的后代在权重上略有变化。这一过程会重复几代的操作类似于进化算法,但使用不同的方法来逼近随机梯度67,68。这是通过扰动权重并结合网络目标函数性能来更新参数来实现的。这导致更全面的搜索在寻找最优解时比像back-这样的局部搜索方法更有效

传播69。

这些算法的一个优点是它们能够有效地搜索巨大的参数空间,使它们适合于具有大量参数或复杂搜索空间的问题。此外,它们不需要不同的目标函数,这在目标函数难以定义或计算的情况下是有用的(例如脉冲神经网络)。然而,这些算法也有一些缺点。一个主要的限制是评估和发展大量网络所需的高计算成本。另一个挑战是算法可能陷入局部最优或收敛过快,导致次优解。另外,随机突变的使用会导致学习过程中的不稳定性和不可预测性。

无论如何,进化和遗传算法已经在各种应用中显示出有希望的结果,特别是在优化不可微和非平凡的参数空间时。正在进行的研究集中于提高这些算法的效率和可扩展性,以及发现何时何地使用这些方法代替梯度下降是有意义的。

人工神经网络中学习的脑启发表征

局部学习算法。

与要求信息通过整个网络传播的全局学习算法(如反向传播)不同,局部学习算法专注于基于来自附近或突触连接的神经元的局部信息来更新突触权重。这些方法经常受到生物突触可塑性的强烈启发。正如我们将看到的,通过利用局部学习算法,人工神经网络可以更有效地学习,并适应不断变化的输入分布,使它们更适合现实世界的应用。在这一节中,我们将回顾大脑启发的局部学习算法的最新进展,以及它们在提高人工神经网络的性能和鲁棒性方面的潜力。

反向传播衍生的局部学习。

反向传播衍生的局部学习算法是一类试图模仿反向传播的数学特性。不同于传统的反向传播算法,它涉及通过整个网络反向传播误差信号,反向传播导出的局部学习算法基于使用反向传播计算的局部误差梯度来更新突触权重。这种方法计算效率高,并允许在线学习,使其适合于训练数据不断到达的应用。

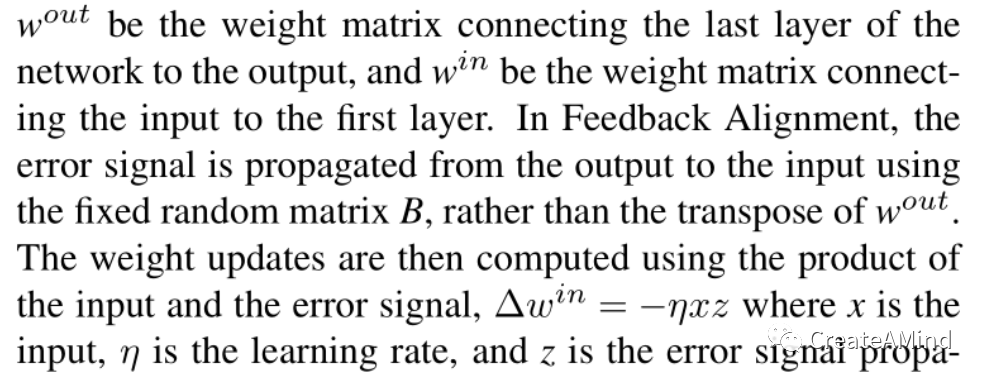

反向传播衍生的局部学习算法的一个突出例子是反馈校准(FA e Feedback Alignment ()算法70,71这用固定的随机矩阵代替了反向传播中使用的权重传输矩阵,允许误差信号从直接连接传播,从而避免了对反向传播误差信号的需要。反馈校准的简单数学描述如下:假设wout是连接网络最后一层到输出的权重矩阵,而win是连接输入到第一层的权重矩阵。在反馈对准中,误差信号使用固定随机矩阵B从输出传播到输入,而不是wout的转置。然后,使用输入和误差信号的乘积来计算权重更新,win = ηxz其中x是输入,η是学习速率,z是通过网络反向传播的误差信号,类似于传统的反向传播。

直接反馈校准71(DFA)通过将输出层误差直接连接到每个隐藏层,与FA相比简化了权重传输链。符号对称(SS)算法类似于FA,除了反馈权重对称地共享符号。虽然FA在MNIST和CIFAR这样的小数据集上表现出了令人印象深刻的结果,但它们在ImageNet这样的大数据集上的性能通常是次优的72。另一方面,最近的研究表明,即使在大规模数据集上,SS算法也能够获得与反向传播算法相当的性能73。

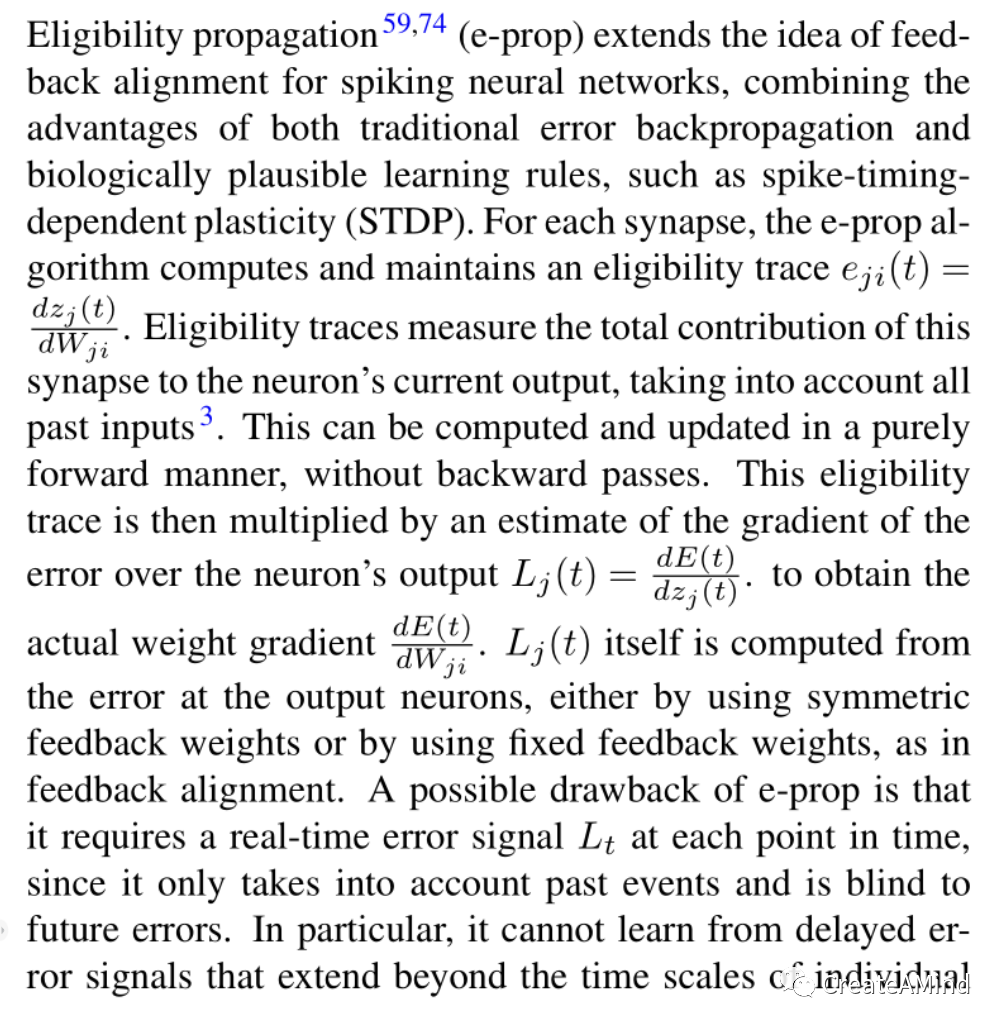

资格传播59,74 (e-prop)扩展了脉冲神经网络反馈校准的思想,结合了传统误差反向传播和生物学似是而非的学习规则的优点,如脉冲定时相关的可塑性(STDP)。对于每个突触,e-prop算法计算并维护一个合格轨迹

输出神经元的误差,通过使用对称的

反馈权重或通过使用固定的反馈权重,如在反馈校准中。e-prop的一个可能的缺点是,它需要在每个时间点的实时误差信号Lt,因为它只考虑过去的事件,而对未来的误差视而不见。特别是,它不能从超出个人时间范围的延迟误差信号中学习神经元(包括短期适应)59与加强法和节点扰动法相反。

在本参考文献的工作中。75,76 基于最近遗传学发现的突触学习规范理论77神经元信号传递结构的研究。他们提出,神经元通过细胞类型特异性的局部神经调节将它们对学习结果的贡献传达给附近的神经元,并且神经元类型多样性和神经元类型特异性的局部神经调节可能是生物学分分配难题的关键部分。在这项工作中,作者建立了一个基于eligibility propagation的简化计算模型来探索这一理论,并表明他们的模型,包括多巴胺样时间差和神经肽样局部调节信号,导致了对先前方法如e-prop和反馈校准的改进。

泛化属性

深度学习中的泛化属性技术在理解其学习算法的泛化方面取得了巨大的进步。一个特别有用的发现是平坦的极小值倾向于导致更好的一般化78。这意味着,给定参数空间(突触权重值)中的扰动ϵ,在更窄的最小值附近观察到更显著的性能下降。在参数空间中找到更平坦的最小值的学习算法最终导致更好的泛化。

最近的工作已经探索了由(大脑启发的)反向传播导出的局部学习规则所表现出的泛化特性79。与通过时间的反向传播相比,反向传播导出的局部学习规则表现出更差和更多变量的泛化,由于梯度近似与真实梯度不太一致,这种泛化不能通过缩放步长来改善。虽然优化过程的局部近似比它们的完整对应物具有更差的泛化属性可能不足为奇,但这项工作为提出新的问题打开了大门,即设计大脑启发的学习算法的最佳方法是什么。这也提出了一个问题,即反向传播衍生的局部学习规则是否值得探索,因为它们从根本上来说将表现出低于标准的一般化。

总之,虽然反向传播衍生的局部学习规则作为设计大脑启发的学习算法的一种有前途的方法出现,但它们具有必须解决的局限性。这些算法的通用性差,突出了进一步研究的需要,以提高它们的性能,并探索替代的大脑启发的学习规则。这也提出了一个问题,即反向传播衍生的局部学习规则是否值得探索,因为它们基本上会表现出低于标准的泛化能力。

元优化可塑性规则。

元优化的可塑性规则在错误驱动的全局学习和大脑启发的局部学习之间提供了有效的平衡。元学习可以被定义为自动搜索学习算法本身,而不是依赖人类工程学为了描述一个学习算法,采用了一个寻找该算法的搜索过程80。元学习的思想自然延伸到大脑启发的学习算法,这样大脑启发的学习机制本身可以被优化,从而允许发现更有效的学习,而无需手动调整规则。在接下来的部分,我们将从可微分优化的突触可塑性规则开始,讨论这一研究的各个方面。

可微分可塑性

在文献中这一原理的一个实例是可微分可塑性,它是一个框架,专注于通过梯度下降优化神经网络中的突触可塑性规则81,82。在这些规则中,塑性规则以这样的方式描述,即控制其动力学的参数是可微的,允许反向传播用于塑性规则参数的元优化(例如,简单赫比规则中的η项或STDP规则中的A+项)。这允许权重动态精确地解决需要在执行时间期间优化权重的任务,这被称为寿命内学习。

可微分的可塑性规则也能够对神经调节动力学进行可微分的优化60,82。这个框架包括神经调制的两个主要变体:全局神经调制,其中权重变化的方向和幅度由网络输出相关的全局参数控制,以及追溯神经调制,其中过去活动的效果由短时间窗口内的多巴胺样信号调制。这是通过使用资格跟踪来实现的,资格跟踪用于跟踪哪些突触促成了最近的活动,多巴胺信号调节这些跟踪到实际塑性变化的转换。

涉及可微可塑性的方法在顺序联想任务的广泛应用中得到了改进83熟悉度检测84和机器人噪音适应60。这种方法也被用来优化短期塑性规则84,85其在强化和时间监督学习问题中表现出改进的性能。虽然这些方法显示出很大的前景,但不同的可塑性方法需要大量的内存,因为反向传播用于随时间优化每个突触的多个参数。这些方法的实际进展可能需要参数共享86 或者更节省内存的反向传播形式87。

脉冲神经元的可塑性

最近在通过具有替代梯度的脉冲神经元的不可微分部分反向传播方面的进展已经允许使用不同的可塑性来优化脉冲神经网络中的可塑性规则60。参考文献。61这种优化范例的能力通过使用可微分的尖峰时间相关的可塑性规则来展示,以在在线单次连续学习问题和在线单次图像类别识别问题上实现“学会学习”。类似的方法被用来优化第三个因子信号使用e-prop的梯度近似作为塑性规则,引入e-prop的元优化形式88。由进化调整的递归神经网络也可以用于元优化的学习规则。进化神经单元89 (枚举)引入门控结构,控制如何处理、存储输入和更新动态参数。这项工作证明了单个神经元体细胞和突触间隔模型的进化,并表明神经元网络可以学习解决T-迷宫环境任务,独立发现脉冲动力学和强化型学习规则。

Plasticity in RNNs and Transformers

独立于旨在使用更新规则学习可塑性的研究,变压器最近被证明是良好的终生学习者5,90,91。情境学习的过程不是通过更新突触权重来进行的,而是纯粹在网络激活中进行的。像变形金刚一样,这个过程也可能发生在递归神经网络中92。虽然情境学习似乎是一种不同于突触可塑性的机制,但这些过程已被证明表现出很强的相关性。文献中讨论的一个令人兴奋的联系是认识到元学习者的参数共享经常导致将激活解释为权重93。这表明,虽然这些模型可能具有固定的权重,但它们表现出与具有塑料权重的模型相同的学习能力。另一个联系是,变形金刚中的自我关注包括外部和内部产品,它们可以被转换为学习到的重量更新94 甚至可以实现梯度下降95,96。

进化和遗传元优化

很像可微塑性,进化和遗传算法已被用于优化各种应用的塑性规则的参数97,包括:适应机器人系统的肢体损伤98,99。最近的工作还通过使用笛卡尔遗传程序优化了塑性系数和塑性规则方程100,提出了一种基于正在解决的特定任务来发现生物学上的可塑性规则的自动化方法。在这些方法中,遗传或进化优化过程类似于微分过程,使得它在外环过程中优化可塑性参数,而可塑性规则在内环过程中优化回报。这些方法是有吸引力的,因为与可微分方法相比,它们具有低得多的内存足迹,因为它们不需要随时间反向传播误差。然而,虽然内存效率高,但它们通常需要大量数据才能获得与基于梯度的方法相当的性能101。

自我参照元学习

突触可塑性有两个层次的学习,元学习者和发现的学习规则,自我参照元学习102,103扩展了这种层次结构。在可塑性方法中,仅更新网络参数的子集(例如突触权重),而元学习更新规则在元优化后保持固定。

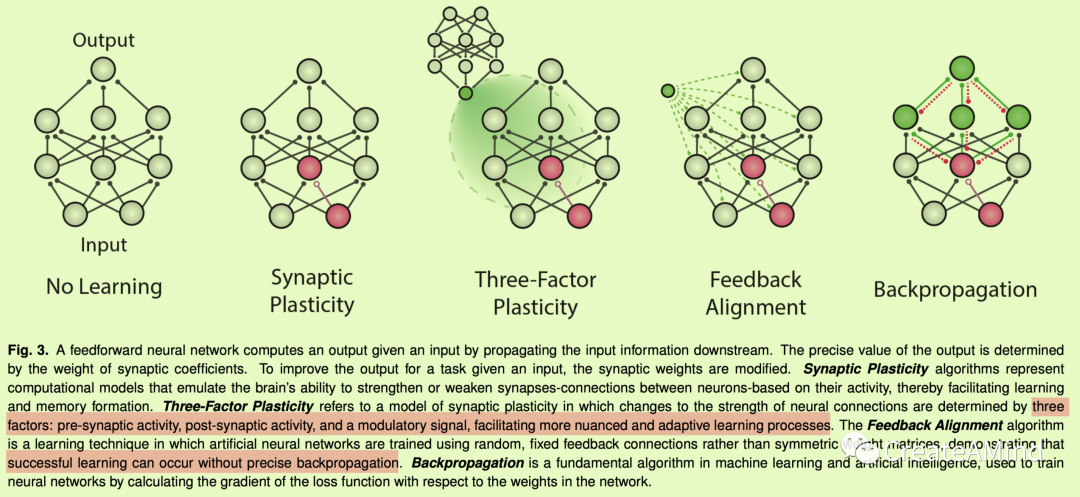

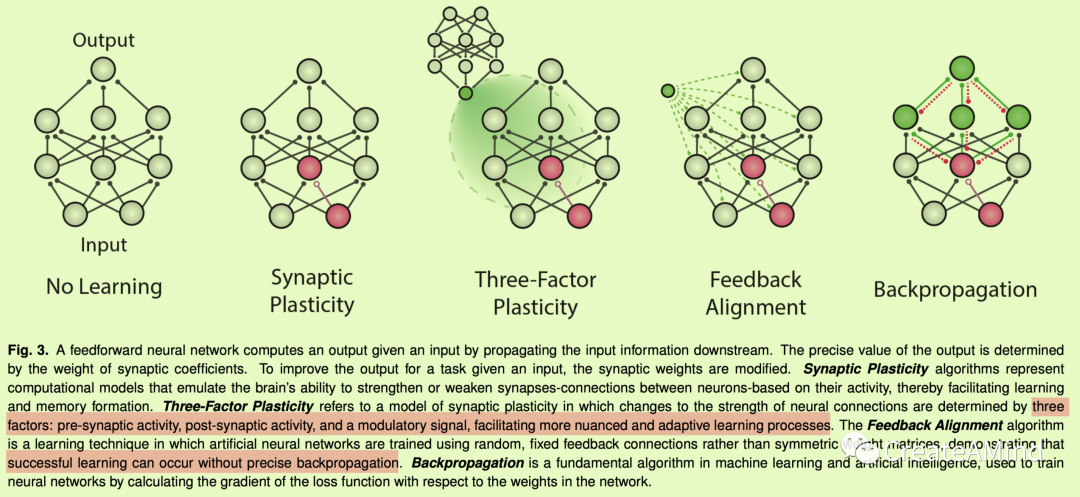

图3。前馈神经网络通过向下游传播输入信息来计算给定输入的输出。输出的精确值由突触系数的权重决定。为了在给定输入的情况下提高任务的输出,突触权重被修改。突触可塑性算法代表了一种计算模型,它模拟了大脑根据神经元的活动来加强或削弱突触(神经元之间的连接)的能力,从而促进学习和记忆的形成。三因素可塑性指的是一种突触可塑性模型,其中神经连接强度的变化由三个因素决定:突触前活动、突触后活动和调节信号,促进了更细致和适应性更强的学习过程。反馈校准算法是一种学习技术,其中使用随机的、固定的反馈连接而不是对称的权重矩阵来训练人工神经网络,证明了成功的学习可以在没有精确的反向传播的情况下发生。反向传播是机器学习和人工智能中的基本算法,用于通过计算损失函数相对于网络中权重的梯度来训练神经网络。

自引用架构使神经网络能够以递归方式修改其所有参数。因此,学习者也可以修改元学习者。这在原则上允许任意级别的学习、元学习、元元学习等。一些方法对这种系统的参数初始化进行元学习102,104。找到这个初始化仍然需要一个硬连线的元学习者。在其他作品中,网络自我修改的方式甚至消除了这种元学习者103,105。有时,待发现的学习规则具有结构搜索空间限制,这简化了自我改进,其中基于梯度的优化器可以发现自身106 或者进化算法可以优化自身107。尽管它们有所不同,但突触可塑性和自我参照方法都旨在实现神经网络的自我改进和适应。

元优化学习规则的推广所发现的学习规则推广到多种任务的范围是一个重要的未决问题——特别是,它们何时应该取代人工导出的通用学习规则,如反向传播?对这些方法提出挑战的一个特别观察是,当搜索空间很大并且对学习机制几乎没有限制时92,108,109概括变得更加困难。然而,为了修正这一点,在变量共享元学习93 灵活的学习规则由参数共享的递归神经网络来参数化,该网络局部交换信息以实现学习算法,该算法概括了在元优化期间没有看到的分类问题。对于强化学习算法的发现也显示了类似的结果110。

脑启发学习的应用

神经形态计算神经形态计算代表了计算系统设计中的范式转变,其目标是创建模拟生物大脑的功能结构的硬件42,111,112。这种方法旨在开发人工神经网络,不仅复制大脑的学习能力,还复制其能量效率和固有的并行性。神经形态计算机系统通常包含专门的硬件,如神经形态芯片或忆阻设备,以实现大脑启发的学习算法的有效执行112。这些系统有可能极大地提高机器学习应用程序的性能,特别是在边缘计算和实时处理场景中。

神经形态计算的一个关键方面在于开发专门的硬件体系结构,这些硬件体系结构有助于实现脉冲神经网络,这更类似于生物神经元的信息处理机制。神经形态系统基于大脑启发的局部学习原理运行,这使得它们能够实现高能效、低延迟处理和抗噪声的鲁棒性,这对于现实世界的应用来说是至关重要的113。脑启发学习技术与神经形态硬件的集成对于这项技术的成功应用至关重要。

近年来,神经形态计算的进步导致了各种平台的发展,如英特尔的Loihi114,IBM的TrueNorth115,和SpiNNaker116116,它为实现SNNs和大脑启发的学习算法提供了专门的硬件架构。这些平台为进一步探索神经计算系统提供了基础,使研究人员能够设计、模拟和评估新的神经网络结构和学习规则。随着神经形态计算的不断进步,预计它将在人工智能的未来发挥关键作用,推动创新,并实现更高效、多功能和生物合理的学习系统的开发。

机器人学习

神经网络中大脑启发的学习有可能通过启用机器人来克服机器人领域中目前存在的许多挑战

以更灵活的方式学习和适应他们的环境117,118。传统的机器人系统依赖于预编程的行为,这些行为在适应不断变化的条件的能力方面受到限制。相比之下,正如我们在这篇综述中所展示的,神经网络可以通过基于它们接收的数据调整它们的内部参数来训练以适应新的情况。

由于它们与机器人的天然关系,大脑启发的学习算法在机器人领域有着悠久的历史117。为此,突触可塑性规则已被引入,以适应机器人的行为领域的变化,如运动增益和粗糙的地形60,119–121 以及用于避障122–124和铰接(臂)控制125,126。大脑启发的学习规则也被用来探索学习如何在昆虫大脑中发生,使用机器人系统作为具体化的媒介127–130。

深度强化学习(DRL)代表了大脑启发的学习算法的重大成功,它将神经网络的优势与大脑中的强化学习理论相结合,以创建能够通过与环境交互来学习复杂行为的自主代理131–133。通过利用模拟多巴胺神经元活动的奖励驱动的学习过程134与最小化例如分类或回归误差相反,DRL算法指导机器人学习最佳策略以实现它们的目标,即使在高度动态和不确定的环境中135,136。这种强大的方法已经在各种机器人应用中得到证实,包括灵巧操作、机器人移动137,以及多智能体协调138。

终身学习和在线学习

终身学习和在线学习是脑启发学习在人工智能中的重要应用,因为它们使系统能够适应不断变化的环境并不断获得新的技能和知识14。相比之下,传统的机器学习方法通常在固定的数据集上训练,缺乏适应新信息或变化环境的能力。成熟的大脑是终身学习的一个不可思议的媒介,因为它在一生中不断学习,同时保持相对固定的大小139。正如这篇综述所表明的那样,与大脑类似,被赋予大脑启发的学习机制的神经网络可以被训练来不断学习和适应,随着时间的推移提高它们的性能。

使人工系统能够展示这种能力的脑启发学习算法的发展有可能显著增强它们的性能和能力,并对各种应用具有广泛的影响。这些应用在数据缺乏或收集费用昂贵的情况下特别有用,例如在机器人领域140 或者自治系统141因为它允许系统实时学习和适应,而不是在学习发生之前需要收集和处理大量数据。

终身学习领域中的一个主要目标是缓解与人工神经网络中持续应用反向传播相关的一个主要问题,即一种现象被称为灾难性遗忘13。灾难性遗忘是指人工神经网络在学习新数据时突然忘记以前学习过的信息的倾向。发生这种情况是因为最初为早期任务优化的网络中的权重被彻底改变以适应新的学习,从而擦除或覆盖了先前的信息。这是因为反向传播算法在促进新的学习的同时,并不固有地考虑保存先前获取的信息的需要。几十年来,解决这个问题一直是人工智能领域的一个重大障碍。我们假设,通过使用模拟大脑动态学习机制的大脑启发学习算法,我们可能能够利用生物有机体固有的熟练解决问题的策略。

为了理解大脑

人工智能和神经科学的世界已经从彼此身上受益匪浅。专门为某些任务定制的深度神经网络在处理空间信息的方式上与人脑有着惊人的相似之处142–144 和视觉145–147 信息。这种重叠暗示了人工神经网络(ann)作为有用模型的潜力,有助于我们更好地理解大脑的复杂机制。一个被称为神经连接主义者研究计划的新运动148 体现了这种结合的方法,使用人工神经网络作为计算语言来形成和测试关于大脑如何计算的想法。这种观点汇集了不同的研究成果,提供了一个通用的计算框架和工具来测试关于大脑的特定理论。

虽然这篇综述强调了一系列模拟大脑功能的算法,但我们仍然有大量的工作要做,以完全掌握学习在大脑中实际上是如何发生的。使用反向传播和类似反向传播的局部学习规则来训练大型神经网络可以为大脑功能建模提供良好的起点。人们进行了大量卓有成效的研究,以了解大脑中哪些过程的运作与反向传播相似64,导致神经科学的新观点和理论。尽管目前形式的反向传播可能不会在大脑中发生,但尽管学习机制如此不同,大脑可能会发展出与人工神经网络相似的内部表示,这一想法是一个令人兴奋的开放性问题,可能会导致对大脑和人工智能的更深入理解。

探索现在正从静态网络动力学扩展到揭示时间功能的网络,就像大脑一样。随着我们在持续和终身学习中进一步开发算法,我们的模型需要更紧密地反映自然界中观察到的学习机制,这一点可能会变得很清楚。这种焦点的转移要求将局部学习规则——那些反映大脑自身方法的规则——整合到人工神经网络中。

我们确信,在人工神经网络中采用更具生物学真实性的学习规则不仅会产生上述益处,而且还会为神经科学研究者指明正确的方向..换句话说,这是一个有双重好处的策略:它不仅有望振奋工程上的创新,但它也让我们更接近解开大脑中错综复杂的过程。有了更现实的模型,我们可以从人工智能的新视角更深入地探索大脑计算的复杂性。

结论

在这篇综述中,我们研究了将更符合生物学原理的学习机制整合到人工神经网络中。这种进一步的整合对神经科学和人工智能来说都是重要的一步。这与人工智能在大型语言模型和嵌入式系统方面取得的巨大进步尤其相关,这迫切需要更节能的学习和执行方法。此外,虽然人工神经网络在这些应用方面取得了很大进展,但它们像生物大脑一样适应的能力仍然有很大的局限性,我们认为这是大脑启发学习机制的主要应用。

当我们为神经科学和人工智能之间更详细的大脑启发的学习算法的未来合作制定战略时,重要的是要承认神经科学对人工智能的过去影响很少是关于现成的解决方案对机器的直接应用149。更常见的是,神经科学通过提出关于动物学习和智力方面的有趣的算法级问题来刺激人工智能研究人员。它为支持学习的重要机制提供了初步的指导。我们的观点是,通过利用来自神经科学的观点,我们可以大大加速人工神经网络中使用的学习机制的进步。同样,在人工智能中使用类脑学习算法的实验可以加速我们对神经科学的理解。

承认

我们感谢OpenBioML collaborate workspace,本书的几位作者都是通过它联系在一起的。这份材料是基于国家科学基金会研究生研究基金DGE2139757的资助。

abs:

Artificial neural networks (ANNs) have emerged as an essential tool in machine learning, achieving remarkable success across diverse domains, including image and speech generation, game playing, and robotics. However, there exist fundamental differences between ANNs’ operating mechanisms and those of the biological brain, particularly concerning learning processes.

This paper presents a comprehensive review of current braininspired learning representations in artificial neural networks.

We investigate the integration of more biologically plausible mechanisms, such as synaptic plasticity, to enhance these networks’ capabilities. Moreover, we delve into the potential advantages and challenges accompanying this approach.

Ultimately, we pinpoint promising avenues for future research in this rapidly advancing field, which could bring us closer to understanding the essence of intelligence.

1.运动学习与发展的时间尺度。

心理评论108,57 (2001)。

2.前额叶皮层的“活动-沉默”工作记忆:一个动态编码框架。认知科学趋势19,394–405(2015)。

3.Gerstner,w .,Lehmann,m .,Liakoni,v .,Corneil,D. & Brea,j .行为时间尺度上的资格痕迹和可塑性:新希伯来人三因素学习规则的实验支持。神经回路前沿12,53 (2018)。

4.科学文本的预训练语言模型。

arXiv预印本arXiv:1903.10676 (2019)。

5.语言模型是一次性学习者。神经信息处理系统进展33,1877–1901(2020)。

6.Ramesh,a .、Dhariwal,p .、Nichol,a .、Chu,c .、Chen,m .带剪辑潜在时间的分层文本条件图像生成。arXiv预印本arXiv:2204.06125 (2022)。

7.具有深层语言理解的真实感文本到图像扩散模型。arXiv预印本arXiv:2205.11487 (2022)。

8.Kumar,a .,Fu,z .,Pathak,d .和Malik,J. Rma:腿式机器人的快速运动适应。

arXiv预印本arXiv:2107.04034 (2021)。

9.学习野外四足机器人的强健感知运动。

科学机器人学7,eabk2822 (2022)。

10.深部全身控制:学习操纵和运动的统一策略。arXiv预印本arXiv:2210.10044 (2022)。

11.一种通用的强化学习算法,精通国际象棋、日本象棋和自我游戏。科学362,1140–1144(2018)。

12.一个具体化的多模态语言模型。arXiv预印本arXiv:2303.03378 (2023)。

13.克服神经网络中的灾难性遗忘。美国国家科学院院刊114,3521–3526(2017)。

14.帕里西,G. I .,凯姆克尔,r .,Part,J. L .,卡南,c .和韦姆特,s,《神经网络的持续终生学习:综述》。神经网络113,54–71(2019)。

15.终生学习机器的生物学基础。自然机器智能4,196–210(2022)。

16.何伟民,李振亚,马丁,郑国成。突触可塑性的细胞生物学。科学334,623–628(2011)。

17.突触可塑性:多种形式、功能和机制。

神经精神药理学33,18–41(2008)。

18.突触的可塑性是长期记忆储存的机制吗?NPJ学习科学4,1–10(2019)。

19.短期突触可塑性。生理学年度评论

64, 355–405 (2002).

20.与长期突触可塑性相关的树突棘的形态学变化。神经科学年度评论24,1071–1089(2001)。

21.神经调节的锋电位时间依赖性可塑性和三因素学习规则理论。神经回路前沿9,85 (2016)。

22.锋电位时间依赖性可塑性的神经调节:过去、现在和未来。神经元103,563–581(2019)。

23.大脑状态和行为的神经调节。神经科学年度评论43,391–415(2020)。

24.亚巴郎,W. C .和贝尔,M. F.《超可塑性:突触可塑性》。神经科学趋势19,126–130(1996)。

25.可塑性:为可塑性调整突触和网络。《自然》杂志重新评论神经科学9,387–387(2008)。

26.超塑性模型:概念回顾。计算神经科学前沿9,138 (2015)。

27.Lim,D. A. & Alvarez-Buylla,a.《成人室管-室下区(v-svz)和ol- factory球(ob)神经发生》.生物学中的冷泉港观点8,a018820 (2016)。

28.人类杏仁核生后神经发生的证据。通信生物学5,1–8(2022)。

29.成年大鼠齿状回的神经发生:神经元祖细胞增殖的年龄相关减少。神经科学杂志16,2027–2033(1996)。

30.衰老齿状回中经验诱导的神经发生。神经科学杂志18,3206–3212(1998)。

31.运动增强老年小鼠的学习和海马神经发生。神经科学杂志25,8680–8685(2005)。

32.诺基亚,M. S .等人体育锻炼增加雄性大鼠成年海马神经发生,只要它是有氧的和持续的。生理学杂志594,1855–1873(2016)。

33.急性应激通过分泌的星形胶质细胞fgf2增强成年大鼠海马神经发生和新生神经元的激活。Elife 2,e00362 (2013)。

34.间歇性禁食增加成人海马神经发生。大脑与行为10,e01444 (2020)。

35.突触可塑性中的胶质细胞。

生理学杂志-巴黎99,75–83(2006)。

36.星形胶质细胞控制突触的形成、功能和消除。生物学中的冷泉港观点7,a020370 (2015)。

37.小胶质细胞对突触可塑性的调节与学习和记忆。神经再生研究17,705 (2022)。

38.《深度学习推理中的计算和能量消耗趋势》。arXiv预印本arXiv:2109.05472 (2021)。

39.边缘设备上的节能深度学习推理。《计算机进展》,第122卷,247–301页(Elsevier,2021年)。

40.用尖峰神经元进行深度学习:机遇与挑战。

神经科学前沿12,774 (2018)。

41.脉冲神经元网络:第三代神经网络模型。

神经网络10,1659–1671(1997)。

42.神经形态计算算法和应用的机会。自然计算科学2,10–19(2022)。

43.朱瑞珍,赵,Q. & Eshraghian,J. K. Spikegpt:基于脉冲神经网络的生成式预训练语言模型。arXiv预印本arXiv:2302.13939 (2023)。

44.行为的组织:神经心理学理论(心理学出版社,2005)。

45.Markram,h .,Gerstner,w .和Sjö strö,P. J.《锋电位时间依赖性可塑性的历史》。

突触神经科学前沿3,4 (2011)。

46.通过相关神经元活动选择视觉皮层的内在水平连接。科学255,209–212(1992)。

47.发育中的大脑。《科学美国人》267,60–67(1992)。

48.Gerstner,w .,Kistler,W. M .,Naud,r .和Paninski,l .《神经元动力学:从单个神经元到认知的网络和模型》(剑桥大学出版社,2014年)。

49.具有紧急集体计算能力的神经网络和物理系统。美国国家科学院院刊79,2554–2558(1982)。

50.在记忆神经形态硬件上实现的神经可塑性规则的稳定性评论。2011年国际神经网络联合会议,2563–2569(IEEE,2011)。

51.老鼠的视觉皮层作为一个有限的资源系统,自我学习一个生态学的一般表征。bior XIV 1–37(2022)。

52.无监督辅助任务的强化学习。学习表征国际会议。

53.奖励调制的功能要求

锋电位时间依赖性可塑性。神经科学杂志30,13326–13337(2010)。

54.通过电导的动态干扰在脉冲神经网络中进行梯度学习。物理评论快报97,048104 (2006)。

55.基于神经电导动态扰动梯度估计的鸟鸣学习模型。神经生理学杂志98,2038–2057(2007)。

56.联结主义强化学习的简单统计梯度跟踪算法。强化学习5–32(1992)。

57.循环神经网络中的生物似是而非的学习再现了认知任务中观察到的神经动力学。Elife 6,e20899 (2017)。

58.tolman-eichenbaum机器:通过海马结构中的泛化统一空间和相对记忆。183号,1249–1263(2020)。

59.脉冲神经循环网络学习困境的解决方案。《自然通讯》11,3625 (2020)。

60.Schmidgall,s .,Ashkanazy,j .,Lawson,W. & Hays,J. Spikepropamine:脉冲神经网络中的可微分可塑性。神经机器人前沿120 (2021)。

61.Meta-spike-propamine:学习学习脉冲神经网络中的突触可塑性。神经科学前沿。

62.通过反向传播误差学习表征。自然323,533–536(1986)。

63.梯度下降优化算法综述。arXiv预印本arXiv:1609.04747 (2016)。

64.莉莉卡普、T. P .、桑托罗、马瑞斯、l .、阿克曼、C. J. &辛顿、g.《反向传播与大脑》。《自然评论神经科学》21,335–346(2020)。

65.大脑中错误反向传播的理论。认知科学趋势23,235–250(2019)。

66.遗传算法。《科学美国人》267,66–73(1992)。

67.进化计算:统一的方法。在2016年遗传和进化计算会议的会议录中,185–199(2016)。

68.进化策略作为强化学习的可扩展替代方案。arXiv预印本arXiv:1703.03864 (2017)。

69.张,x,Clune,J. & Stanley,K. O。开放演化策略与随机梯度下降的关系。arXiv预印本arXiv:1712.06564 (2017)。

70.随机反馈权重支持深度神经网络中的学习。arXiv预印本arXiv:1411.0247 (2014)。

71.直接反馈校准在深度神经网络中提供学习。神经信息处理系统进展29 (2016)。

72.评估生物驱动的深度学习算法和架构的可扩展性。神经信息处理系统进展31 (2018)。

73.肖,w,陈,h,廖,q和波焦,t。生物似是而非的学习算法可以扩大到大型数据集。arXiv预印本arXiv:1811.03567 (2018)。

74.Bellec,g .等人的资格跟踪提供了一个数据启发的替代通过时间反向传播。在真实神经元隐藏单元:neu- roscience与人工智能交汇处的未来方向@ NeurIPS 2019 (2019)。

75.Liu,Y. H .,Smith,s .,Mihalas,s .,Shea-Brown,e .和Sümbül,u .细胞类型特异性神经调节在脉冲神经网络中指导突触信用分配。美国国家科学院院刊118,e2111821118 (2021)。

76.刘,Y. H .,史密斯,s .,米哈拉斯,s .,谢伊-布朗,e . & sümbu l,u .通过局部神经调节子的任意时间跨度的生物学似是而非的反向传播。arXiv预印本arXiv:2206.01338 (2022)。

77.致密皮质内神经肽网络的单细胞转录组证据。elife 8,e47889 (2019)。

78.平极小值。神经计算9,1–42(1997)。

79.超越准确性:生物似然时间信用分配规则的泛化特性。arXiv预印本arXiv:2206.00823 (2022)。

80.自我参照学习的进化原则,或学习如何学习:元-元-元...钩子。慕尼黑工业大学博士论文(1987年)。

81.Miconi,Stanley,k .和Clune,j.《可微塑性:训练塑性神经网络——用反向传播法工作》。国际机器学习会议,3559–3568(PMLR,2018)。

82.Miconi,t .,Rawal,a .,Clune,J. & Stanley,K. O.《用可微分的神经调节可塑性训练自修正神经网络》。arXiv预印本arXiv:2002.10585 (2020)。

83.段,杨,贾,z,李,q,钟,杨和马,k。arXiv预印本arXiv:2302.03235 (2023)。

84.元学习突触可塑性与连续熟悉性检测的记忆寻址。神经元110,544–557(2022)。

85.短时可塑性神经元学习、学习与遗忘。《机器学习国际会议,18704–18722》(PMLR,2022)。

86.检验hebbian元学习中的基因组瓶颈假说。在NeurIPS 2020机器学习预注册研讨会上,100–110(PMLR,2021)。

87.Gruslys,a .、Munos,r .、Danihelka,I .、Lanctot,m .和Graves,a.《记忆效率反向传播穿越时间》。神经信息处理系统进展29 (2016)。

88.用脉冲神经网络进行一次性学习。BioRxiv

2020–06 (2020).

89.进化神经单元网络可以学习突触学习规则和尖峰动态。自然机器智能2,791–799(2020)。

90.Garg,s .,Tsipras,d .,Liang,P. S. & Valiant,g.《变形金刚能从上下文中学到什么?简单函数类的案例研究。神经信息处理系统进展35,30583–30598(2022)。

91.Kirsch,l .,Harrison,j .,Sohl-Dickstein,j .和Metz,l .,元学习转换器的通用上下文学习。arXiv预印本arXiv:2212.04458 (2022)。

92.学习使用梯度下降来学习。

《人工神经网络——ICANN 2001:国际会议,奥地利维也纳,2001年8月21-25日,会议录11,87-94(Springer,2001)。

93.元学习反向传播及其改进。神经信息处理系统进展34,14122–14134(2021)。

94.线性变压器是秘密的快速加权程序。在机器学习国际会议上,9355–9366(PMLR,2021)。

95.Akyürek,e . Schuurmans,d . Andreas,j . Ma,t .和周,d .什么是情境学习中的学习算法?线性模型研究。arXiv预印本arXiv:2211.15661 (2022)。

96.变形金刚通过梯度下降学习上下文。arXiv预印本arXiv:2212.07677 (2022)。

97.Soltoggio,a .,Stanley,K. O. & Risi,s,《天生学习:进化的塑料人工神经网络的灵感、进展和未来》。神经网络108,48–67(2018)。

98.通过进化自我修改神经网络的适应性强化学习。2020年遗传和进化计算会议论文集,89–90(2020)。

99.随机网络中通过赫布边可塑性的元学习。神经信息处理系统进展33,20719–20731(2020)。

100.Jordan,j .,Schmidt,m .,Senn,W. & Petrovici,M. A.《尖峰网络的演化可解释可塑性》。eLife 10,e66273 (2021)。统一资源定位器https://doi.org/10.7554/eLife.66273。

101.现代神经进化策略对连续控制优化的功效。机器人学和人工智能前沿7,98 (2020)。

102.“自我参照”权重矩阵。ICANN'93:人工神经网络国际会议论文集,荷兰阿姆斯特丹,1993年9月13-16日3,446-450(Springer,1993)。

103.通过自我参照元学习消除元优化。arXiv预印本arXiv:2212.14392 (2022)。

104.Irie,k .,Schlag,I .,cordás,R. & Schmidhuber,j .一种学习修改自身的现代自参照权重矩阵。国际机器学习会议,9660–9677(PMLR,2022)。

105.自我参照元学习。在第一届自动机器学习会议上(最新研讨会)(2022)。

106.用随机初始化的学习优化器训练学习优化器。arXiv预印本arXiv:2101.07367 (2021)。

107.通过元黑盒优化发现进化策略。arXiv预印本arXiv:2211.11260 (2022)。

108.学习强化学习。arXiv预印本arXiv:1611.05763 (2016)。

109.从慢速强化学习到快速强化学习。arXiv预印本arXiv:1611.02779 (2016)。

110.黑盒元强化学习引入对称性。在…里

AAAI人工智能会议论文集,第36卷,7202–7210(2022)。

111.硬件中的神经形态计算和神经网络综述。arXiv预印本arXiv:1705.06963 (2017)。

112.神经形态工程:从生物到基于锋电位的硬件神经系统。先进材料32,2003610 (2020)。

113.基于锋电位的局部突触可塑性:计算模型和神经形态回路综述。arXiv预印本arXiv:2209.15536 (2022)。

114.具有片上学习的神经形态多核处理器。Ieee微38,82–99(2018)。

115.一个65 mw一百万神经元可编程神经突触芯片的设计和工具流程。IEEE集成电路和系统计算机辅助设计汇刊34,1537–1557(2015)。

116.Spinnaker:用于大规模并行神经网络模拟的1 w 18核片上系统。IEEE固态电路杂志第48期,1943–1953(2013)。

117.机器人和神经科学。当代生物学24,R910–R920(2014)。

118.基于学习激励脉冲神经网络的机器人控制综述。神经机器人前沿12,35 (2018)。

119.Grinke,e .,Tetzlaff,c .,rgö tter,F. & Manoonpong,p.《步行机器人多功能和适应性行为的递归神经网络中的突触可塑性》.神经机器人前沿9,11 (2015)。

120.Kaiser,j .等人通过在线强化学习体现了突触可塑性。神经机器人前沿13,81 (2019)。

121.突触运动适应:脉冲神经网络中自适应机器人控制的三因素学习规则。arXiv预印本(2023)。

122.Arena,p .,De Fiore,s .,Patané,l .,Pollino,M. & Ventura,c.《混合机器人战术和恐惧行为增强的昆虫启发的无监督学习》。在2010年国际神经网络联合会议(IJCNN),1–8(IEEE,2010)。

123.胡,d,张,x,徐,z,Ferrari,s .和Mazumder,p .能够进行脉冲时间相关可塑性(stdp)学习的脉冲神经网络(snn)的数字实现第14届IEEE纳米技术国际会议,873–876(IEEE,2014)。

124.王晓玲,侯振国,吕福芳,谭,王明英。基于脉冲神经网络的移动机器人模块化导航控制器。神经计算134,230–238(2014)。

125.Neymotin,S. A .,Chadderdon,G. L .,Kerr,C. C .,Francis,J. T. & Lytton,W. W .在感觉运动皮层的计算机模型中对双关节虚拟手臂伸展的强化学习。神经计算25,3263–3293(2013)。

126.与虚拟肌肉骨骼手臂和机器人手臂接口的皮层尖峰网络。神经机器人前沿9,13 (2015)。

127.Ilg,w .和Berns,k .基于强化学习的学习架构,用于步行机器lauron的自适应控制。机器人与自主系统15,321–334(1995)。

128.生物机器人学:使用机器人来模拟和研究敏捷运动。科学346,196–203(2014年)。

129.Faghihi,f .,Moustafa,A. A .,Heinrich,r .和wr gtter,f .一个受果蝇嗅觉系统启发的调节计算模型。神经网络87,96–108(2017)。

130.Szczecinski,N. S ,,戈德史密斯,c ,, Nourse,w &, Quinn,R. D,《过去、现在和未来仿昆虫机器人腿式运动的神经形态控制展望》。新物理计算与工程(2023)。

131.深度强化学习及其神经科学含义。神经元107,603–616(2020)。

132.Arulkumaran,k .,Deisenroth,M. P .,Brundage,m .和Bharath,A. A.《深度强化学习的简要调查》。arXiv预印本arXiv:1708.05866 (2017)。

133.通过深度强化学习进行人类水平的控制。《自然》518,529–533(2015)。

134.奖励预测误差的神经回路。

神经科学年度综述40,373–394(2017)。

135.强化学习:一项调查。人工智能研究杂志4,237–285(1996)。

136.萨顿和巴尔托,《强化学习:导论》(麻省理工学院出版社,2018年)。

137.彭,X. B .,Abbeel,p .,Levine,S. & Van de Panne,M. Deepmimic:基于物理的角色技能的示例引导的深度强化学习。美国计算机学会图形汇刊(TOG) 37,1–14(2018)。

138.混合合作-竞争环境下的多主体行动者-批评家。

神经信息处理系统进展30 (2017)。

139.脑结构可塑性:从成人神经发生到未成熟神经元。神经科学前沿14,75 (2020)。

140.机器人的持续学习:定义、架构、学习策略、机会与挑战。信息融合58,52–68(2020)。

141.现实世界自治系统的持续学习:算法、挑战和框架。智能与机器人系统杂志105,9 (2022)。

142.在人工智能体中使用网格状表示的矢量导航。

自然557,429–433(2018)。

143.通过训练递归神经网络进行空间定位,出现网格状表示。arXiv预印本arXiv:1803.07770 (2018)。

144.高,y。在迷宫中通过符合布局的位置细胞重放学习灵活导航的计算模型。bior XIV 2022–09(2022)。

145.哪种用于物体识别的人工神经网络最像大脑?BioRxiv 407007 (2018)。

146.浅的无监督模型最好地预测了小鼠视觉皮层的神经反应。bior XIV 2021–06(2021)。

147.大脑和深层网络之间视觉对象表征的定性相似性和差异性。自然通讯12,1872 (2021)。

148.神经连接主义者研究计划。arXiv预印本arXiv:2209.03718 (2022)。

149.《神经科学启发的人工智能》。神经元95,245–258(2017)。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2023-06-03,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录