SIGGRAPH 2023 | 合成人物-场景的物理交互

来源:SIGGRAPH 2023 论文题目:Synthesizing Physical Character-Scene Interactions 论文作者:Mohamed Hassan 等人 内容整理: 林宗灏 本文介绍了人物-场景交互合成问题。现有方法主要集中于控制人物在简单环境中的运动,并需要手动注释训练数据。作者提出了一种系统,使用对抗模仿学习和强化学习来训练人物执行场景交互任务。该系统从非结构化的运动数据集中学习场景交互行为,无需手动注释,并将鉴别器和策略网络都与场景背景相关联。实验通过三个具有挑战性的场景交互任务(搬运、坐下和躺下)展示了该方法的有效性。

引言

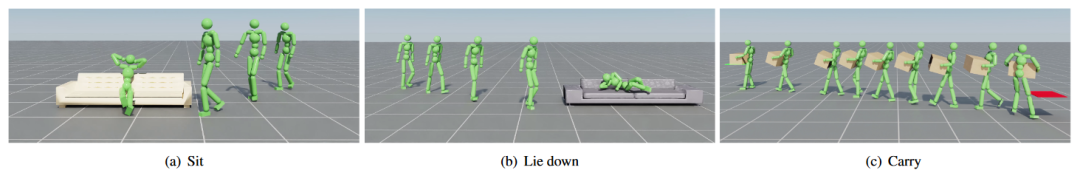

图1 我们的框架能够模拟人物以自然逼真的方式进行与场景的物理交互。我们通过三个具有挑战性的场景交互任务证实了方法的有效性:搬运、坐下和躺下。这些任务需要对人物的动作与环境中的物体进行协调。

运动是人与环境交互和影响的方式。为了制作逼真的人物动画,就有必要合成虚拟人物与其周围环境之间的交互。尽管最近机器学习方法在人物动画方面取得了一些进展,但大多数系统侧重于在相对简单和单一的环境中控制人物的运动,且与其他物体的交互相当有限。此外,以往许多合成人物-场景交互的方法需要对训练数据进行大量的人工标注。相比之下,我们提出了一个系统,它使用对抗模仿学习和强化学习来训练人物以自然逼真的方式进行场景交互任务。我们的方法从大型非结构化运动数据集中学习场景交互行为,而无需对运动数据进行人工标注。这些场景交互行为使用对抗鉴别器学习,该鉴别器可在场景背景中评估动作的逼真程度。关键的创新在于鉴别器和策略网络都约束于场景条件。我们通过三个具有挑战性的场景交互任务证实了方法的有效性:搬运、坐下和躺下。这些任务需要对人物的动作与环境中的物体进行协调。我们的策略学习了在诸如待机、行走和坐下等不同行为之间的无缝切换。通过在训练过程中随机调整物体的属性及其位置,我们的方法能够泛化至训练数据集之外的物体和场景,为各种物体形状和位置生成自然的人物-场景交互。本文的贡献总结如下:

- 一个无需人工标注即可训练人物-场景交互任务的框架;

- 利用基于场景条件的鉴别器,依据环境中的物体对人物的动作进行考量;

- 为场景中的物体属性引入了一种随机化方法,从而泛化至训练数据集之外的物体和场景。

方法

框架

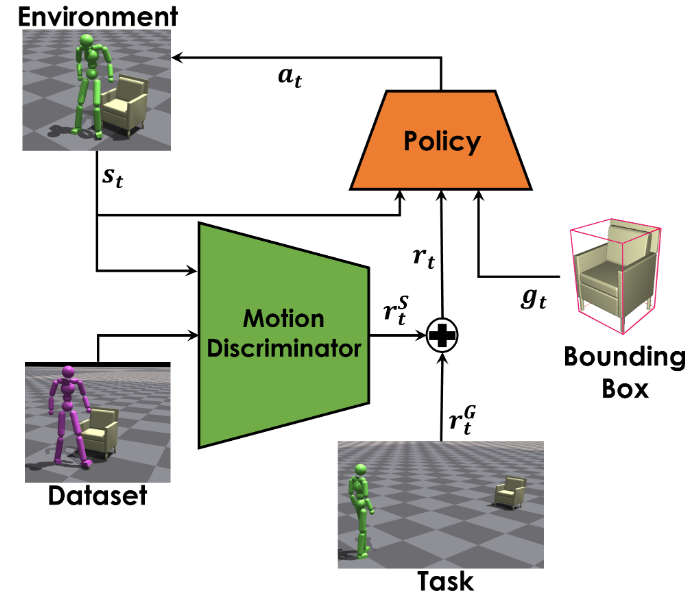

图2 我们的框架有两个主要组成部分:策略和鉴别器。鉴别器对策略生成的行为和动作数据集中的行为进行区分。与之前的工作相比,我们的鉴别器接收人物和环境的相关信息。具体而言,策略的训练目标是控制人物动作以达到任务奖励

的同时,在给定场景背景下生成逼真的人类行为动作。

为了训练能使虚拟人物以自然逼真的方式与物体进行交互的策略,我们在对抗动作先验(AMP)框架的基础上进行了改进。我们的方法包括两个主要部件:策略和鉴别器(如图 2 所示)。鉴别器的作用是区分生成的虚拟人物行为和运动数据集中的行为。策略

的作用是控制人物的运动,以最大化预期累计奖励

。每个时间步

的奖励

根据以下公式确定:

任务奖励

鼓励人物实现高级目标,如坐在椅子上或将物体移动到期望的位置。风格奖励

鼓励人物在执行期望任务时模仿运动数据集的行为。

是时间步

的状态,

是在时间步

从策略

中采样的动作,

表示时间步

下特定任务的目标特征,

和

是权重。策略的训练目标是最大化期望折扣回报

:

其中,

表示在策略

下轨迹

的可能性,

是时间范围,

是折扣因子。

风格奖励

使用对抗鉴别器建模,该鉴别器评估虚拟人物动作与数据集中的动作之间的相似度。鉴别器根据 Peng 等人提出的目标进行训练:

其中,

和

分别表示在数据集分布

和策略

下从状态

转移至

的可能性。

是人为指定的梯度惩罚正则化系数。策略的风格奖励

根据以下公式确定:

实现细节

在每一轮的起始阶段,人物和物体的状态会从数据集中随机抽样初始化。由于参考动作只描述了有限的场景,仅从此进行初始化不足以涵盖场景中所有可能的配置。为了训练能够在多种初始配置下执行期望任务的通用策略,我们在每一轮开始时都会随机调整物体相对于人物的位置。物体在水平面上被放置于距离人物 1~10 米的位置,方向在

之间均匀采样。坐下和躺下任务的时间长度设定为 10s,搬运任务的时间长度设定为 15s。此外,如果除手脚之外的任何关节距离地面小于 20cm,或者箱子距离地面小于 30cm,策略将提前终止。

策略

由神经网络建模,该网络以当前状态

和 目标

为输入,预测高斯动作分布

的均值

。协方差矩阵

由人为指定并在训练过程中保持不变。策略、值函数和鉴别器分别由独立的全连接网络建模,维数分别为{1024, 512, 28}、{1024, 512, 1}和{1024, 512, 1}。所有隐单元采用 ReLU 激活。策略与鉴别器联合训练。

实验

数据集

为了训练人物以自然逼真的方式与物体进行交互,我们使用人物-场景交互动作数据集来训练我们的方法。对于坐下和躺下的任务,我们使用 SAMP 数据集,其中包含 100 分钟的坐下和躺下行为的动作捕捉片段。此外,该数据集还记录了场景中物体的位置和方向,以及七个不同物体的 CAD 模型。对于搬运任务,我们捕捉了一个主体搬运单个箱子的 15 个动作捕捉片段。在每个片段中,主体走向箱子,将其拿起并搬运至指定位置。各片段箱子的初始位置和目标位置不同。除了全身动作捕捉之外,箱子的运动还使用了光学标记追踪。

定量结果

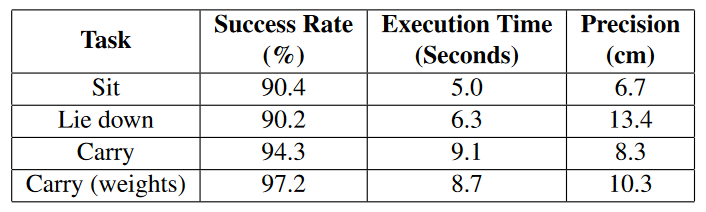

表1 所有任务的成功率、平均执行时间和平均精度。所有指标均为每个任务在 4096 次试验中的平均值

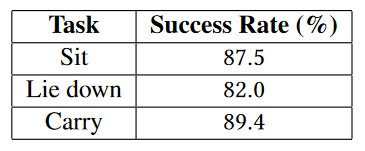

表2 物理扰动下的成功率

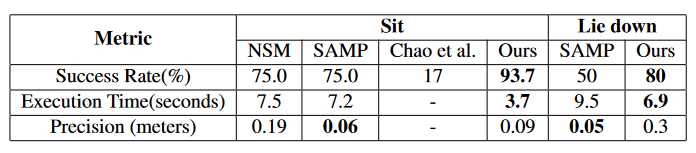

表3 与 NSM、SAMP、Chao et al. 的性能比较

定性结果

图3 我们的方法成功地以逼真的方式执行了三个具有挑战性的场景交互任务

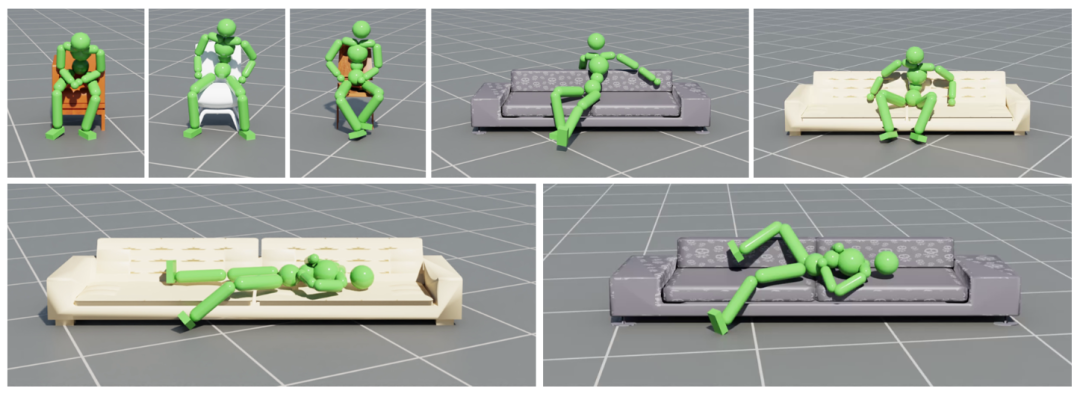

图4 我们的方法成功地在各种物体上坐下与躺下,并且可以使人物的动作适应于新的物体

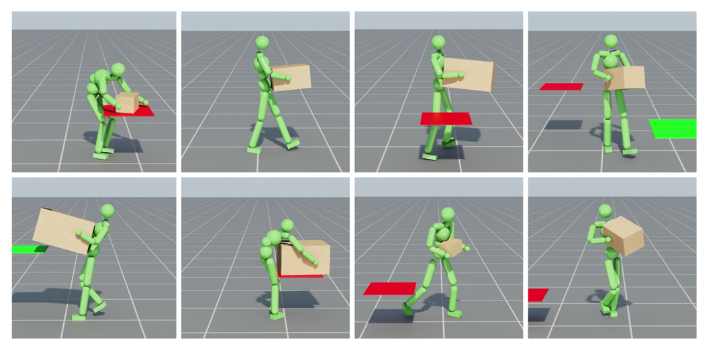

图5 从人类搬运单个箱子的演示中,我们的方法推广到了搬运不同尺寸的箱子

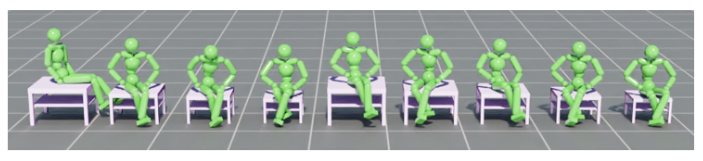

图6 我们的策略能够适应不同大小的物体

图7 同一物体对象上的不同坐姿