突破性进展!Med-Former:全新的Transformer医学图像分类架构

突破性进展!Med-Former:全新的Transformer医学图像分类架构

小白学视觉

发布于 2024-12-05 16:29:28

发布于 2024-12-05 16:29:28

重磅干货,第一时间送达

写在前面&笔者的个人理解

近年来,随着深度学习技术的飞速发展,医学图像分类领域迎来了革命性的进步。然而,现有的基于Transformer的图像分类方法在应用于医学图像时面临诸多挑战,尤其是在特征提取能力和关键信息传递效率方面。为了解决这些问题,Stony Brook University的研究团队提出了一种创新的框架——Med-Former,它包含Local-Global Transformer模块和Spatial Attention Fusion模块,显著提升了医学图像分类的性能。

论文链接:https://papers.miccai.org/miccai-2024/500-Paper0867.html

算法网络结构&技术细节梳理

研究背景

医学图像分类在计算机辅助诊断(CAD)系统的发展中扮演着关键角色,但同时也面临着疾病复杂性带来的挑战。传统的卷积神经网络(CNN)在全局上下文信息提取方面存在局限。为了克服这些限制,研究者们引入了Inception网络、Residual网络和DenseNets等,但这些网络仍然无法有效聚焦于医学图像分类中的关键区域。

算法

概述

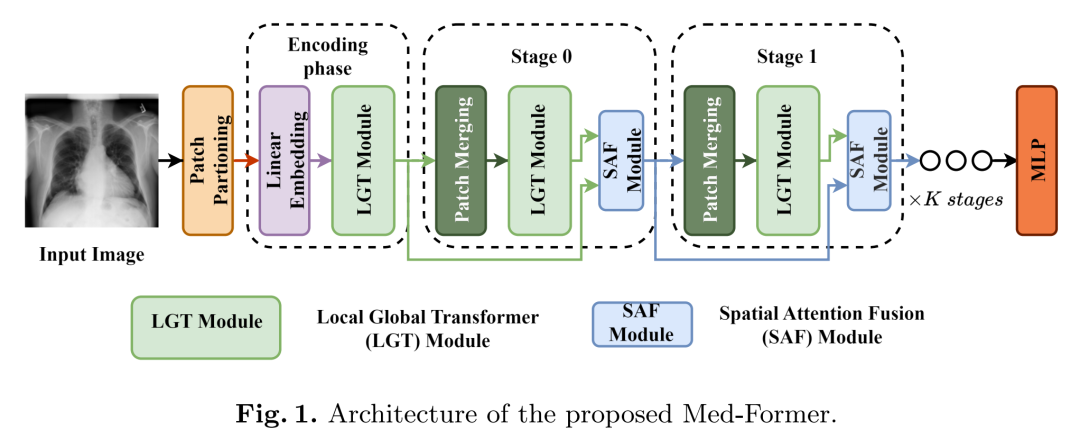

图1展示了Med-Former架构,包括一个块划分层、一个线性嵌入层、LGT模块、块合并层、SAF模块和一个用于分类的MLP。块划分层将输入图像划分为大小为的块,其中表示块的宽度或高度。这些块通过嵌入阶段的线性嵌入层处理,然后由LGT模块处理并传递到后续阶段。后续阶段包括块合并层、LGT模块和SAF模块。每个阶段使用块合并层对输入特征图进行下采样。SAF模块用于融合前一阶段的SAF模块和当前阶段的LGT模块的输出,改善关键特征传播的连续性并减少信息丢失。第0阶段与K个连续阶段略有不同,它融合了来自嵌入阶段的LGT模块和当前阶段的LGT模块的输出,从而增强了对输入图像的上下文理解。

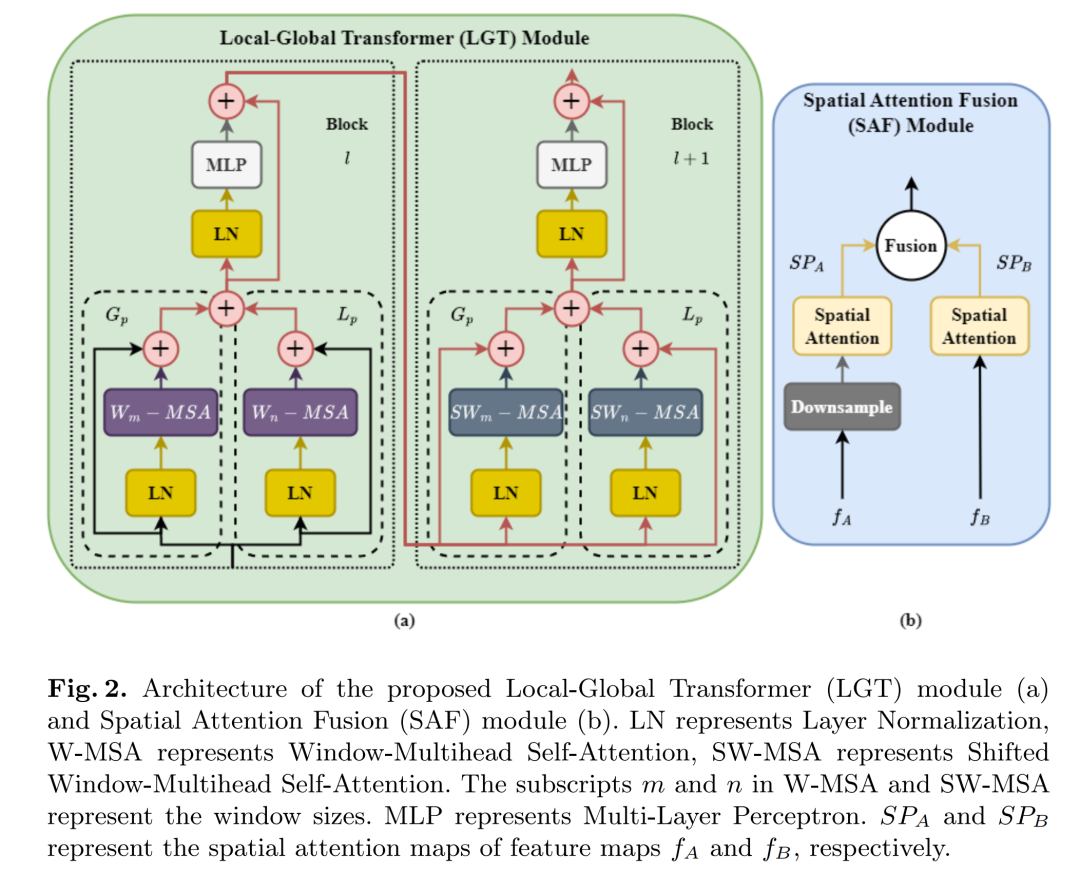

局部-全局Transformer(LGT)模块

提出的LGT模块与常规Swin-Transformer架构不同,它集成了两个并行路径(图2(a)):全局路径Gp和局部路径Lp,用于在两个变换器块(即块l和l+1)中计算多头自注意力(MSA),这两个块中的窗口大小不同。Gp使用大小为的全局窗口,Lp使用大小为的局部窗口,其中。这种配置有助于在窗口级别提取全局和局部信息,从而增强特征表示学习和分类性能。Gp和Lp在块l上的MSA的不同窗口的输出,表示为和,后来合并并传递到下一个块l+1上的MSA移位窗口,分别表示为和。

空间注意力融合(SAF)模块

提出的SAF模块(图2(b))用于融合前一层和阶段的特征图,促进网络内关键信息的传递,减少信息丢失。该模块接受两个特征图,fA和fB,其中fA是前一阶段的特征图,fB是前一层的特征图。最初,它对特征图fA进行下采样以匹配特征图fB的尺寸。随后,分别为特征图fA和fB计算空间注意力图SPA和SPB。最后,SPA和SPB的融合输出被传递到后续阶段。

实验结果&评价指标

数据集和性能指标

为了评估所提出的Med-Former的泛化能力,它在三个不同的医学图像分类任务上进行了测试,每个任务代表不同的成像方式和疾病类型:胸部X光片中的胸部疾病分类(NIH Chest X-ray14,表示为ChestX);皮肤镜图像中的皮肤病变分类(DermaMNIST,表示为DM);和显微镜图像中的血细胞分类(BloodMNIST,表示为BM)。研究使用官方数据集拆分来训练和评估MedFormer。对于ChestX,训练/验证集包括86,524张图像,而测试集包括25,596张图像。对于DM,训练/验证集包括8,010张图像,测试集包含2,005张图像。对于BM,训练/验证集包括13,671张图像,测试集包括3,421张图像。与其他最新技术(SOTA)方法

一样,作者在DM和BM数据集上使用分类准确率(ACC)和曲线下面积(AUC)进行评估,而ChestX数据集使用AUC进行评估。

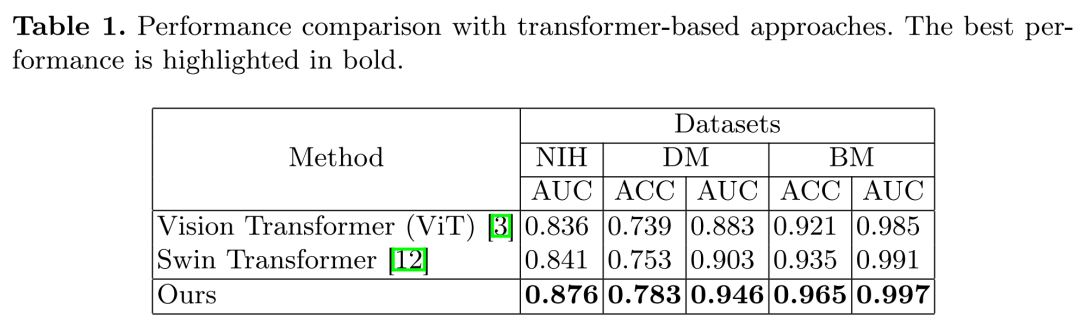

性能比较

首先,作者评估所提出的Med-Former与现有的基于Transformer的方法的性能,即Vision Transformer(ViT)和Swin Transformer。为确保公平比较,ViT和Swin Transformer在ChestX、DM和BM数据集上使用相同的评估协议进行训练和评估。这次比较的结果总结在表1中。

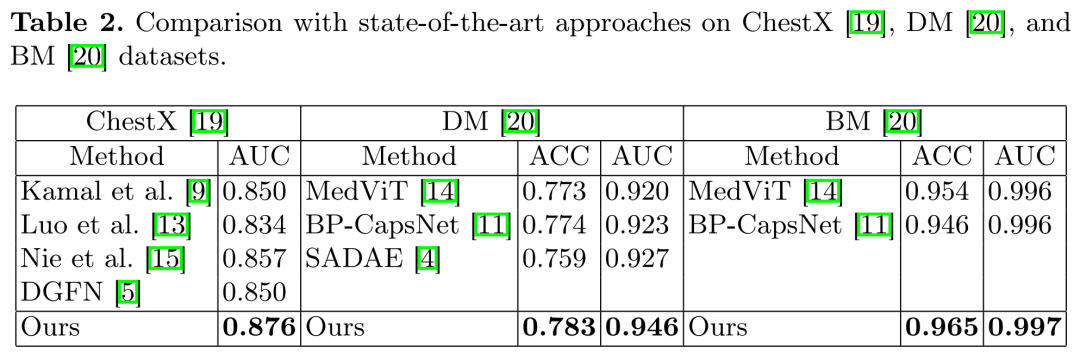

其次,作者在表2中将Med-Former与最新技术方法进行比较。所有这些方法都使用与作者工作相同的评估协议报告了他们的结果,使作者能够进行公平比较。

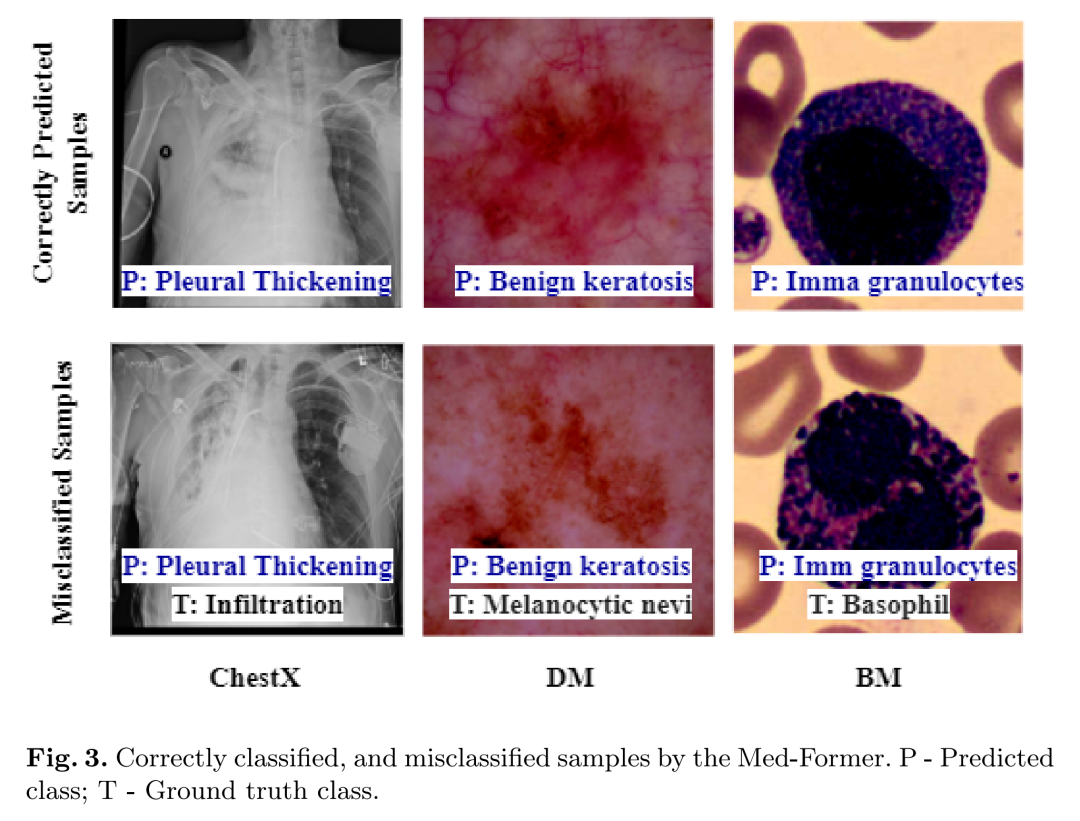

最后,作者通过一些正确分类和错误分类的样本在图3中展示了Med-Former的性能。错误分类源于具有相似特征的疾病,例如胸部X光片中的白色肺野、皮肤镜图像中的广泛感染(不作为簇)以及显微镜图像中相似的细胞外和细胞内结构。在未来,为了克服这些局限性,作者计划通过添加额外的信息,例如患者症状,来丰富作者的模型以协助诊断。

消融结果

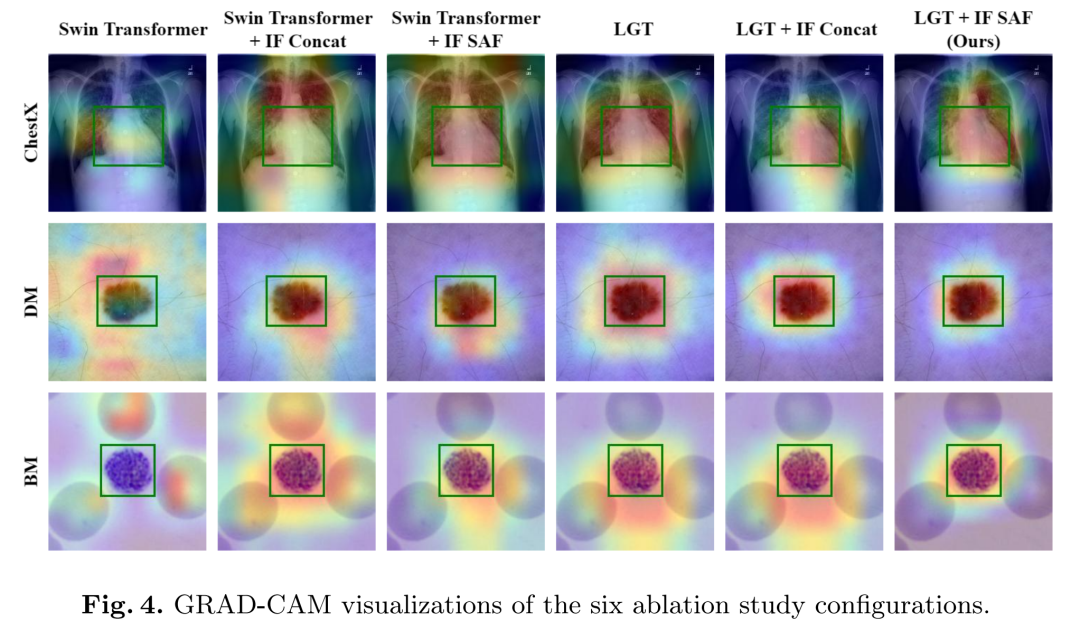

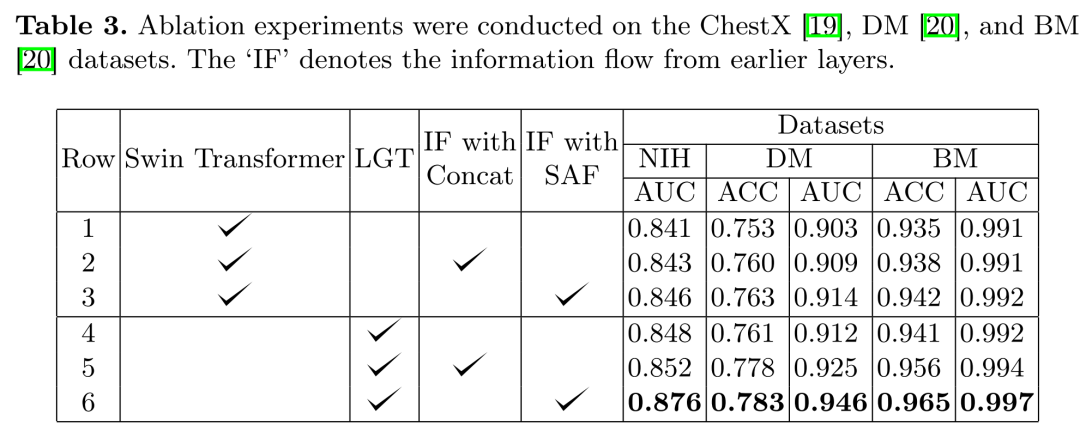

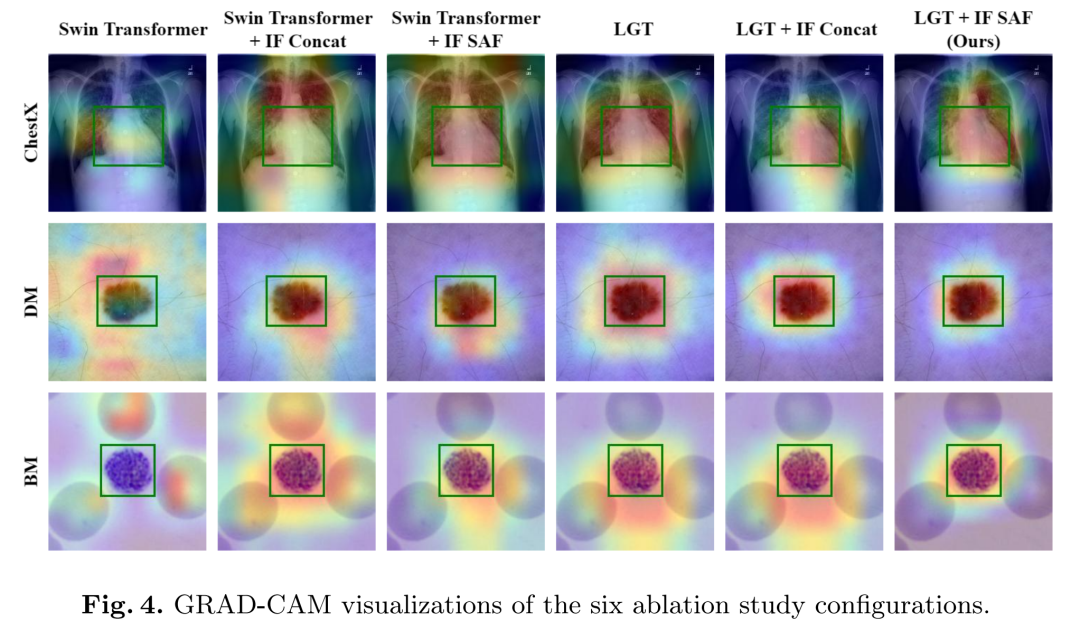

作者进行了一系列消融实验,以评估Med-Former中各个模块的有效性。这些实验的定量结果总结在表3中,定性比较在图4中呈现。

图4展示了对应于表3中六行的定性示例。增加跨层信息增强了Swin Transformer理解上下文信息的能力(Swin Transformer + IF Concat),使模型能够关注感兴趣区域(ROI)。此外,将SAF模块作为插件集成有效地传播了关键信息(Swin Transformer + IF SAF),进一步细化了模型的焦点。LGT模块通过关注ROI提取关键上下文信息,尽管它略为超出,这由SAF模块解决(LGT + IF SAF)。这些发现表明Med-Former(LGT + IF SAF)有效地捕获了诊断所需的关键信息。

结论

作者介绍了Med-Former,这是一个为医学图像分类量身定制的基于Transformer的架构。针对现有模型在从早期层传播关键信息以及在局部和全局层面增强特征提取能力方面的限制,作者设计了局部-全局Transformer(LGT)和空间注意力融合(SAF)模块。这些模块使得Med-Former能够有效地学习局部和全局信息,促进了关键信息通过网络的传播。作者在三个不同的医学图像分类任务上评估了作者的方法:胸部X光片中的胸部疾病分类、皮肤镜图像中的皮肤病变分类和显微镜图像中的血细胞分类。在这些任务中,作者的方法一致性地超越了其他基于Transformer的架构和最新技术方法。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2024-12-04,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录