MapFusion:一种新的多模态BEV特征融合方法

MapFusion:一种新的多模态BEV特征融合方法

论文地址:https://arxiv.org/abs/2502.04377

本文介绍了一种名为MapFusion的新方法,用于多模态地图构建任务中的特征融合。该方法采用鸟瞰视角(Bird's-Eye View,BEV)特征作为输入,并通过引入交叉模态交互和双动态融合模块来解决不同传感器之间的语义不匹配问题。实验结果表明,与现有方法相比,MapFusion在高清地图建设和BEV地图分割任务中分别取得了3.6%和6.2%的绝对提升,证明了其优越性。

论文方法

1.1 方法描述

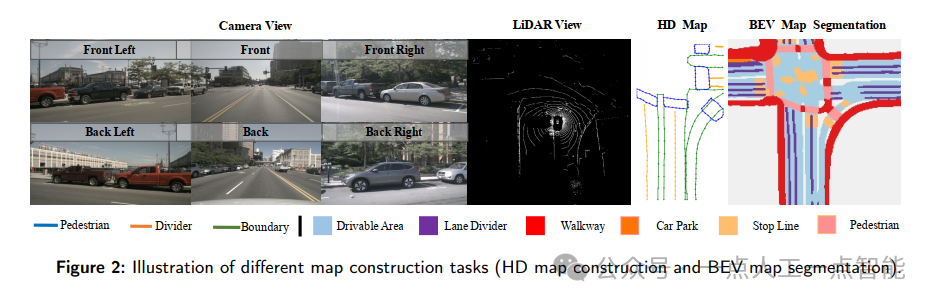

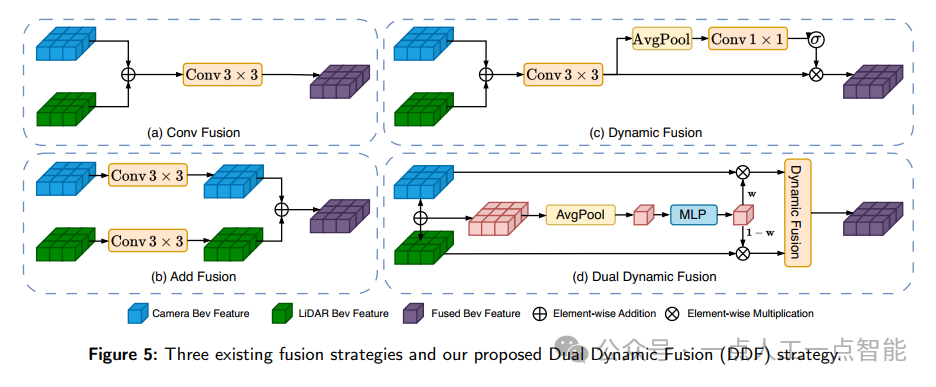

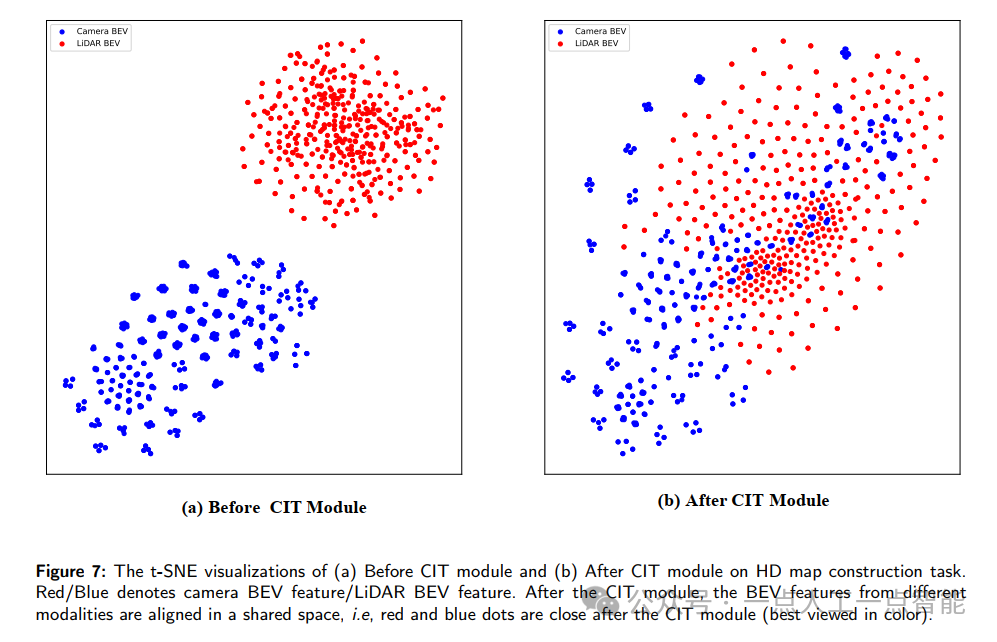

该论文提出了一种名为MapFusion的多模态BEV地图构建方法,它是一种简单而有效的方法,可以与现有的地图构建任务兼容。该方法首先应用特定的编码器来提取不同传感器输入(如相机和激光雷达)的特征,并将它们转换为统一的BEV表示形式,以保留几何和语义信息。然后,通过自注意力机制实现跨模态交互变换(Cross-modal Interaction Transform,CIT),增强一个模态的特征来自另一个模态。最后,使用双动态融合(Dual Dynamic Fusion,DDF)模块自动选择有价值的信息,从而更好地融合不同模态的特征。最终,将融合后的多模态BEV特征输入到解码器和预测头中,用于地图构建任务。

1.2 方法改进

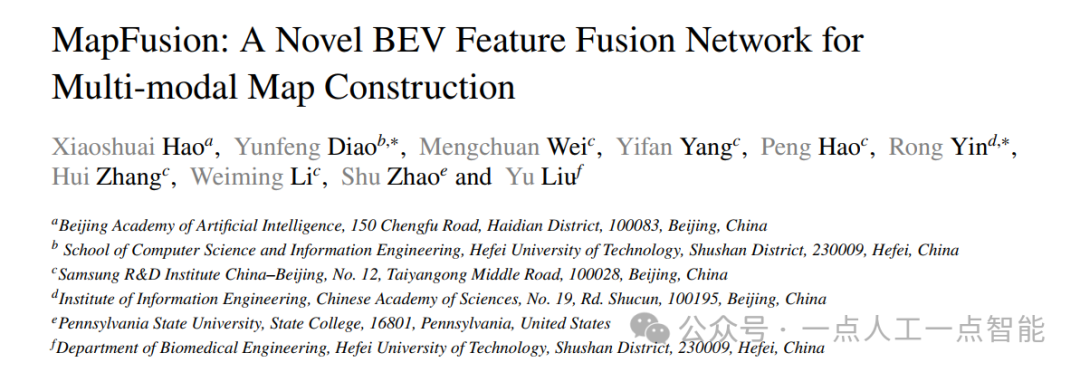

相比于传统的直接将所有感官特征转换为共享的BEV表示并将其融合的方法,该方法引入了CIT模块,通过自注意力机制实现了跨模态交互变换,解决了由于两个传感器之间的显著差异而导致的语义不匹配问题。此外,该方法还采用了DDF模块,通过适应性地选择有价值的信息,进一步提高了特征融合的效果。

1.3 解决的问题

该方法主要解决了在多模态地图构建任务中如何有效地融合不同传感器输入的问题。具体来说,该方法通过CIT模块实现了跨模态交互变换,增强了不同传感器输入之间的相互作用;同时,通过DDF模块,该方法能够适应性地选择有价值的信息,进一步提高了特征融合的效果。因此,该方法可以提高地图构建任务的准确性和鲁棒性。

论文实验

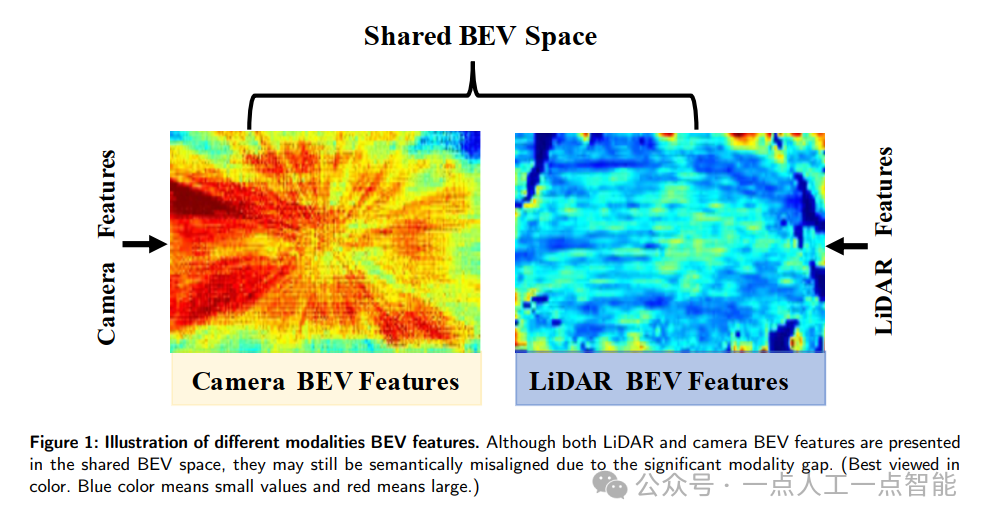

本文主要介绍了MapFusion方法在高清地图建设和BEV地图分割任务中的表现,并与其他现有方法进行了比较。

具体来说,该方法在以下方面进行了对比实验:

· HD地图建设任务中,将MapFusion与HDMapNet、VectorMapNet和MapTR等方法进行了比较。实验结果表明,MapFusion在单模态和多模态情况下均优于其他方法,取得了显著的性能提升。

· BEV地图分割任务中,将MapFusion与PointPainting、MVP和BEVFusion等方法进行了比较。实验结果表明,MapFusion在单模态和多模态情况下均优于其他方法,取得了显著的性能提升。

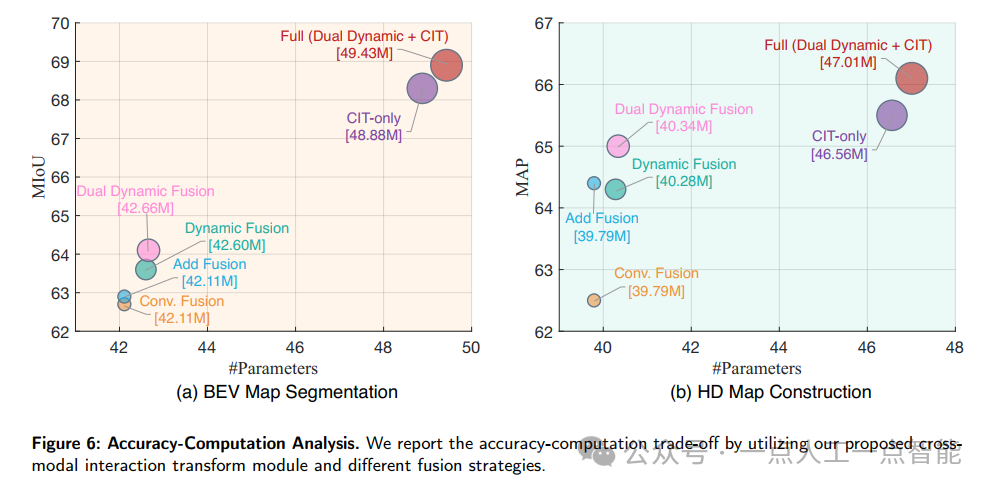

· Ablation studies中,对MapFusion的不同组件进行了评估,包括使用不同的融合方法和仅使用部分组件的情况。实验结果表明,Cross-modal interaction transform (CIT) 和 Dual dynamic fusion (DDF) 都是有效的组件,可以提高模型的性能。

· Accuracy-computation analysis中,通过对不同融合策略的实验,证明了CIT模块能够提供更好的准确性和计算效率之间的平衡。

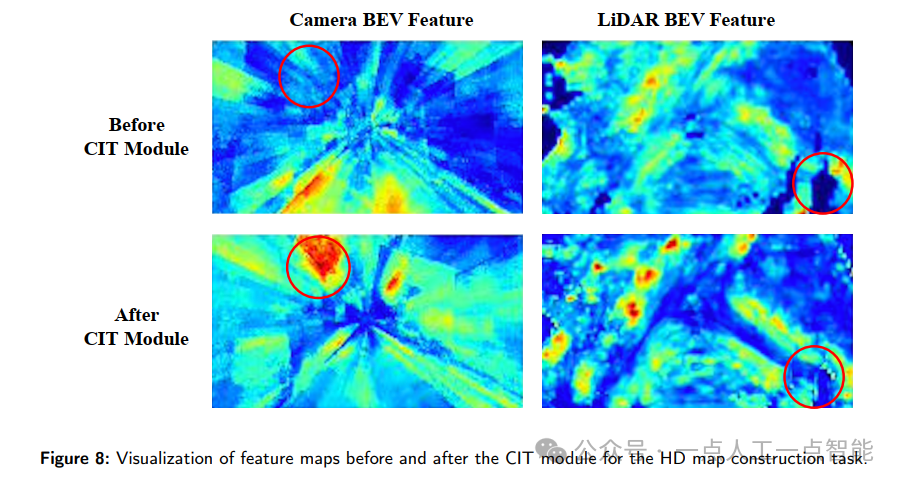

· Visualization中,通过可视化BEV特征图和高清地图预测结果,展示了MapFusion方法的有效性。

总的来说,MapFusion方法在多个任务上都取得了优异的表现,证明了其在多模态高清地图建设和BEV地图分割任务中的有效性。

方法创新点

该论文的主要贡献在于提出了一个新的多模态BEV特征融合方法MapFusion,该方法通过引入CIT和DDF两个核心模块来实现跨模态交互和模态集成。

具体来说,CIT模块使用自注意力机制来学习相机和激光雷达之间二元关系的权重矩阵,从而实现跨模态信息融合;而DDF模块则通过选择有价值的信息来进一步优化特征融合效果。

此外,该方法还采用了多种操作,如全局信息交换、有效局部信息聚合以及空间和通道域加权等,以达到高质量的特征融合效果。

未来展望

随着自动驾驶技术的发展,多模态感知将成为不可或缺的一部分。因此,未来的研究方向可以考虑将MapFusion方法扩展到其他多模态感知任务中,例如目标检测和跟踪等。同时,也可以探索如何更好地结合不同的传感器信息,以获得更准确的环境感知结果。