中山大学林浩添/陈文贲团队验证大语言模型可有效帮助医生开展医学人工智能研究 | Cell Press对话科学家

中山大学林浩添/陈文贲团队验证大语言模型可有效帮助医生开展医学人工智能研究 | Cell Press对话科学家

DrugOne

发布于 2025-12-17 16:59:02

发布于 2025-12-17 16:59:02

医学

Medicine

2025年11月26日,中山大学中山眼科中心林浩添教授团队在Cell Press细胞出版社期刊Cell Reports Medicine发表了一篇论文,题为“The effectiveness of large language models in medical AI research for physicians: A randomized controlled trial”。该研究通过严谨的随机对照试验证实,大语言模型可以有效帮助医生完成医学人工智能研究项目,克服知识与技术障碍,同时也可能带来依赖风险等问题。

▲长按图片识别二维码阅读原文

一直以来,多学科的融合与应用在推动学科发展和创新中发挥着关键作用,是推动科学前沿突破的重要驱动力。医学人工智能(AI)作为多学科融合的典范,在提升诊疗水平与医疗效率方面展现出巨大潜力。临床医生宝贵的一线临床经验和深厚的专业洞察力对于医学人工智能的发展不可或缺,然而,技术门槛却构成了他们深入参与的重大障碍。这一矛盾在资源有限的年轻医生或基层医疗机构中尤为突出。尽管此前已有一些旨在降低编程门槛的工具,但要独立完成一个完整的、从设计到执行的医学AI研究项目,对非工程背景的临床医生而言依然充满挑战。目前,尚缺乏一种能够灵活应用于整个医学AI研究流程、有效降低综合技术难度的策略与方法。

近年来,大语言模型的出现,为破解这一困境带来了新的希望。其强大的通用知识问答与代码生成能力,是否真能成为临床医生开展AI研究的“助手”?其效果究竟如何?又会带来哪些潜在风险?这些问题亟需严谨的科学证据予以回答。

近日,中山大学中山眼科中心林浩添教授团队开展了一项优效性、开放标签的随机对照试验,评估LLMs能否作为一种有效工具协助医生开展医学AI研究。研究入组了64例无AI研究和编程经验的参与者,随机分为使用LLMs的干预组(n=32)与使用传统搜索工具的对照组(n=32),参与者被要求在两周内完成一项医学AI研究项目。结果显示,干预组的项目总完成率高达87.5%,远超对照组的25.0%(差值62.5%,p=9.42e-7)。更值得注意的是,干预组在无需专家小组任何协助的情况下独立完成项目的比例达到68.7%,而对照组仅为3.1%(差值65.6%,p=5.70e-8)。此外,干预组在项目方案质量与项目完成速度方面均表现更优(p<0.01)。

更重要的是,在为期两周的“洗脱期”后停止使用大语言模型,仍有41.2%原干预组的成功参与者能够独立完成一个新的研究项目,这表明他们不仅仅是机械复制LLMs的答案,而是在LLMs帮助下掌握了医学AI研究的基本原理和开展流程,并能够将习得的知识和技能应用于新的AI研究项目。然而,仍有超40%的成功参与者在撤除LLMs后未能完成新项目,表明参与者对LLMs可能有依赖倾向。进一步问卷调查显示,42.6% 的参与者担心使用LLMs可能导致“只是机械复制而缺乏理解”,40.4%的参与者忧虑其可能“助长惰性思维”,提示对LLMs依赖的潜在风险。该研究证实了大语言模型在赋能临床医生进行医学AI研究方面的巨大潜力,同时也提示其长期风险需进一步评估。

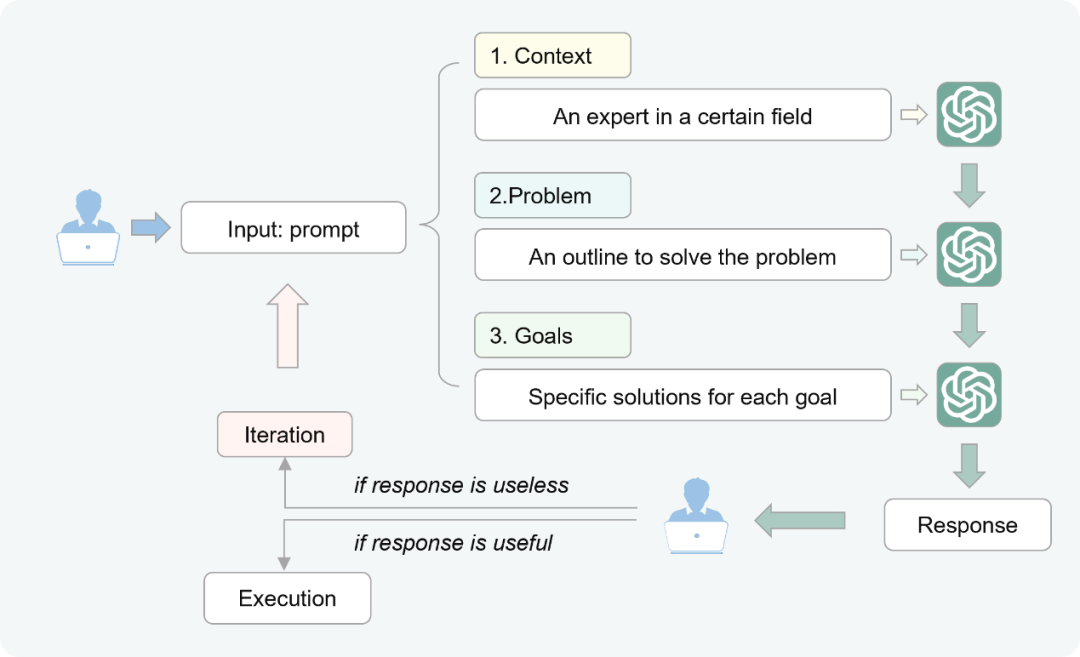

此外,研究人员进一步分析指出,未能完成项目的参与者与LLMs的对话记录中出现了“AI幻觉”及使用“无效提示词”的问题,因此研究人员采用类德尔菲法总结出一套“CPGI”提示词指南帮助医生使用LLMs开展医学AI研究时能够制定有效的提示词。

作者专访

Cell Press细胞出版社特别邀请论文作者团队进行了专访,为大家进一步详细解读。

CellPress:

目前临床医生参与医学人工智能研究面临哪些主要挑战?

林浩添教授:

医学AI研究的最终目标是解决临床问题,临床医生的深度参与至关重要。然而,现实是许多医生,特别是青年医生和基层医院的团队,面临着显著的“技术鸿沟”。他们通常拥有宝贵的临床数据和洞见,但缺乏将想法转化为AI模型所需的技术支持、跨学科合作机会和研究资源。传统的解决方案,比如一些“无代码”建模平台,在一定程度上降低了建模的门槛,但一个完整的医学AI研究远不止是训练一个模型。它涵盖了从问题定义、研究设计、数据预处理、算法选择、代码实现到结果分析和报告撰写的全流程。这个综合性的技术壁垒,使得许多临床团队无法独立、深入地开展真正以临床问题为导向的AI研究,限制了医学AI创新的源头活水。

CellPress:

本项研究对促进临床医生开展医学AI研究有哪些具体意义?

陈文贲副研究员:

在“AI for Science”范式加速发展的背景下,我们的研究提供了高等级证据,表明LLMs能够有效协助临床医生应对医学AI研究中复杂的跨学科知识挑战与技术壁垒,有望促使更多医生将宝贵的临床见解与经验转化为技术实现。它不仅仅是提供一个代码片段,而是能够协助临床医生进行项目规划、技术路径选择、解决具体实现难题,甚至帮助进行结果解读。这意味着,LLMs能够极大地降低了综合性技术门槛,赋能广大一线医生,让即使没有强大工程团队支持的一线医生,也能基于自己的临床发现开展AI研究,而这将催生大量小规模、针对特定临床场景和患者群体的、高价值的AI应用,与传统上由大型团队主导开发需广泛验证的标准化模型形成了有益互补。

CellPress:

本项研究还有哪些亮点?

林浩添教授:

除了证实大语言模型的有效性,我们更希望传递一个理念:AI既可能成为让人产生依赖的“拐杖”,也可以成为助力医生成长的“教练”,关键在于我们如何使用它。本研究有几个支撑这一观点的发现:首先,我们观察到了积极的“技能迁移”效应。在撤除大语言模型支持后,仍有超过四成的成功参与者能独立完成新项目,这表明他们通过与大语言模型的交互,实质性地提升了对医学AI研究的理解和执行能力,而非简单地复制粘贴。其次,我们捕捉到了潜在的“依赖风险”,这为未来制定合理的使用规范提出了警示。此外,在反复实践中,我们初步总结出了一套名为“CPGI”的提示词指南,即提供详细背景、清晰阐述问题、分解复杂目标和迭代优化,帮助医生更有效地与这位“AI教练”协作。当然,这套指南的有效性还需未来研究进一步验证。

CellPress:

您如何看待“AI for Medical Science”的未来发展?

林浩添教授:

当前,AI已能自主设计实验方案以加速新药筛选,或从海量基因组与临床数据中推断未知的致病机制,提出科学假设。随着LLM驱动的AI Agent等技术的发展,未来的“AI for Medical Science”或将超越工具辅助的范畴,迈向一个由智能体驱动的、自主与协同并存的医学研究新范式。医生与AI的关系,将从“人主导、机执行”转变为“人机协同、共同探索”,这将极大地加速科学发现的迭代周期。

但我们仍要注意其中的风险管控,随着技术的不断迭代,我们需要对技术使用中产生的依赖性问题、AI“幻觉”等风险进行更加长期、持续和全面的评估。其次,技术的价值在于赋能,而非取代。它如何促进而非削弱临床专家与工程专家之间更深层次、更高效的协作,如何整合到真实的团队科研工作流中,从而真正推动可持续的“医工结合”创新,这些都是极具前景且亟待探索的课题。

相关论文信息

相关论文刊载于Cell Press细胞出版社旗下期刊Cell Reports Medicine上,点击“阅读原文”或扫描下方二维码查看论文

▌论文标题:

The effectiveness of large language models in medical AI research for physicians: A randomized controlled trial

▌论文网址:

https://www.sciencedirect.com/science/article/pii/S2666379125005427

▌DOI:

https://doi.org/10.1016/j.xcrm.2025.102469

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-11-28,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读