韩曙亮

作者相关精选

【Groovy】Groovy 脚本调用 ( Groovy 脚本中调用另外一个 Groovy 脚本 | 调用 evaluate 方法执行 Groovy 脚本 | 参数传递 )

前往小程序,Get更优阅读体验!

立即前往

【Groovy】Groovy 脚本调用 ( Groovy 脚本中调用另外一个 Groovy 脚本 | 调用 evaluate 方法执行 Groovy 脚本 | 参数传递 )

韩曙亮

发布于 2023-03-30 02:29:04

发布于 2023-03-30 02:29:04

1.9K00

代码可运行

举报

运行总次数:0

代码可运行

文章目录

一、Groovy 脚本中调用另外一个 Groovy 脚本

1、调用 evaluate 方法执行 Groovy 脚本

在 【Groovy】Groovy 脚本调用 ( Groovy 脚本编译 | Groovy 脚本字节码文件分析 ) 博客中 , 已经分析了 Groovy 脚本的本质 , Groovy 脚本继承了 groovy.lang.Script 类 ;

调用 groovy.lang.Script 类的 evaluate 方法 , 传入 Groovy 脚本文件对应的 File 对象 , 即可执行该 Groovy 脚本 ;

代码语言:javascript

代码运行次数:0

运行

AI代码解释

复制

/**

* 一个助手方法,允许使用此脚本绑定作为变量范围动态计算groovy表达式

*

* @param file 要执行的 Groovy 脚本文件

*/

public Object evaluate(File file) throws CompilationFailedException, IOException {

GroovyShell shell = new GroovyShell(getClass().getClassLoader(), binding);

return shell.evaluate(file);

}代码示例 : 两个 Groovy 脚本都在同一个目录中 ; 在 Groovy 脚本中调用如下代码 , 即可执行另外一个 Groovy 脚本 Script.groovy ;

代码语言:javascript

代码运行次数:0

运行

AI代码解释

复制

evaluate(new File("Script.groovy"))2、参数传递

在 Groovy 脚本中 , 调用另外一个 Groovy 脚本 , 如果要传入参数 , 直接定义 绑定作用域 args 参数 ;

代码语言:javascript

代码运行次数:0

运行

AI代码解释

复制

args = []

args[0] = "arg0"

args[1] = "arg1"这样在被调用的 Groovy 脚本中 , 就可以获取 上述 args 参数 ;

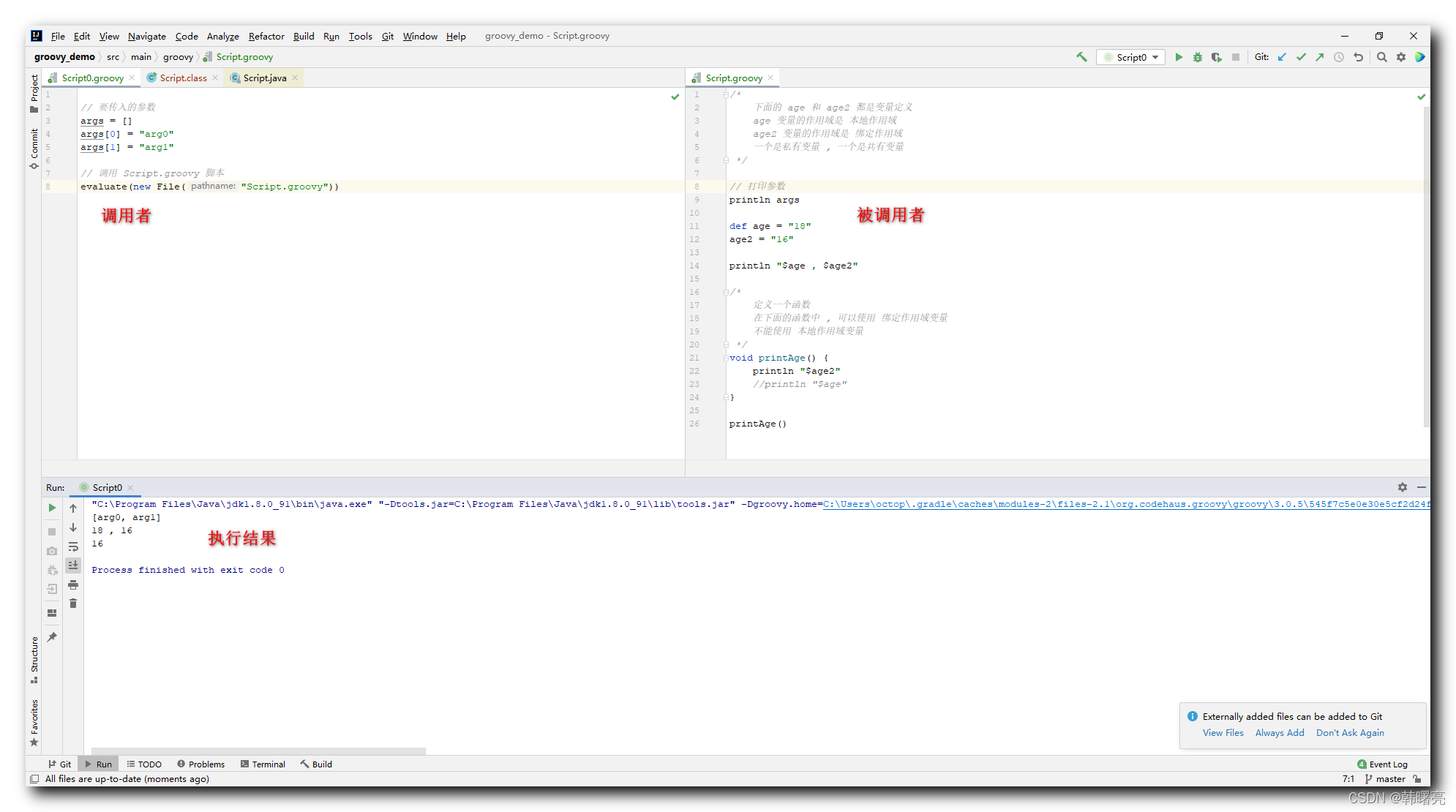

二、完整代码示例

1、调用者 Groovy 脚本

代码语言:javascript

代码运行次数:0

运行

AI代码解释

复制

// 要传入的参数

args = []

args[0] = "arg0"

args[1] = "arg1"

// 调用 Script.groovy 脚本

evaluate(new File("Script.groovy"))2、被调用者 Groovy 脚本

代码语言:javascript

代码运行次数:0

运行

AI代码解释

复制

/*

下面的 age 和 age2 都是变量定义

age 变量的作用域是 本地作用域

age2 变量的作用域是 绑定作用域

一个是私有变量 , 一个是共有变量

*/

// 打印参数

println args

def age = "18"

age2 = "16"

println "$age , $age2"

/*

定义一个函数

在下面的函数中 , 可以使用 绑定作用域变量

不能使用 本地作用域变量

*/

void printAge() {

println "$age2"

//println "$age"

}

printAge()3、执行结果

上面的两个 Groovy 脚本都在相同目录 ;

代码语言:javascript

代码运行次数:0

运行

AI代码解释

复制

[arg0, arg1]

18 , 16

16

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2022-01-14,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

暂无评论

登录 后参与评论

推荐阅读

推荐阅读

Shiro面试题(二十道)[通俗易懂]

1.7K0

Shiro的原理及Web搭建

8270

细说shiro之一:shiro简介

1.2K0

freemarker中使用shiro标签

1.6K0

Shiro的认证与授权流程解析

6360

相关推荐

Shiro框架学习,Shiro JSP标签

更多 >目录

- 文章目录

- 一、Groovy 脚本中调用另外一个 Groovy 脚本

- 1、调用 evaluate 方法执行 Groovy 脚本

- 2、参数传递

- 二、完整代码示例

- 1、调用者 Groovy 脚本

- 2、被调用者 Groovy 脚本

- 3、执行结果

领券

腾讯云开发者

扫码关注腾讯云开发者

领取腾讯云代金券

Copyright © 2013 - 2025 Tencent Cloud. All Rights Reserved. 腾讯云 版权所有

深圳市腾讯计算机系统有限公司 ICP备案/许可证号:粤B2-20090059 深公网安备号 44030502008569

腾讯云计算(北京)有限责任公司 京ICP证150476号 | 京ICP备11018762号 | 京公网安备号11010802020287

Copyright © 2013 - 2025 Tencent Cloud.

All Rights Reserved. 腾讯云 版权所有

登录 后参与评论

4