我不明白为什么scala spark的jupyter内核一直被中断

我不明白为什么scala spark的jupyter内核一直被中断

提问于 2020-06-08 23:35:58

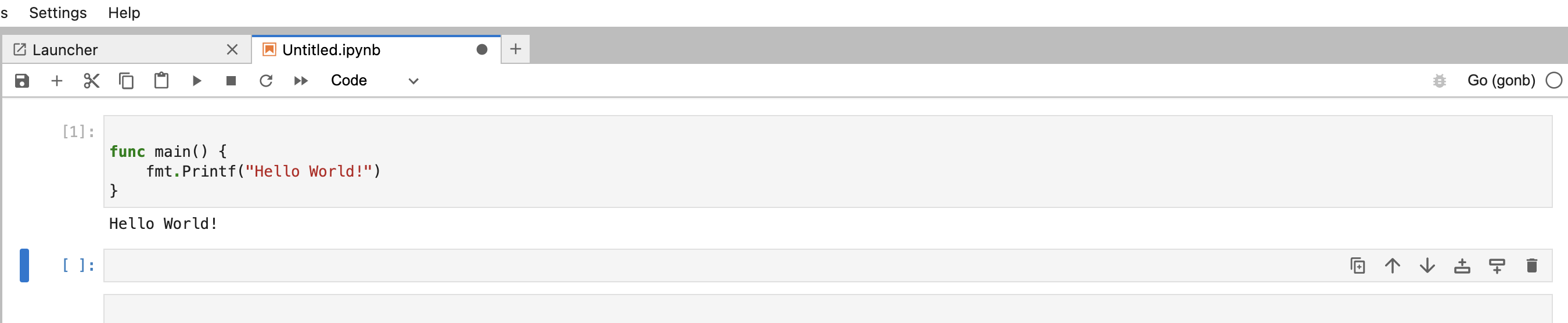

我曾经干净利落地安装了spylon内核,应该是在升级到干净的18.04版本之后。我正在努力让spylon内核正常工作。屏幕截图基本上是在启动时退出spark shell,正如您可以看到的"scala> :quit“,并且这种情况不断发生,无限地重复发生。

我尝试过pip安装,也尝试过conda安装spylon内核,但它根本不起作用。下面是kernel.json文件的内容。

{

"display_name": "sparky",

"language": "scala",

"argv": [

"/home/ops/Documents/spark-3.0.0-preview2-bin-hadoop2.7/bin/spark-shell",

"{connection_file}"

],

"env": {

"SPARK_HOME": "/home/ops/Documents/spark-3.0.0-preview2-bin-hadoop2.7/"

}

}ops@ops-XPS-15-9560:~/.ipython/kernels$ jupyter kernelspec list

Available kernels:

python2 /home/ops/.local/share/jupyter/kernels/python2

python3 /home/ops/.local/share/jupyter/kernels/python3

spylon_kernel /home/ops/.local/share/jupyter/kernels/spylon_kernel

ops@ops-XPS-15-9560:~/.ipython/kernels$ 所以安装也很好,spark-shell本身也运行得很好

回答 1

Stack Overflow用户

发布于 2020-06-09 17:42:53

使用python3完成anaconda的完整安装,并使用pip完成安装。

页面原文内容由Stack Overflow提供。腾讯云小微IT领域专用引擎提供翻译支持

原文链接:

https://stackoverflow.com/questions/62272794

复制相似问题