java.lang.ClassNotFoundException: org.apache.spark.sql.Dataset

提问于 2016-07-08 14:17:26

当运行一个使用Spark Dataset类型的Scala文件时,我得到以下堆栈跟踪:

Exception in thread "main" java.lang.NoClassDefFoundError: org/apache/spark/sql/Dataset

at java.lang.Class.getDeclaredMethods0(Native Method)

at java.lang.Class.privateGetDeclaredMethods(Class.java:2701)

at java.lang.Class.privateGetMethodRecursive(Class.java:3048)

at java.lang.Class.getMethod0(Class.java:3018)

at java.lang.Class.getMethod(Class.java:1784)

at com.intellij.rt.execution.application.AppMain.main(AppMain.java:125)

Caused by: java.lang.ClassNotFoundException: org.apache.spark.sql.Dataset

at java.net.URLClassLoader.findClass(URLClassLoader.java:381)

at java.lang.ClassLoader.loadClass(ClassLoader.java:424)

at sun.misc.Launcher$AppClassLoader.loadClass(Launcher.java:331)

at java.lang.ClassLoader.loadClass(ClassLoader.java:357)

... 6 more我觉得这很奇怪,因为我有以下导入:

import org.apache.spark.sql._此外,在我的build.sbt中,我在libraryDependencies中添加了以下内容

"org.apache.spark" %% "spark-core" % "1.6.2" % "provided",

"org.apache.spark" %% "spark-sql" % "1.6.2" % "provided",回答 4

Stack Overflow用户

回答已采纳

发布于 2016-07-08 14:24:03

如果您正在执行此独立程序,您可以尝试从依赖项中删除provided。提供意味着当您运行此应用程序时,您希望依赖项已经在类路径上。因此,如果您使用provided,那么Spark依赖项将不会包含在您的jar中。

Stack Overflow用户

发布于 2019-11-07 12:51:01

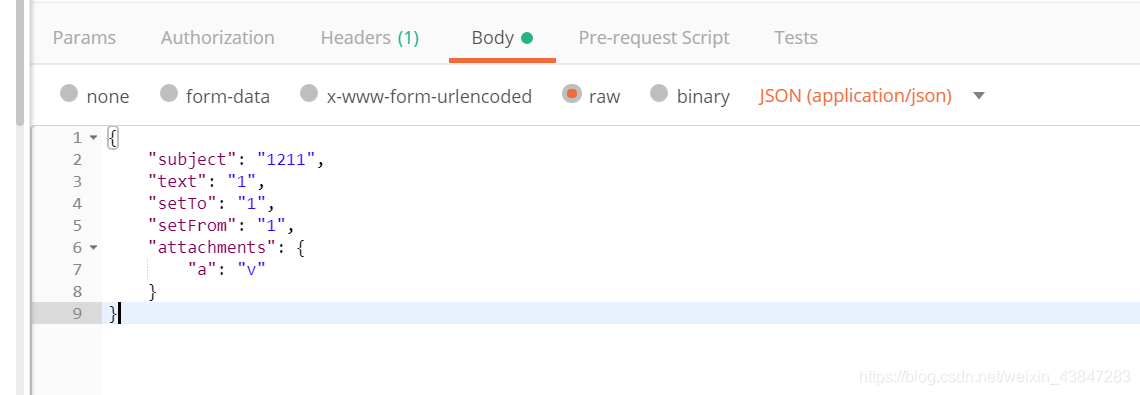

选中“在运行/调试配置中包含具有”提供的“作用域的依赖项”复选框。

Stack Overflow用户

发布于 2017-11-02 21:36:34

您的build.sbt文件指定将spark依赖项提供给应用程序的类路径,但它无法找到它们。如果您没有在集群上运行,那么您可以尝试从build.sbt中删除“提供的”,或者将Spark依赖项放在类路径中。

页面原文内容由Stack Overflow提供。腾讯云小微IT领域专用引擎提供翻译支持

原文链接:

https://stackoverflow.com/questions/38268922

复制相关文章