哪个是八度正则化的正确实现?

哪个是八度正则化的正确实现?

提问于 2020-09-22 11:58:13

我目前正在学习Andrew Ng的机器学习课程,我试着在学习的过程中实现这些东西,这样就不会忘记它们,我刚刚完成了正则化(第7章)。我知道theta 0是正常更新的,独立于其他参数,然而,我不确定这些参数中的哪一个是正确的实现。

实现1:在我的梯度函数中,在计算正则化向量后,将θ0部分更改为0,因此当它被添加到总数时,就好像θ0从未被正则化过。

实现2:将theta存储在temp变量:_theta中,用reg_step 0更新它(这样就好像没有正则化一样),将新的theta 0存储在temp变量: t1中,然后用我想要的reg_step更新原始的theta值,并用t1 (来自非正则化更新的值)替换theta 0。

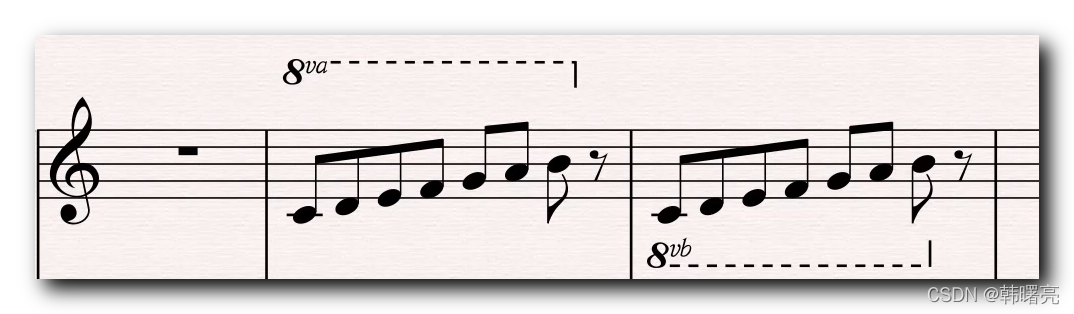

下面是我的第一个实现的代码,它不是高级的,我只是在练习:我使用的是八度,它是1-index,所以theta(1)是theta(0)

function ret = gradient(X,Y,theta,reg_step),

H = theta' * X;

dif = H-Y;

mul = dif .* X;

total = sum(mul,2);

m=(size(Y)(1,1));

regular = (reg_step/m)*theta;

regular(1)=0;

ret = (total/m)+regular,

endfunction提前谢谢。

回答 1

Stack Overflow用户

回答已采纳

发布于 2020-10-17 08:10:26

对第一个实现稍作调整就可以了。

首先,计算每个theta的正则化。然后继续执行梯度步骤,稍后您可以手动更改包含梯度的矩阵的第一个条目,以忽略theta_0的正则化。

% Calculate regularization

regularization = (reg_step / m) * theta;

% Gradient Step

gradients = (1 / m) * (X' * (predictions - y)) + regularization;

% Ignore regularization in theta_0

gradients(1) = (1 / m) * (X(:, 1)' * (predictions - y));页面原文内容由Stack Overflow提供。腾讯云小微IT领域专用引擎提供翻译支持

原文链接:

https://stackoverflow.com/questions/64009278

复制相关文章

相似问题

表单主题化:哪个是正确的ID?

哪个ER是正确的?

静态变量的哪个初始化是正确的

什么是MATLAB离散化的八度等效?

哪个规范链接是正确的

社区富文本编辑器全新改版!诚邀体验~

全新交互,全新视觉,新增快捷键、悬浮工具栏、高亮块等功能并同时优化现有功能,全面提升创作效率和体验