[机器学习算法]XGBoost

[机器学习算法]XGBoost

简介

XGBoost算法是以CART为基分类器的集成学习方法之一,由于其出色的运算效率和预测准确率在数据建模比赛中得到广泛的应用。与随机森林赋予每一颗决策树相同的投票权重不同,XGBoost算法中下一棵决策树的生成和前一棵决策树的训练和预测相关(通过对上一轮决策树训练准确率较低的样本赋予更高的学习权重来提高模型准确率)。相比于其他集成学习算法,XGBoost一方面通过引入正则项和列抽样的方法提高了模型稳健性,另一方面又在每棵树选择分裂点的时候采取并行化策略从而极大提高了模型运行的速度。

需要提前了解的知识

关于

XGBoost本身的原理及相关知识,陈天奇的课件已经写得很完善了,只不过我一直都喜欢将他人的知识用自己的语言阐述从而内化吸收的笨方法。

1.监督学习的相关概念

监督学习简单理解就是研究自带训练标签的数据,通过构造一个目标函数来描述自变量和因变量的映射关系。其中目标函数可抽象为训练误差

和正则项

之和:

其中

叫做损失函数,衡量了预测值和真实值的偏差程度;

叫做正则项,

取值一般为

(

正则项)或者

(

正则项)。

2.分类与回归树CART

CART树本身的原理我在此前的文章已经阐述地比较清楚了,这里不再赘述。

3.泰勒展开式

当

在

处具有

阶连续导数,我们可以用

的

次多项式逼近函数

公式:

其中

表示泰勒余项,它是

的高阶无穷小。

模型建立与目标函数

XGBoost本身属于监督学习,假设XGBoost模型本身由

棵CART构成,那么模型可表示如下,其中

表示第

棵树,

表示第

个样本在第

棵树的得分:

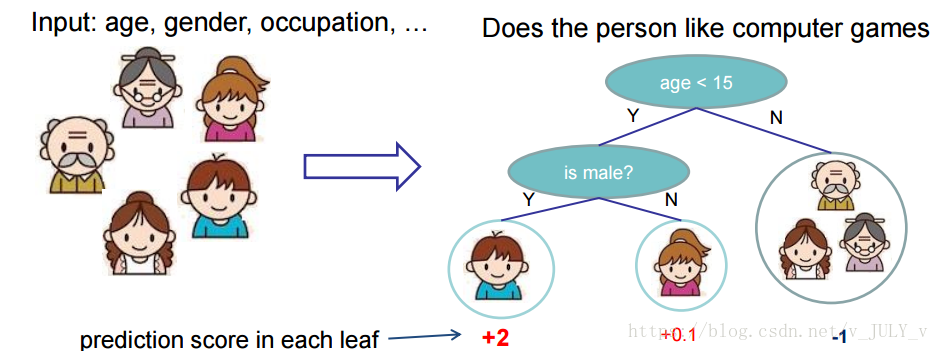

需要注意的是,XGBoost中基分类树每个叶子节点都会给出对应的得分,通过加总多棵树的得分实现集成学习。下图以“一个人是否喜欢玩电脑游戏”展示了多棵树如何进行预测(预测分值越高表示越喜欢玩游戏):

image.png

image.png

同大部分机器学习模型一样,XGBoost的目标函数也能表示为损失函数和正则项之和,分别控制模型的准确度和复杂度(这两者往往难以同时最优化,需要进行权衡):

参数优化思路

按照机器学习的思路,给出具体的目标函数之后就是参数求解的过程(通过求解参数表达式使损失函数最小化)。由于

,XGBoost模型的参数

即

棵CART树组成的向量:

模型的损失函数值

越小表明模型的拟合效果越佳,正则项

越小表明模型的复杂度越低,因此我们的目的就是最小化目标函数

从而求解出参数向量

。 接下来就是如何描述一棵树

的问题,要确定一棵树需要如下两方面的内容:

- 树的结构,即将样本映射到不同叶子节点的函数

- 各个叶子节点的分数

在不清楚每棵树的具体结构情况下,直接最优化目标函数是不可能的,XGBoost利用加法模型简化模型目标函数,在前一棵CART基础上训练下一棵决策树:

参数估计

将目标函数最优化的过程通过贪心算法的思想转化为

轮迭代,其中第

轮迭代时的目标函数可表示为:

考虑以均方误差作为损失函数,我们可以将目标函数表示为:

仔细观察上述这个式子,由于求解

时前一棵树

是已知的,因此

也就是常量。因此

就是关于

的二次表达式,为后续的参数求解提供便利。

就是第

棵树由样本集到叶子节点的映射函数,

就是样本对应的某个叶子节点的分数值。

在机器学习竞赛中用过XGBoost的小伙伴肯定还知道该算法可以自定义损失函数,对于一般的损失函数,我们人为定义损失函数一阶微分和二阶微分:

利用泰勒展开式我们可以把目标函数近似化简为:

之前我们提到一棵树

可由它的结构(即样本到叶子节点的映射函数)和每个叶子节点上的分数唯一确定,现在我们给出第

棵树的描述函数:

其中

表示树的结构,

表示每个叶子节点的分数的

维向量,

和

分别表示训练数据集特征维度和叶子节点数。

image.png

我们再定义树的复杂度

为:

上式出现的

和

都是自定义惩罚系数,前者用于控制叶子节点的个数,后者用于控制参数向量的模,两者都是在约束CART的复杂度。

代入

的定义到目标函数中,再定义映射到叶子节点

的样本集合为

:

每一轮迭代中

和

在给定损失函数下都相当于是常量,其中

表示训练集样本量,我们人为定义

和

再一次精简一下目标函数:

基于二次函数最优化,我们可以求解出参数和目标函数的最优值:

如何确定树的复杂度

在上一步参数估计中,我们构造了映射到第

个叶子节点的样本集合

,这相当于我们在已知每棵树结构的基础上进行参数估计。

当特征维度较大时,树的结构难以穷尽,因此XGBoost借助普通决策树的贪心算法思路求解“最优”的结构,即从深度为

开始,每次split对目标函数的影响为:

中括号内第一部分表示split后左叶子节点的得分,第二部分表示右叶子节点的得分,第三部分表示不进行split的得分。

是我们引入的复杂度惩罚因子,衡量了额外叶子节点带来的复杂度损失。

自此求解最优树结构的思想和CART几乎一致,这里便不再赘述。求解完树结构后,根据前面参数估计的内容我们可以很方便地给出来每个叶子节点的权重。

Reference

[1] https://xgboost.readthedocs.io/en/latest/tutorials/model.html

- 简介

- 需要提前了解的知识

- 1.监督学习的相关概念

- 2.分类与回归树CART

- 3.泰勒展开式

- 模型建立与目标函数

- 参数优化思路

- 参数估计

- 如何确定树的复杂度

- Reference

腾讯云开发者

扫码关注腾讯云开发者

领取腾讯云代金券

Copyright © 2013 - 2025 Tencent Cloud. All Rights Reserved. 腾讯云 版权所有

深圳市腾讯计算机系统有限公司 ICP备案/许可证号:粤B2-20090059 深公网安备号 44030502008569

腾讯云计算(北京)有限责任公司 京ICP证150476号 | 京ICP备11018762号 | 京公网安备号11010802020287

Copyright © 2013 - 2025 Tencent Cloud.

All Rights Reserved. 腾讯云 版权所有