机器学习(32)之典型相关性分析(CCA)详解 【文末有福利......】

机器学习(32)之典型相关性分析(CCA)详解 【文末有福利......】

关键字全网搜索最新排名

【机器学习算法】:排名第一

【机器学习】:排名第一

【Python】:排名第三

【算法】:排名第四

人工智能与Python公开课

限时免费

文末领取

前言

典型关联分析(Canonical Correlation Analysis,简称CCA)是最常用的挖掘数据关联关系的算法之一。比如我们拿到两组数据,第一组是人身高和体重的数据,第二组是对应的跑步能力和跳远能力的数据。那么我们能不能说这两组数据是相关的呢?CCA可以帮助我们分析这个问题。

CCA概述

在数理统计里面,都知道相关系数这个概念。假设有两组一维的数据集X和Y,则相关系数ρ的定义为:

其中cov(X,Y)是X和Y的协方差,而D(X),D(Y)分别是X和Y的方差。相关系数ρ的取值为[-1,1], ρ的绝对值越接近于1,则X和Y的线性相关性越高。越接近于0,则X和Y的线性相关性越低。

虽然相关系数可以很好的帮我们分析一维数据的相关性,但是对于高维数据就不能直接使用了。如上所述,如果X是包括人身高和体重两个维度的数据,而Y是包括跑步能力和跳远能力两个维度的数据,就不能直接使用相关系数的方法。那我们能不能变通一下呢?CCA给了我们变通的方法。

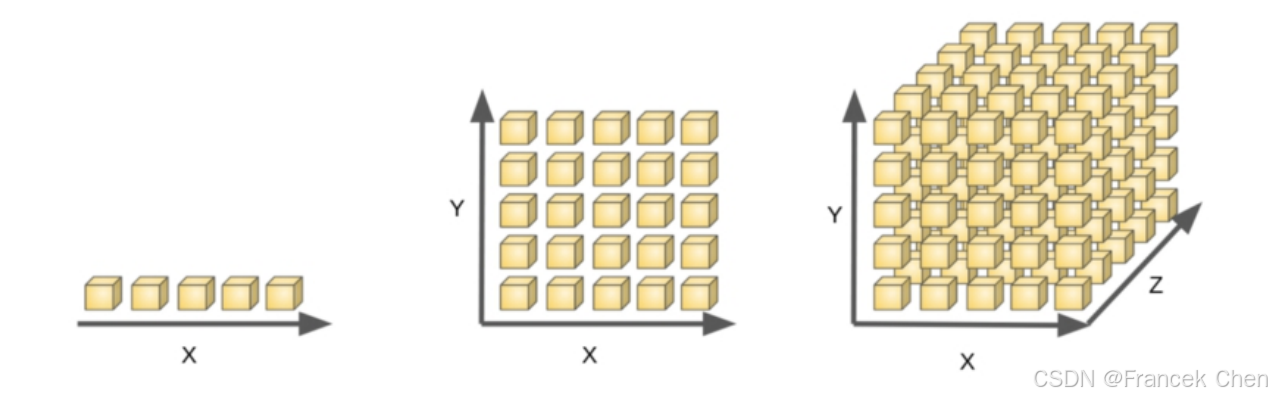

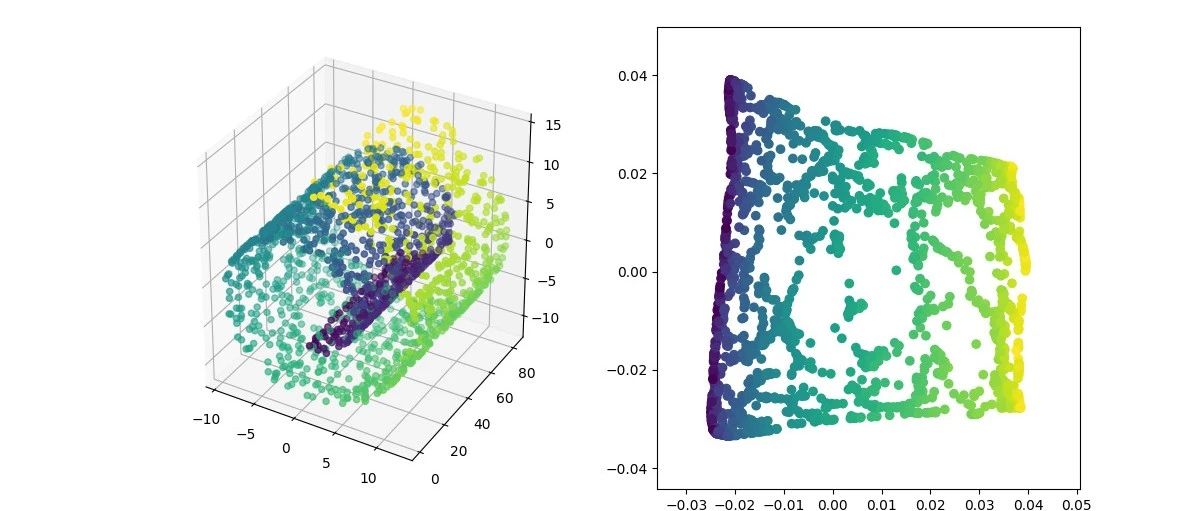

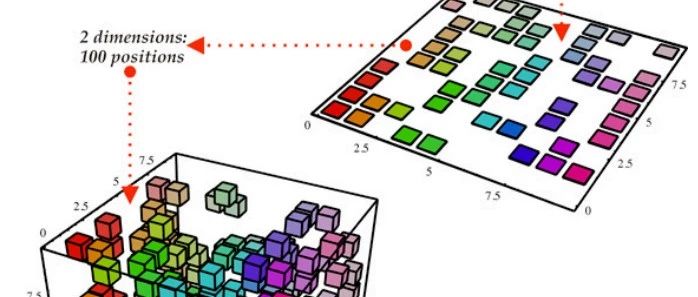

CCA使用的方法是将多维的X和Y都用线性变换为1维的X'和Y',然后再使用相关系数来看X'和Y'的相关性。将数据从多维变到1位,也可以理解为CCA是在进行降维,将高维数据降到1维,然后再用相关系数进行相关性的分析。

CCA算法思想

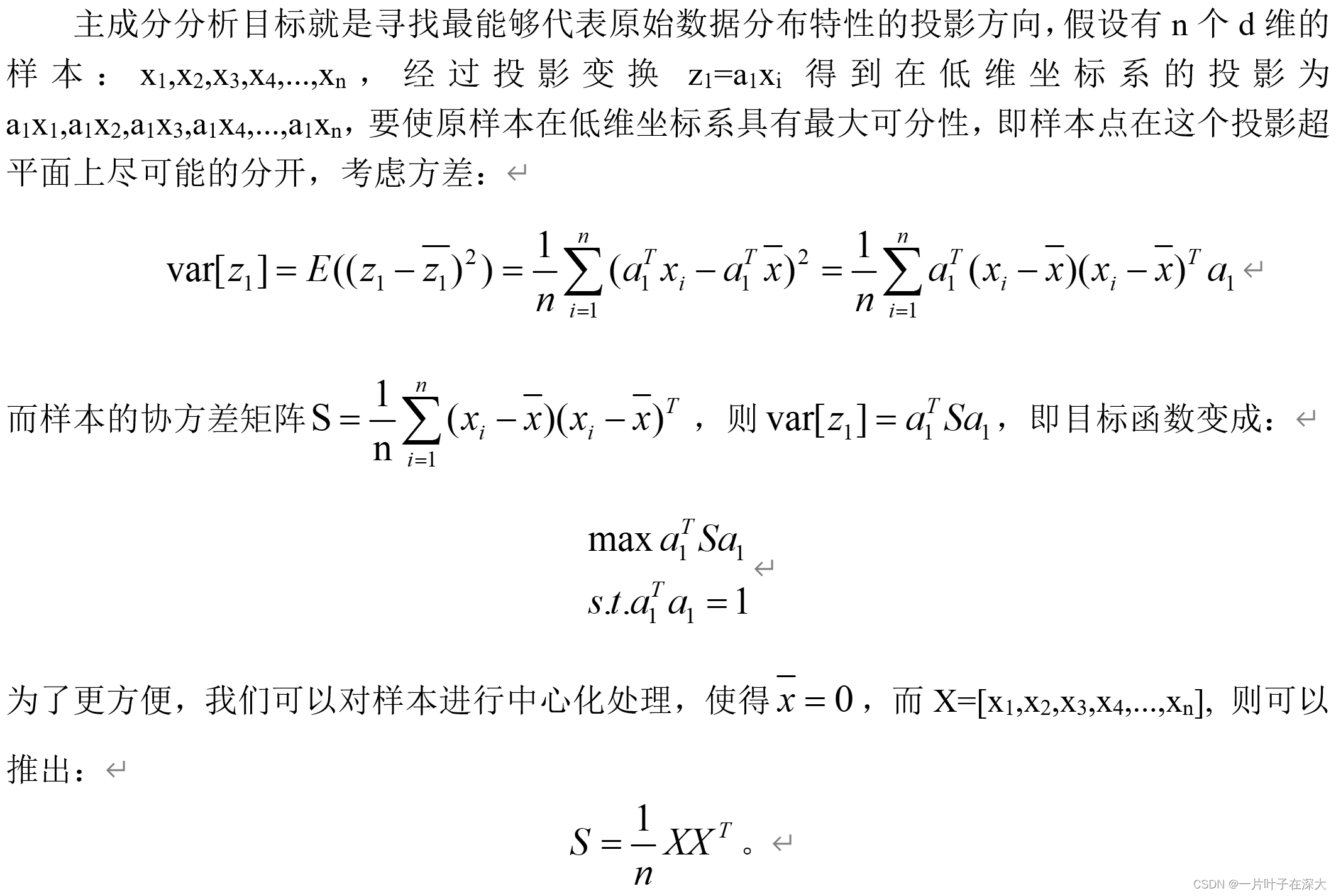

上面提到CCA是将高维的两组数据分别降维到1维,然后用相关系数分析相关性。但是有一个问题是,降维的标准是如何选择的呢?回想下主成分分析PCA,降维的原则是投影方差最大;再回想下线性判别分析LDA,降维的原则是同类的投影方差小,异类间的投影方差大。对于我们的CCA,它选择的投影标准是降维到1维后,两组数据的相关系数最大。

假设数据集是X和Y,X为n1×m的样本矩阵,Y为n2×m的样本矩阵.其中m为样本个数,而n1,n2分别为X和Y的特征维度。对于X矩阵,将其投影到1维,对应的投影向量为a, 对于Y矩阵,将其投影到1维,对应的投影向量为b, 这样X ,Y投影后得到的一维向量分别为X',Y'。我们有

CCA的优化目标是最大化ρ(X′,Y′),得到对应的投影向量a,b,即

在投影前,一般会把原始数据进行标准化,得到均值为0而方差为1的数据X和Y。这样我们有:

由于X,Y的均值均为0,则

令SXY=cov(X,Y),则优化目标可以转化为:

由于分子分母增大相同的倍数,优化目标结果不变,我们可以采用和SVM类似的优化方法,固定分母,优化分子,具体的转化为:

进而CCA算法的目标最终转化为一个凸优化过程,只要求出了这个优化目标的最大值,就是前面提到的多维X和Y的相关性度量,而对应的a,b则为降维时的投影向量。

这个函数优化一般有两种方法,第一种是奇异值分解SVD,第二种是特征分解,两者得到的结果一样。

SVD求解CCA

对于上面的优化目标,可以做一次矩阵标准化后在使用SVD来求解。

首先令

进而

优化目标变成下式:

可以看出,SVD的求解方式非常简洁方便。但如果不熟悉SVD的话,也可以用传统的拉格朗日函数加上特征分解来完成这个函数的优化。

特征值分解求CCA

特征分解方式比较传统,利用拉格朗日函数,优化目标转化为最大化下式:

分别对a,b求导并令结果为0得:

进而

现在拉格朗日系数就是我们要优化的目标。继续将上面的两个式子做整理得:

将上面第二个式子带入第一个式子得到

要求最大的相关系数λ,只需要对上面的矩阵做特征分解,找出最大的特征值取平方根即可,此时最大特征值对应的特征向量即为X的线性系数a。同样的办法,可以找到最大特征值对应的特征向量即为Y的线性系数b。

可以看出特征分解的方法要比SVD复杂,但是两者求得的结果其实是等价的,只要利用SVD和特征分解之间的关系就很容易发现两者最后的结果相同。

CCA算法流程

对CCA算法流程做一个归纳,以SVD方法为例:

输入:各为m个的样本X和Y,X和Y的维度都大于1

输出:X,Y的相关系数ρ,X和Y的线性系数向量a和b

流程

1)计算X的方差SXX, Y的方差SYY,X和Y的协方差SXY

2) 计算矩阵

3)对矩阵M进行奇异值分解,得到最大的奇异值ρ,和最大奇异值对应的左右奇异向量

4) 计算X和Y的线性系数向量a和b,

总结

CCA算法广泛的应用于数据相关度的分析,同时还是偏最小二乘法的基础。但是由于它依赖于数据的线性表示,当我们的数据无法线性表示时,CCA就无法使用,此时我们可以利用核函数的思想,将数据映射到高维后,再利用CCA的思想降维到1维,求对应的相关系数和线性关系,这个算法一般称为KCCA。此外,在算法里只找了相关度最大的奇异值或者特征值,作为数据的相关系数,实际上我们也可以像PCA一样找出第二大奇异值,第三大奇异值,。。。得到第二相关系数和第三相关系数。然后对数据做进一步的相关性分析。但是一般的应用来说,找出第一相关系数就可以了。

欢迎分享给他人让更多的人受益

参考:

- 周志华《机器学习》

- Neural Networks and Deep Learning by By Michael Nielsen

- 博客园 http://www.cnblogs.com/pinard/p/6288716.html

- 李航《统计学习方法》

- Deep Learning, book by Ian Goodfellow, Yoshua Bengio, and Aaron Courville

本文分享自 机器学习算法与Python学习 微信公众号,前往查看

如有侵权,请联系 cloudcommunity@tencent.com 删除。

本文参与 腾讯云自媒体同步曝光计划 ,欢迎热爱写作的你一起参与!

腾讯云开发者

扫码关注腾讯云开发者

领取腾讯云代金券

Copyright © 2013 - 2025 Tencent Cloud. All Rights Reserved. 腾讯云 版权所有

深圳市腾讯计算机系统有限公司 ICP备案/许可证号:粤B2-20090059 深公网安备号 44030502008569

腾讯云计算(北京)有限责任公司 京ICP证150476号 | 京ICP备11018762号 | 京公网安备号11010802020287

Copyright © 2013 - 2025 Tencent Cloud.

All Rights Reserved. 腾讯云 版权所有